生成AI

最終更新日:2025/02/04

Sakana AI SLM日本語モデル発表

Sakana AI SLM日本語モデル発表

Sakana AIは、小規模ながらも高性能な日本語言語モデル「TinySwallow-1.5B」を開発したと発表しました。

このニュースのポイント

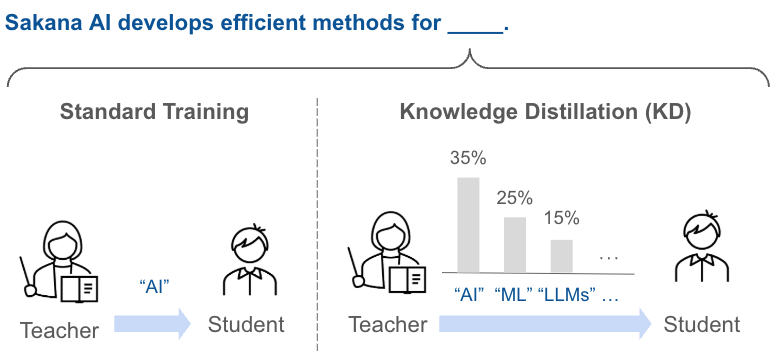

Sakana AI株式会社は、小規模ながらも高性能な日本語言語モデル「TinySwallow-1.5B」を開発したと発表しました。このモデルは、新しい知識蒸留手法「TAID(Temporally Adaptive Interpolated Distillation)」によって学習され、同規模のモデルの中で最高水準の性能を達成しています。

従来、LLMの開発・活用現場では莫大な計算資源を必要とするため、計算リソースの問題で困難な状況に置かれていました。そこでTAIDの活用により、小規模ながら優れた性能を持つモデルを作り出すことに成功しました。

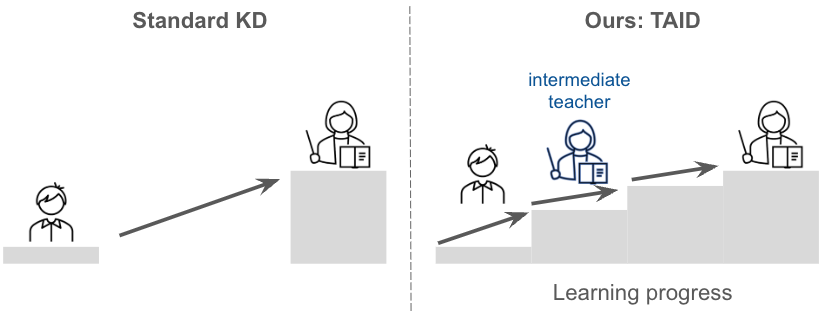

TAIDは、高性能なLLM(教師モデル)をSLM(生徒モデル)に転移させる知識蒸留の新たな手法を取り入れています。既存の知識蒸留の手法とは異なり、SLMの学習過程に応じて段階的にLLMの知識を転移。SLMの学習進度に応じて段階的に適切な「中間教師」を設定し、徐々に高度な知識を学習させることで問題を克服しました。

この方法により、効率的に知識を転移させることが可能となり、小規模なモデルでありながら高い性能を発揮できるようになりました。

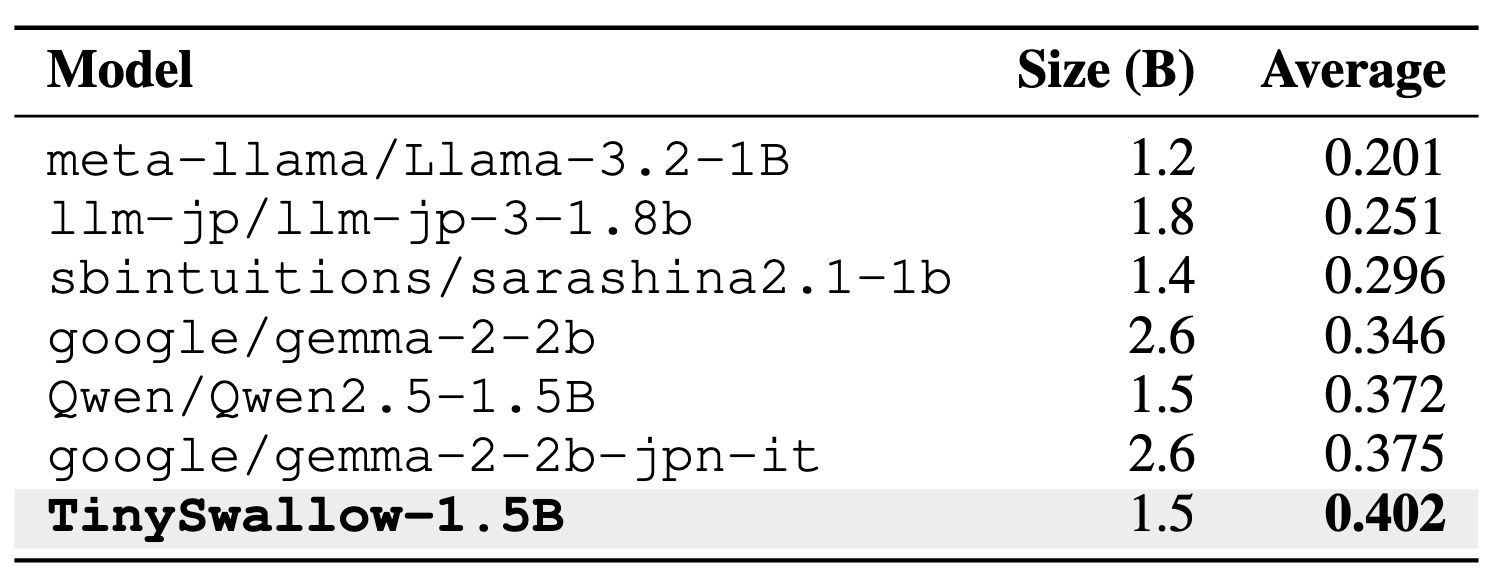

「TinySwallow-1.5B」は、TAIDを活用して開発された日本語言語モデルです。約32Bパラメータの大規模モデルから1.5Bパラメータの小規模モデルへ知識を転移することで構築されました。その結果、日本語の言語モデルのベンチマークにおいて、同規模のモデルの中で最高性能を達成しました。

また、スマートフォンやPCでも動作が可能となり、ウェブアプリ「TinySwallow ChatUI」ではブラウザ上で直接モデルを動作させるため、APIを介さずにオフラインで利用することができます。

さらに、完全にオフラインで実行できる「TinySwallow ChatUI Local」も提供。Pythonベースのシンプルなインターフェースで、ネットワーク接続せずにチャットすることが可能です。

「TinySwallow-1.5B」のモデルデータは、現在「Hugging Face Hub」にて公開されています。Sakana AIは、今後も知識蒸留の可能性をさらに広げ、より多くの人が高性能なAIを身近に活用できる環境を目指して研究を続けていく方針です。

出典:Sakana AI

業務の課題解決に繋がる最新DX・情報をお届けいたします。

メールマガジンの配信をご希望の方は、下記フォームよりご登録ください。登録無料です。

AI製品・ソリューションの掲載を

希望される企業様はこちら