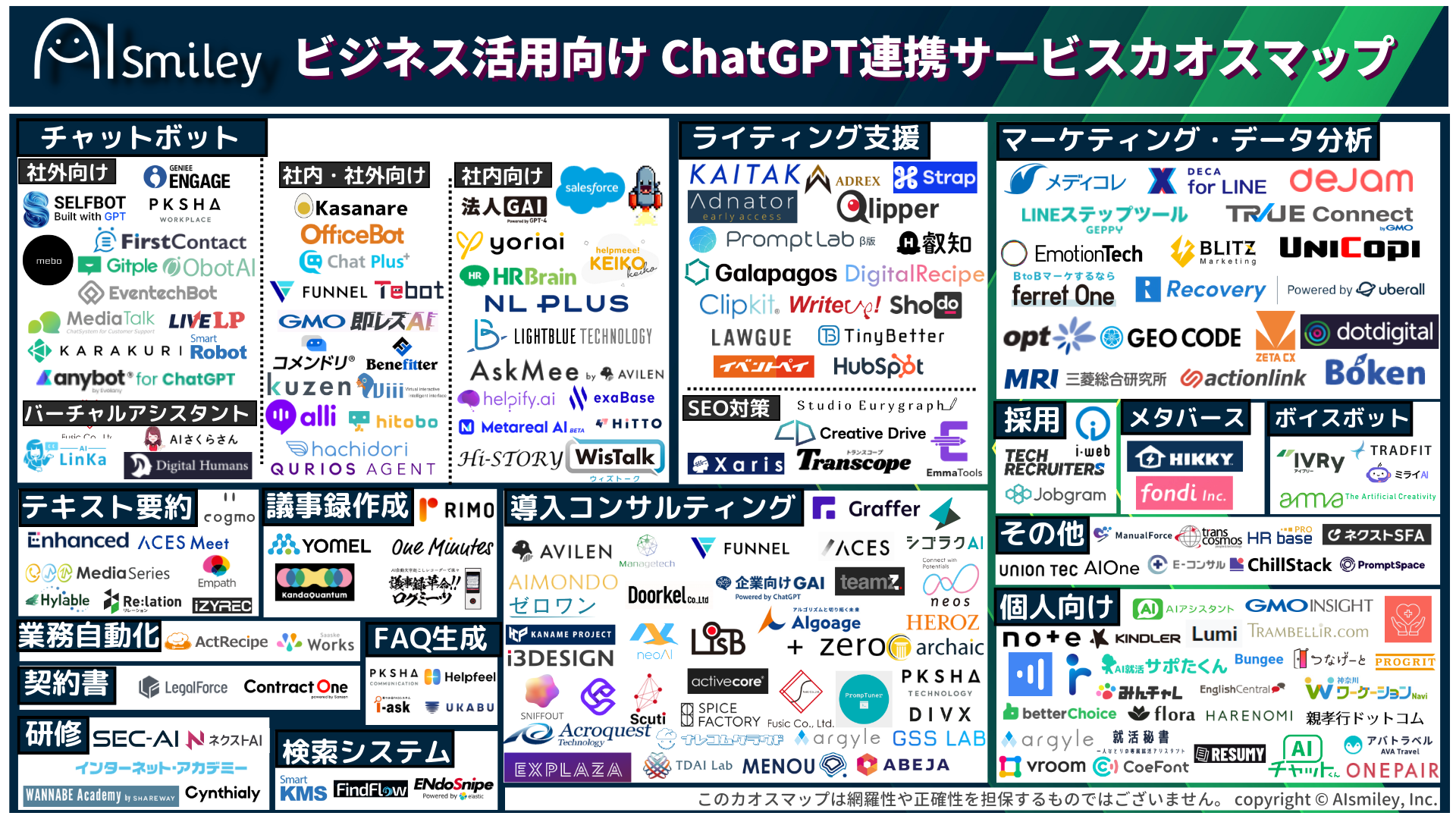

ChatGPT連携サービス

生成AI

生成AI

ChatGPT連携サービス

ChatGPT連携サービス

AI受託開発

AI受託開発

対話型AI -Conversational AI-

対話型AI -Conversational AI-

ボイスボット

ボイスボット

バーチャルヒューマン

バーチャルヒューマン

教師データ作成

教師データ作成

ナレッジマネジメントツール

ナレッジマネジメントツール

AI研究開発

AI研究開発

通訳・翻訳

通訳・翻訳

声紋認証

声紋認証

機密情報共有・管理

機密情報共有・管理

契約書管理システム

契約書管理システム

ワークステーション

ワークステーション

FAQシステム

FAQシステム

AIカメラ

AIカメラ

生体認証

生体認証

インボイス制度対応システム

インボイス制度対応システム

データセットの収集・購入

データセットの収集・購入

コールセンター

コールセンター

人事・総務向け

人事・総務向け

インバウンド対策

インバウンド対策

コンバージョンアップ

コンバージョンアップ

KYT・危険予知で労働災害防止

KYT・危険予知で労働災害防止

無料AI活用

無料AI活用

顧客リスト自動生成

顧客リスト自動生成

ロボットで自動化

ロボットで自動化

LINE連携

LINE連携

セキュリティー強化

セキュリティー強化

テレワーク導入

テレワーク導入

AI学習データ作成

AI学習データ作成

配送ルート最適化

配送ルート最適化

非接触AI

非接触AI

受付をAIで自動化、効率化

受付をAIで自動化、効率化

AIリテラシーの向上サービス

AIリテラシーの向上サービス

日本語の手書き文字対応AI-OCR

日本語の手書き文字対応AI-OCR

Windows作業の自動化RPAツール

Windows作業の自動化RPAツール

リスク分析AIで与信管理

リスク分析AIで与信管理

紙帳票仕分けAI-OCRサービス

紙帳票仕分けAI-OCRサービス

サプライチェーン

サプライチェーン

自治体向けAI

自治体向けAI

AIコンサルティング

AIコンサルティング

最終更新日:2024/02/14

2022年8月頃を皮切りに日本にも上陸した画像生成AI。巷では話題になっているものの、「時代のスピードについていけない」「英文を使うから自分には画像は作れない」といった声もお聞きします。そこで今回はアイスマイリーの編集部が画像生成AI「Stable Diffusion」をHugging Face、Dream Studio、Mageを使って体験してみましたので、ぜひ画像生成AI体験の参考にしてください。

生成AIについて詳しく知りたい方は以下の記事もご覧ください。

生成AI(ジェネレーティブAI)とは?種類・使い方・できることをわかりやすく解説

画像生成AIとは、ユーザーが入力したテキストを頼りに、AIがオリジナルの画像を数秒~数十秒程度で自動生成するシステムを指します。日本でよく知られている画像生成AIには「Stable Diffusion(ステーブルディフュージョン)」や「Midjourney(ミッドジャーニー)」があり、デザイン業界の常識を覆す存在として注目を浴びています。

これまで自分自身で画像を作成できなかったユーザーや、画像素材サイト等で月額利用料を払って高品質な画像をダウンロードしていたユーザーにとって、画像生成AIはメリットの大きいものとして捉えられる傾向にあります。しかし、画像や絵を作り出してきたクリエイターや、風景や人物を撮影してきたカメラマンにとっては脅威と認識されており、今後のデジタルクリエイティブに大きな影響を与える存在となっています。

また、画像生成AIで作成された画像を巡り、AIイラストメーカーの「mimic」は、サービス提供のわずか1日後にサービス停止に追い込まれる事態に発展するなど、画像生成AIを取り巻く著作権問題も話題となりました。基本的に画像生成AIで作成される画像の著作権は「画像を生成したユーザー」に帰属するため、作成する画像の元となるイラストの作者にとっては「自身が作ったイラストとそっくりな画像が大量にWeb上で作成される事態」となり、既にクリエイターの領域を脅かしてしまっています。

関連:イラストを自動生成するAI「mimic」は違法なのか。画像生成AIモデルと著作権

AIイラストメーカーの「mimic」のように、クリエイターの批判を受けてサービス停止に追い込まれる画像生成AIもあれば、今回紹介する「Stable Diffusion」のように、オープンソースAIとして世の中に広く普及した画像生成AIもあります。あくまで現段階での考察になりますが、両者の差は「搭載された訓練済AIモデルの違い」や「画像生成AIに読み込ませるデータの違い」にあると考えられます。実際、広く普及しているStable DiffusionやMidjourneyはテキスト(prompt)を利用して画像を生成しており、ユーザーが入力する文字列から幅広い画像を生み出せる性質から、上述の「mimic」で指摘された著作権の問題を回避できているといえます。

ただしStable Diffusionでも、商用利用が認められていない画像を読み込ませた場合や、商用利用が認められていないAIモデルを追加学習させた場合などは、著作権侵害や利益侵害などのリスクを負ってしまいます。Stable Diffusionにテキストを入力して画像を出力・生成する場合は問題ありませんが、後述する「Stable Diffusion web UI」のimg2imgに画像を読み込ませて新たに画像を生成する機能を使った場合は商用利用ができないケースがあることを覚えておきましょう。

そして、Stable Diffusionに限らず、画像生成AIの多くは「入力する文字列が長ければ長いほど」、また「単語の数が多ければ多いほど」、ユーザーのイメージに近い画像を生成します。そうした事情から「画像生成AIに高品質な画像を作成させるためのプロンプト(呪文)」を専門に作成・研究する「プロンプトエンジニアリング」とよばれる仕事も登場し、日々様々なタイプの画像が作り出されている状況が生まれています。

今回ご紹介する画像生成AIは「Stable Diffusion」です。Stable Diffusionは「入力されたテキスト」をもとに画像を生成する「訓練済のAIモデル(Diffusion Model)」を搭載した画像生成AIで、ユーザーは作成したい画像のイメージ(例えば、アマゾンのジャングル、高層ビルが建ち並ぶ都会、など)を英単語で区切って入力することで、様々な画像を作成できます。

Stable Diffusionで作られる画像は、システムに搭載された「潜在拡散モデル」というアルゴリズムによって生成されています。ユーザーはその潜在拡散モデルが訓練済モデルとして搭載されたシステムを利用するため、アルゴリズムを理解したり、Google Colaboratoryなどの環境でプログラムコードを記述したりすることなく、テキスト入力の操作だけで様々な画像を生み出せます。

ユーザーが行う基本操作は「Stable Diffusionを提供する各インターフェースでテキスト入力を行うだけ」です。各インターフェースごとにテキスト以外の細かなカスタムオプションが搭載されていますが、画像生成の大部分が「入力するテキスト(prompt)」に依存しています。そのため「英文作成が得意なユーザー」はより正確で高品質な画像を生み出せる可能性が高く、Stable Diffusionを使ってイメージに近い画像が生成できるでしょう。

先述したように、Stable Diffusionは潜在拡散モデルが搭載されたシステムで、かつオープンソースAIであるため、Web上に構築された環境で動作させたり、ローカル環境で独自に動かしたりすることが可能です。

このあと使い方を実演する環境は「Webアプリケーション上の環境」(ブラウザ)です。Webアプリケーション上で公開されている環境を使うことで、誰でも簡単に画像生成AIを体験できるメリットがあります。

Stable Diffusionを試しに使ってみたい方は、Webアプリケーション上に公開されている下記3つのサービスを活用すると効率的です。

Stable Diffusionをローカル環境やGoogle Colaboratoryで利用したい方はGitHubで公開されているコードを利用してください。

ここからは実際にStable Diffusionを各Webアプリケーション上で利用したレビューを行っていきます。今回Stable Diffusionで画像を生成するにあたり、高品質な画像を生成するためのポイントもいくつか分かりましたので、応用編で整理していきます。

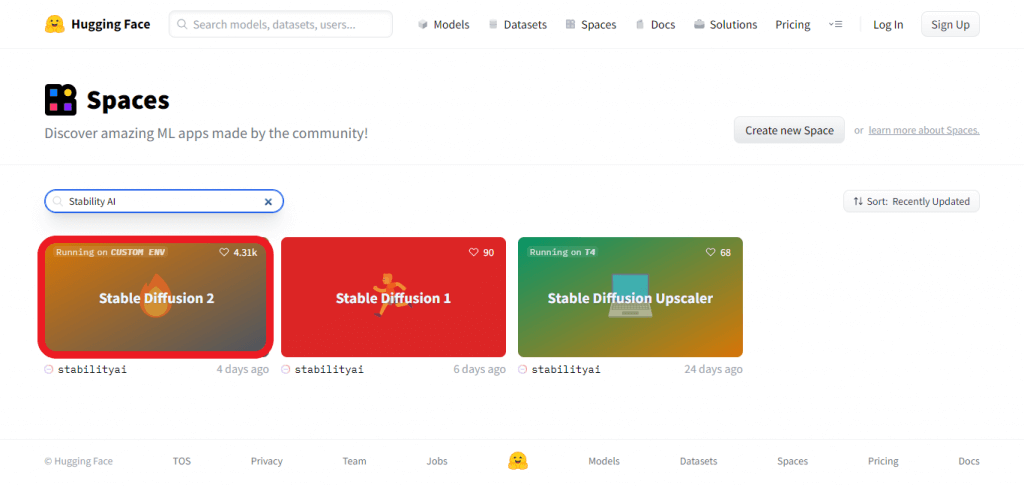

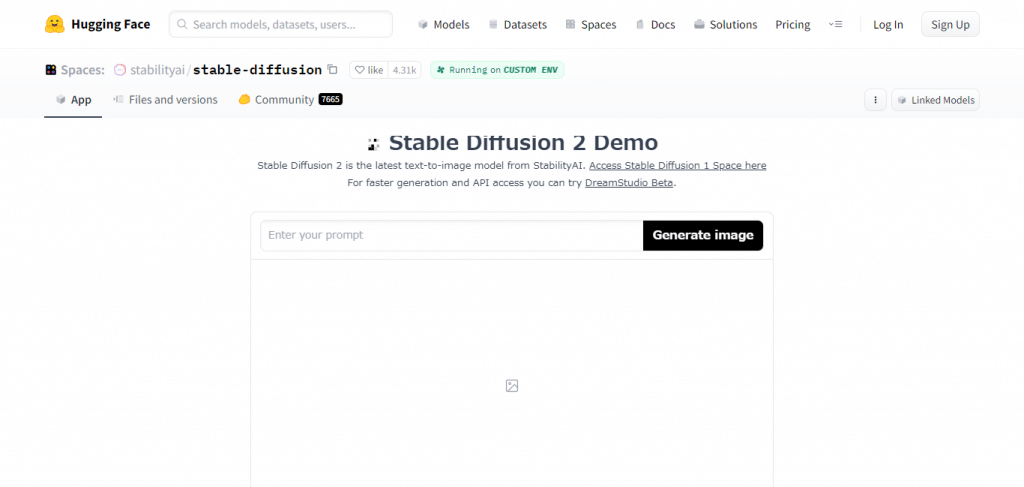

まずはHugging Face上で「Stable Diffusion 2」のデモ版を動かしていきます。Hugging Faceは、自然言語処理のデータセットを共有・利用できるオープンソースコミュニティです。様々な自然言語処理系のデータセットが提供されているなかに「Stable Diffusion 2 Demo」も含まれています。Hugging FaceのSpacesからStable Diffusionを提供する企業名「Stability AI」を検索し、「Stable Diffusion 2」を選択します。

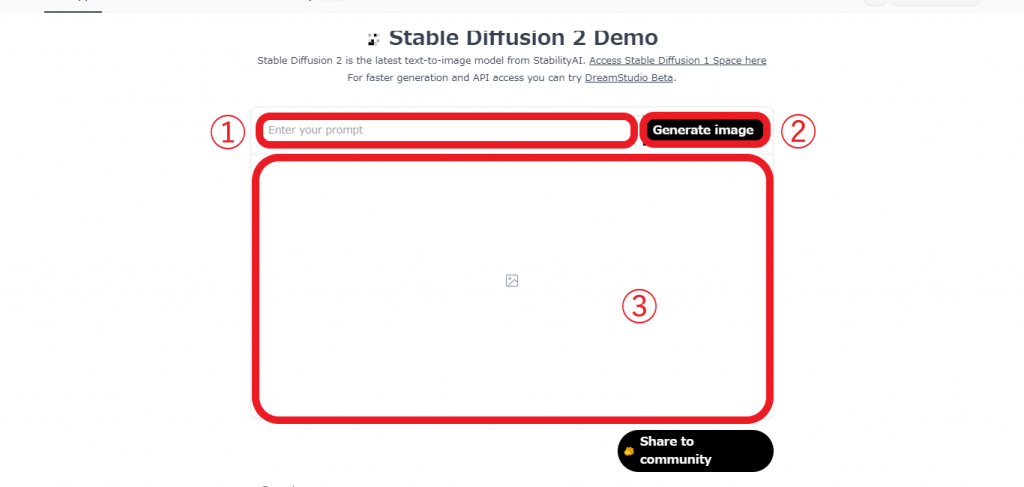

そして下のような画面に遷移したら準備完了です。

Hugging FaceでStable Diffusion 2を利用する操作手順は非常にシンプルで、①のテキスト入力エリアに生成したい画像を表すテキストを入力し、②の画像生成実行ボタンをクリックするだけです。生成された画像は③のエリアに表示されます。

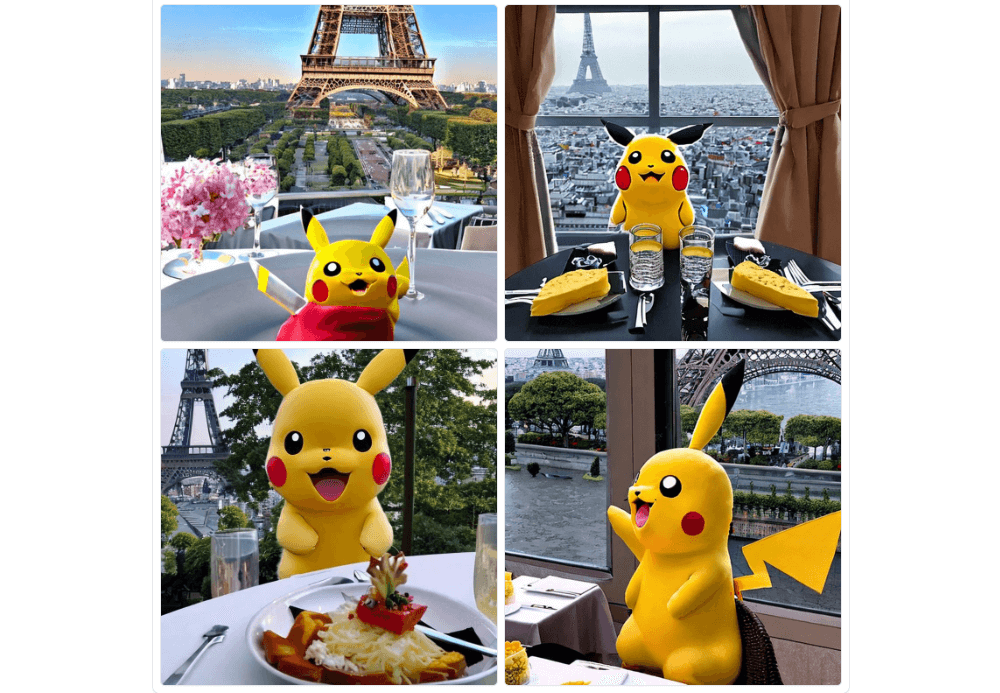

生成したい画像の英文イメージが湧かない方は、ページ下部の英文例が記載されたエリア(Examples)から好みの英文を選択してください。今回は「A pikachu fine dining with a view to the Eiffel Tower」(エッフェル塔を眺めながら高級料理を楽しむピカチュウ)を入力してみます。すると下記のような画像が30秒程で生成されました。

基本操作は非常にシンプルですが、テキストに含める英単語を変えたり、Hugging Face独自のカスタムオプションを調整することで、画像のテイストをイメージに近い雰囲気へと変化させることも可能です。

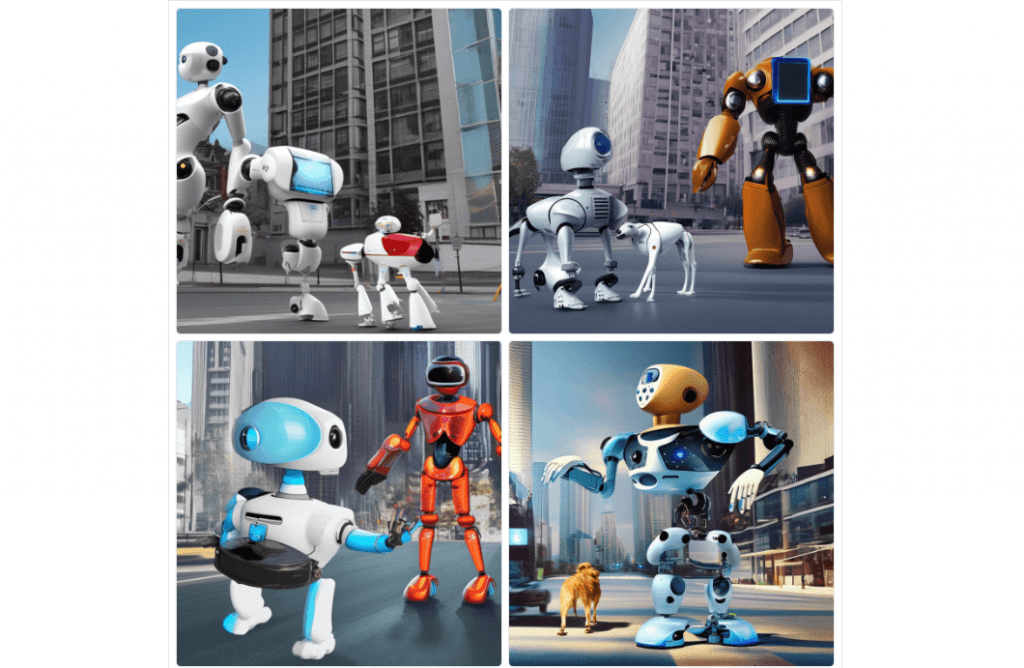

今回は例として「人型のロボットが未来の街で、AIが搭載されたロボット犬を散歩している絵。自動操縦の車が走っていて、空をドローンが飛んでいる。」という文章を英文に訳し、画質を上げて生成してみます。

現状でもかなりテキストのイメージに近い画像が生成されていますが、「画質」がやや粗い印象を受けるため、画像の品質を上げるために「quality8k」を含めてみます。

ロボットにツヤや光沢が見られ、背景とのぼかしも付与されてかなり画質が改善されたのが分かります。画質を改善する英単語には「quality8k」の他に、「quality4k」「realistic」「photorealistic」「Unreal Engine」などがありますので、色々なパターンを試してみてください。

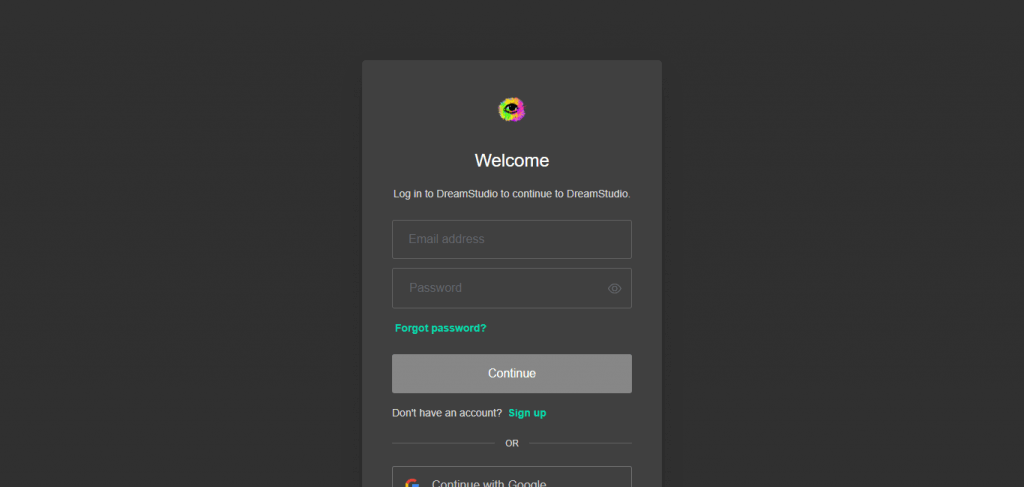

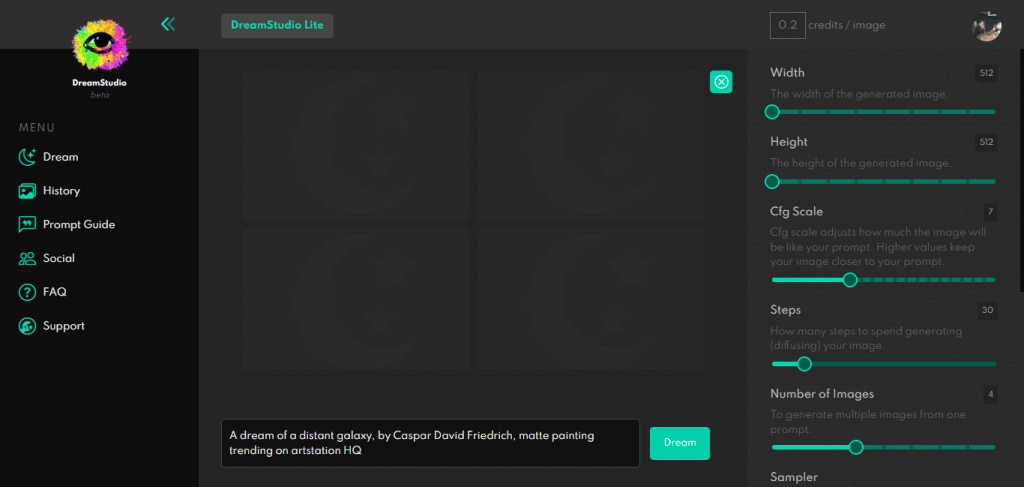

次にStable Diffusionを「Dream Studio」で実行していきます。Dream StudioはHugging Faceよりも早く画像を生成できるのが特徴で、素早くStable Diffusionを体験したい方におすすめです。早速画像を生成してみましょう。上記のリンクを選択すると、下のようなログイン画面が表示されます。

Gmailアカウントを保有しているユーザーは、下部の「Continue with Google」から自身のGoogleアカウントを選択することでログインできます。次の画面が表示されたら画像生成の準備完了です。

①「メニュー」では画像生成を行うタブ「Dream」に加え、過去に生成した画像を保存する「History」、初心者向けのテキスト生成のガイドが記載された「Prompt Guide」、よくある質問をまとめた「FAQ」などがあります。②は生成した画像が表示されるエリアです。

③のエリアは生成画像の細部(detail)を調整する機能です。それぞれ以下のような意味があります。

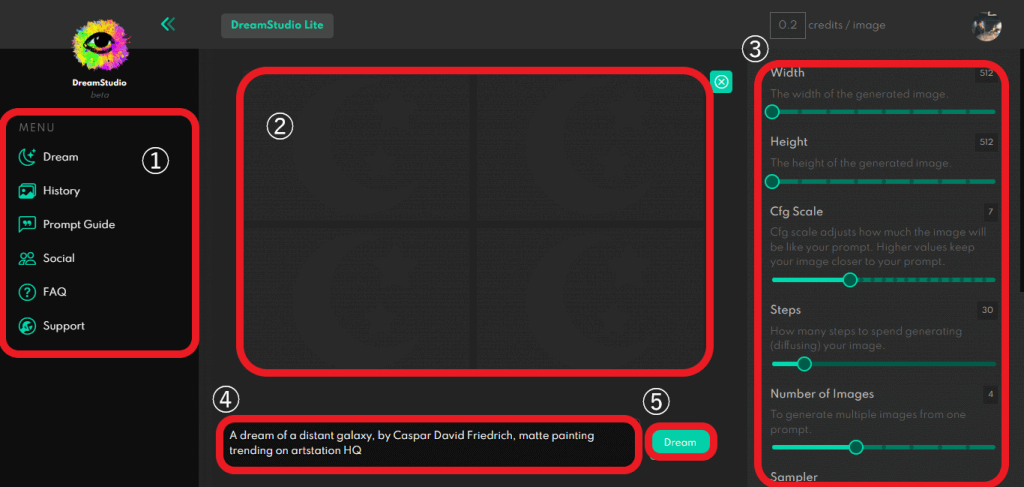

④はテキスト入力エリア、⑤は画像生成を実行するボタンです。試しにデフォルト設定の「A dream of a distant galaxy, by Caspar David Friedrich, matte painting trending on artstation HQ」で生成してみましょう。

イメージ通り「遠くの銀河」や「夢」をイメージした画像が生成されました。画風に「カスパー・ダーヴィト・フリードリヒ」という作家を指定しているため、作家が描く「荒廃感」や「空虚さ」が上手く反映されています。

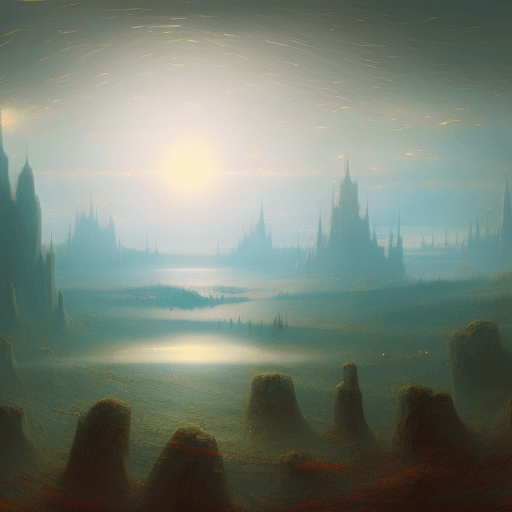

デフォルトの設定でも十分に高画質な画像が生成されましたが、今回は「画風の変化」を試してみたいと思います。Stable Diffusionに限らず、様々な画像生成AIで「浮世絵」の画風が流行っていますので、日本を代表する画家「葛飾北斎」のテイストを試してみます。

「a dream of a distant galaxy」のプロンプトはそのままに「葛飾北斎の浮世絵」をリクエストしてみました。使用したプロンプトは「An ukiyoe painting of a dream of a distant galaxy in Katsushika Hokusai style.」です。背景の山が「富士山」を彷彿させます。

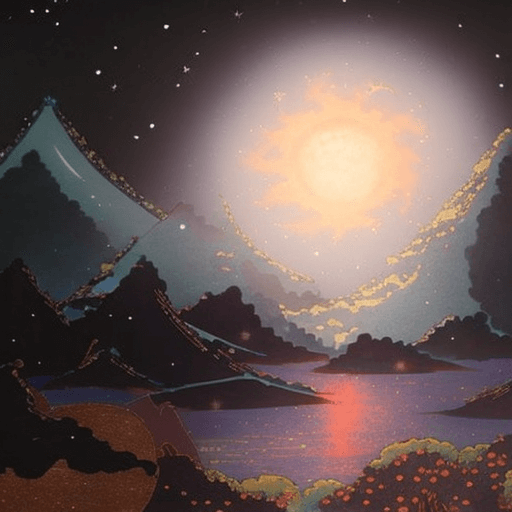

かなりエモーショナルな「葛飾北斎風の”遠い銀河の夢”」が生成されましたが、ここからさらにCfg ScaleとStepsの値を増やしていきます。まずはデフォルトの「Cfg Scale:7」を「Cfg Scale:15」に変更して生成します。

【Cfg Scale:15、Steps:50】

やや写実的な描写からかなり浮世絵のタッチへと変化しています。Cfg Scaleはプロンプトの再現度(忠実度)を調整する値になりますので、値の増加で一気に浮世絵らしくなりました。ここから「Steps(ノイズ除去の回数)」を増やしてみます。

【Cfg Scale:15、Steps:100】

Stepsの回数を増やすと、月のような惑星の明かりがより細かく描かれました。元の画像と比較すると画風に大きく違いが出ています。以上のようにDream Studioでは気に入った画像をCfg ScaleやStepsの値を増加させることで、イメージする画像・絵に近づけることが可能です。

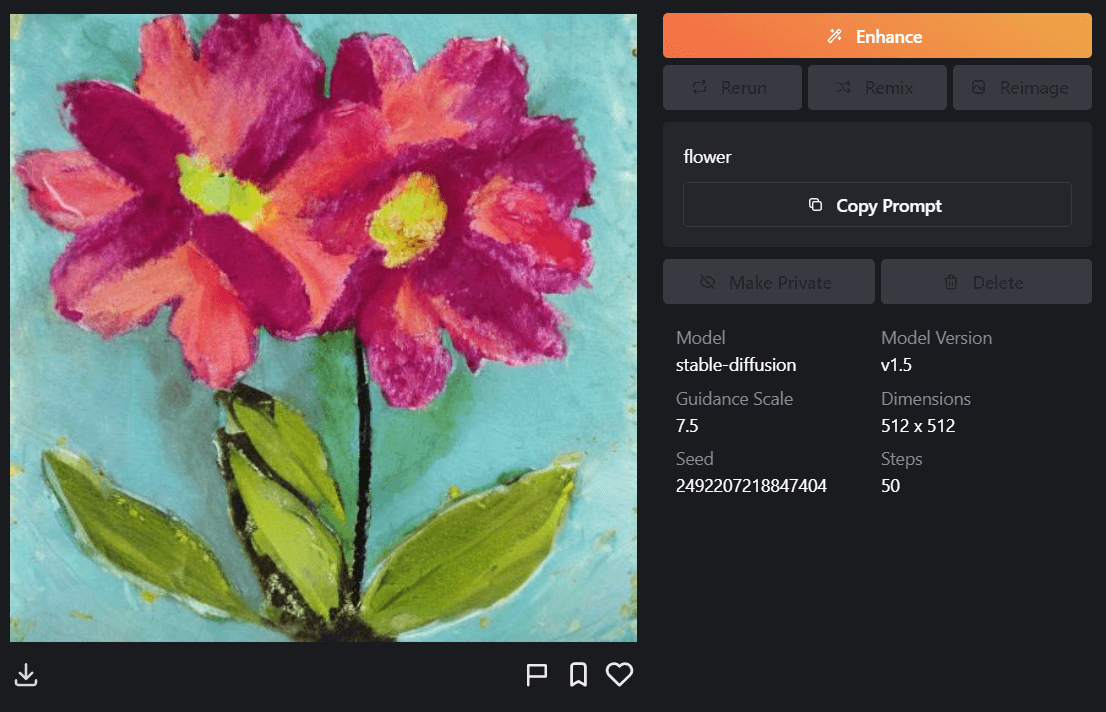

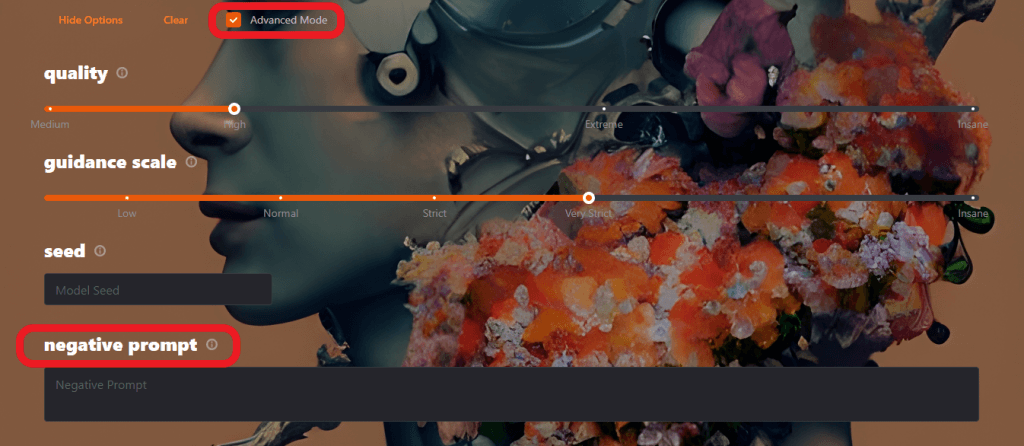

最後にMage上でStable Diffusionを操作する方法を紹介します。Hugging FaceやDream Studioと操作の要領は同じですが、Mageでは「避けたいイメージ」(Negative Prompt)を指定できる特徴を持っています。応用編で紹介しますので、こちらも是非試してみてください。

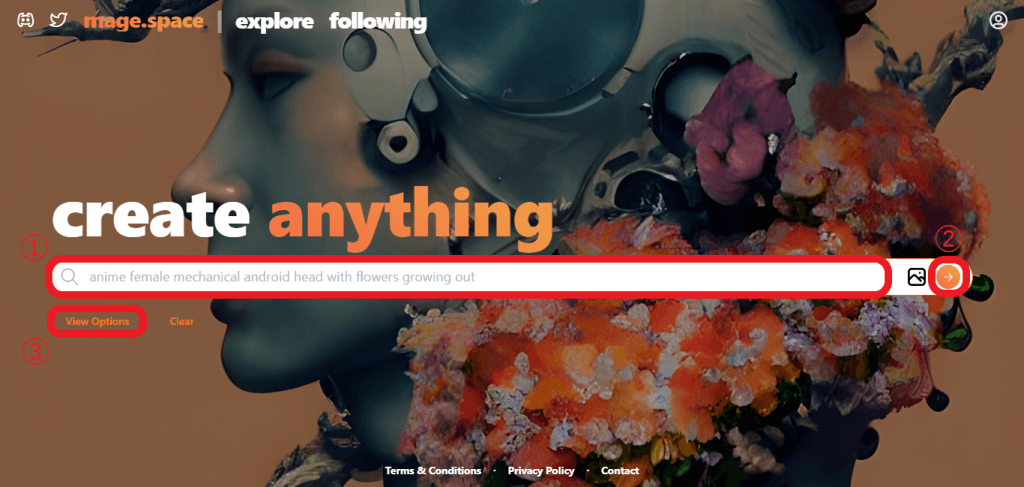

MageのUIもシンプルな作りで、①「テキスト入力エリア」、②「画像の生成ボタン」、③「オプション設定」に分かれています。今回はDream Studioとの差分を見たいため、プロンプトは「A dream of a distant galaxy, by Caspar David Friedrich, matte painting trending on artstation HQ」で設定してみます。

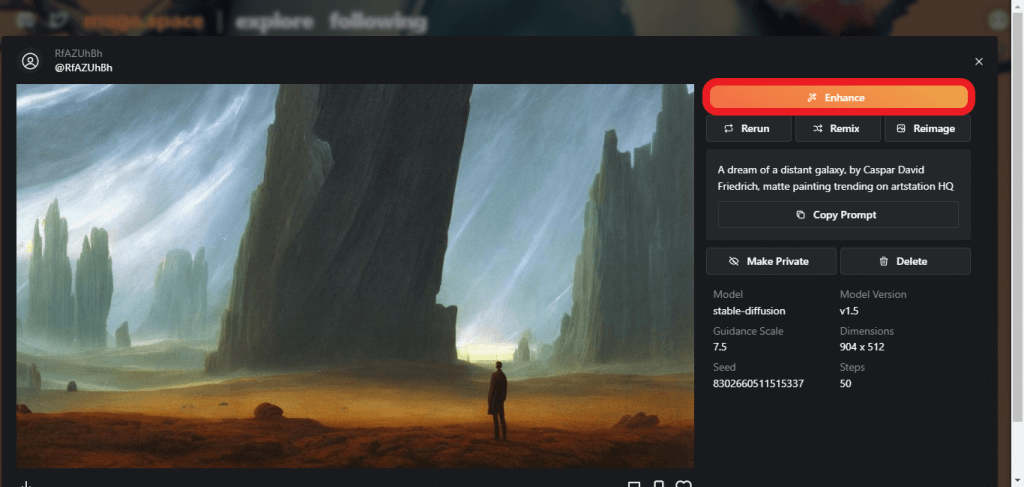

生成された画像を強化するために、右上の「Enhance」を選択します。

Enhanceを選択することで元の画像よりも全体的に画質が良くなり、色の濃淡や影の濃さが変化しています。生成した画像が気に入った際はEnhanceで強化してみましょう。

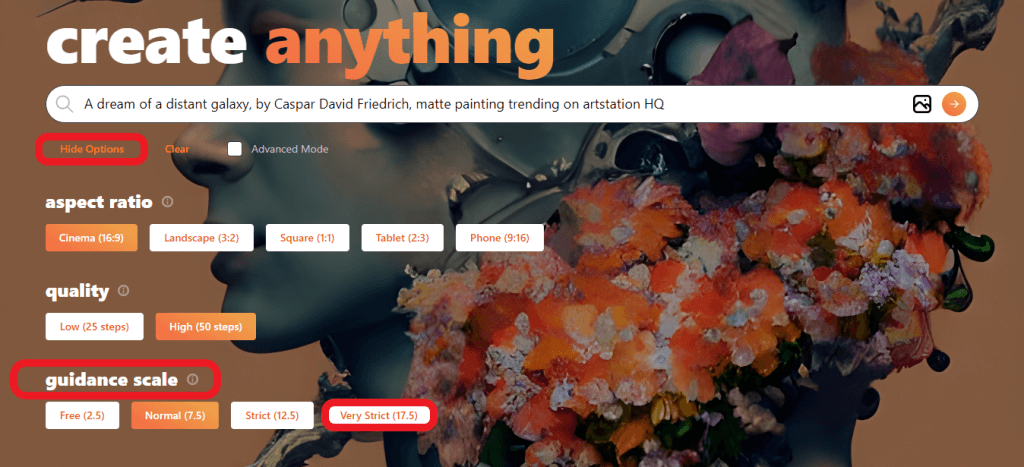

Mageでも画像を変化させていきます。トップページの「View Option」を選択し、「guidance scale」を「Very Strict」に設定します。guidance scaleはプロンプトの忠実度を表す値ですので、作家の画風に近づけていきます。

【Guidance Scale:17.5、Steps:50】

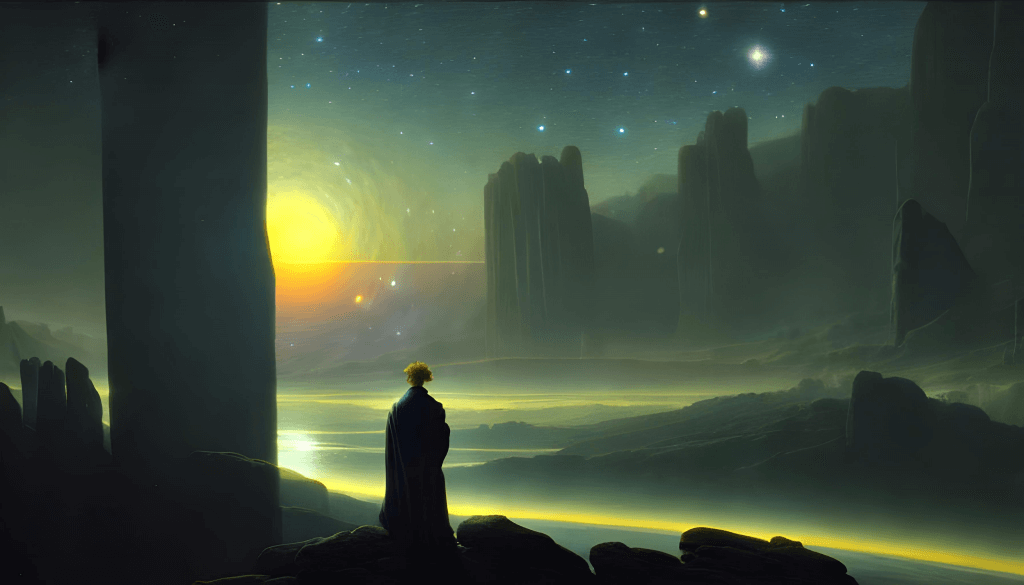

カスパー・ダーヴィト・フリードリヒの作品『雲海の上の旅人』に登場する男性のような人物が風景画とともに描かれました。ここから「negative prompt」にテキストを追加します。

「Advanced Mode」を選択し、「negative prompt」を設定していきます。negative promptは「画像に必要のないもの」を指定する項目で、入力したプロンプトに画像を近づけないようAIが調整してくれます。今回は「人間」(human)を指定してみます。

【negative prompt:human】

人物の居ない綺麗な風景画が描かれました。negative promptに指定したプロンプトが描かれないように生成画像が調整されています。

実はStable Diffusionは「日本語版」も公開されており、日本語のテキストを入力することでも画像を自動生成できます。日本語版のStable Diffusionを体験する方法として下記2つがあります。

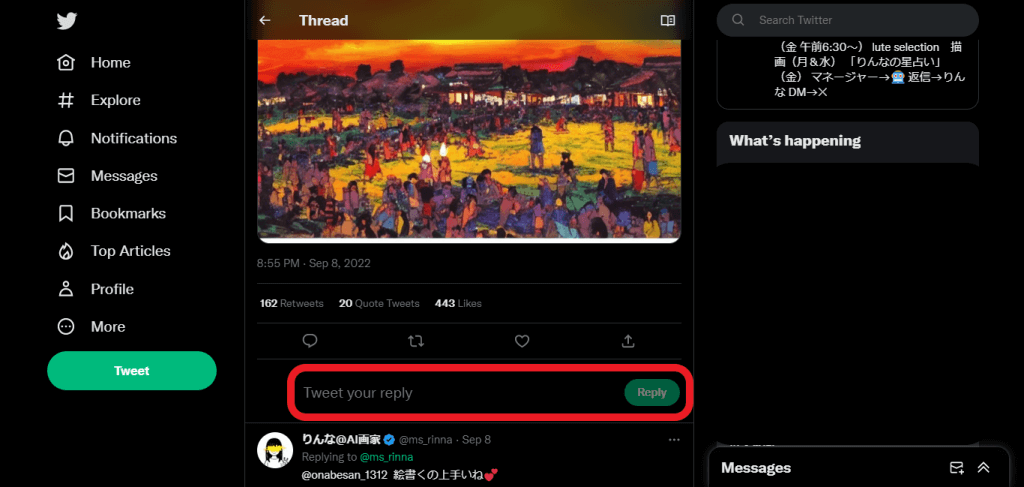

まずはTwitterのAIりんなのアカウントから「お絵描き会場」と書かれたツイートに遷移し、リプライ欄に「描いてほしい絵のイメージ」を記載しましょう。ツイート内容にもありますが、AIりんなに「Japanese Stable Diffusion」が搭載されたことで実現しているサービスです。

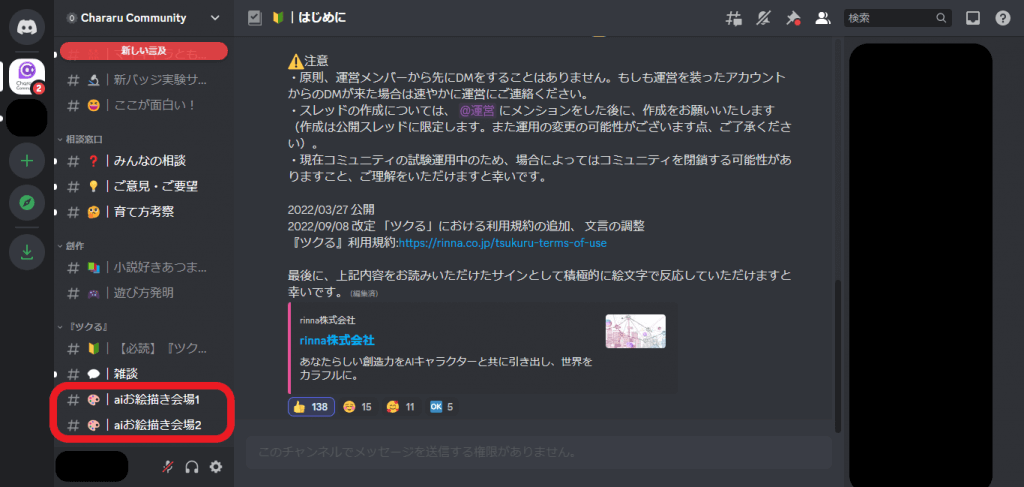

実際に様々な日本語を入力しましたが、全て「不適切なので自主規制します」と書かれた画像が表示され、生成された画像が確認できませんでした。何度かテキストを打ち込むと、「キャラる」という画像生成AIサービスへと誘導されますので、そちらで日本語版のStable Diffusionを体験できます。「キャラる」の招待リンクを選択すると、Discordの登録画面へと遷移しますので、登録を済ませてDiscordの画面に映りましょう。

「キャラる」のDiscordでの画像生成手順は下記の通りです。

1.チャンネルから「# |aiお絵描き 会場」を選択

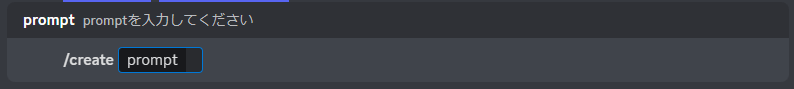

2.「/create」を入力し、「Tsukuru(ツクる)」を呼び出す

3.生成したい画像イメージを日本語で入力する

ちなみに入力したプロンプトは「犬を散歩している日本人女性、浮世絵風」で、下記の画像が生成されました。

「Stable Diffusion web UI」とは、AUTOMATIC1111氏によって提供されているツールで、Stable Diffusionをより手軽に・直感的にユーザーが使えるように開発されています。Stable Diffusion web UIはローカル環境でも実行可能ですが、実行に必要なPCスペックがあるため、まずはクラウド環境で利用するのがおすすめです。いずれの環境で実行する場合もGitHubで公開されているソースコードをインストールする必要があります。

Stable Diffusion web UIには、txt2img(テキストを用いて画像を生成する方法)と、img2img(画像:imageを読み込んで新しい画像を生成する方法)の2つがあります。より直感的に画像生成を行いたいユーザーや、生成したい画像のイメージが決まっているユーザーにはimg2imgの利用がおすすめです。生成画像のクオリティを左右するサンプリング回数やCFGスケールなどは日本語にも対応しているため、英語が苦手なユーザーでも自由に好みの画像へと調整できます。

今回はHugging Face、Dream Studio、Mageを使ってStable Diffusionを体験してみましたが、デフォルトの設定でも高品質な画像を生成できた印象です。カスタムオプションの各値を調整することで、入力したテキストのイメージを忠実に再現したり、ノイズ除去レベルを増減させることで、同じ画像でも画風に近づけたり、遠ざけたりできることが分かりました。

各アプリケーションはブラウザ上で動作するアプリケーションで操作も非常に単純ですので、適当に1つ英単語を入力するだけでも「技術の進歩」と「画像生成する楽しさ」が味わえます。AIsmileyでは、他にも画像生成AIなど生成モデルに関連する話題を取り扱っておりますので、情報収集の場としてご活用ください。

画像認識について詳しく知りたい方は以下の記事もご覧ください。

画像認識とは?AIを使った仕組みと最新の活用事例

AIについて詳しく知りたい方は以下の記事もご覧ください。

AI・人工知能とは?定義・歴史・種類・仕組みから事例まで徹底解説

Stable Diffusionとは画像生成AIの1つです。ユーザーは作成したい画像のイメージ(例えば、アマゾンのジャングル、高層ビルが建ち並ぶ都会、など)を英単語で区切って入力することで、様々な画像を作成できます。

Stable Diffusionでは細かい設定の指示にも対応してくれます。例えば「A pikachu fine dining with a view to the Eiffel Tower」(エッフェル塔を眺めながら高級料理を楽しむピカチュウ)と入力すると、その条件にあった画像がしっかり生成されます。

日本語版のStable Diffusionを体験する方法として下記2つがあります。

Stable Diffusionは無料で利用できます。クラウド上で実行する場合は「Hugging Face」や「Dream Studio」などのWebアプリケーションを利用し、ローカル環境で実行する場合はソースコードをインストールするか、もしくはStable Diffusion web UIをインストールして利用します。

「Stable Diffusion web UI」は、AUTOMATIC1111氏によって提供されている、Stable Diffusionをより手軽に・直感的にユーザーが使えるように開発されたツールです。

業務の課題解決に繋がる最新DX・情報をお届けいたします。

メールマガジンの配信をご希望の方は、下記フォームよりご登録ください。登録無料です。

AI製品・ソリューションの掲載を

希望される企業様はこちら