生成AI

最終更新日:2025/03/26

Qwen2.5-Maxとは?

Qwen2.5-Maxとは?

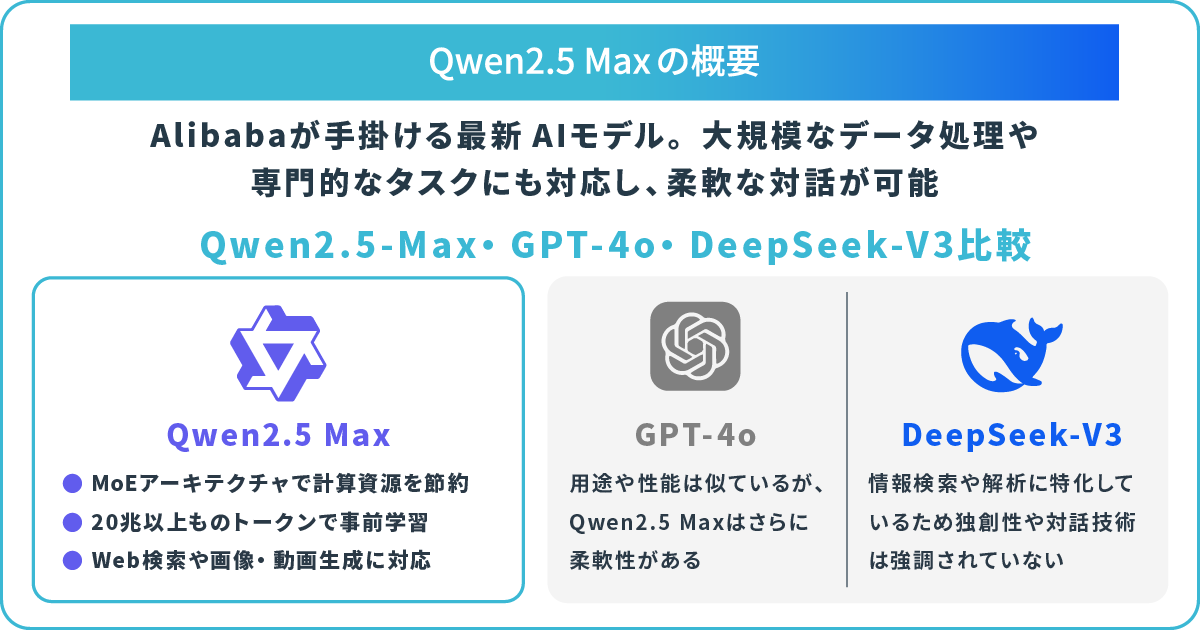

Qwen2.5-Maxは、1月28日に中国の大手企業Alibaba(アリババ)がリリースした最新AIモデルです。20兆以上もの膨大なトークンを使用したトレーニングにより、高性能かつ効率的な対応を可能にしています。

また、複数のテストにおいて、OpenAI社の「GPT-4o」や同じ中国発の「 DeepSeek-V3」といった競合モデルを上回る評価を示しており、注目が集まっています。本記事では、Qwen2.5-Maxの主な特徴や競合モデルとの比較、使い方、利用時の注意点などをわかりやすく解説します。

Qwen2.5-Maxとは、中国の大手企業 Alibabaが開発した大規模言語モデル(LLM)「Qwen(クウェン)」の最新モデルです。1月28日にリリースされ、複数のテストにおいてOpenAIのGPT-4oやDeepSeek-V3を上回るベンチマークを記録したと公表されています。

Qwen2.5-Maxは高度な推論能力と自然言語処理機能に強みがあり、大規模なデータ処理や専門タスクにも対応しています。Qwenシリーズは、多言語対応やコード生成、データ解析など幅広い機能を備えた汎用AIツールの位置づけであり、最新バージョンの登場によってさらなる活用が見込まれています。

Qwen2.5-Maxを開発した「Alibaba(アリババ)」は、Aliexpressなどで知られる中国の大手企業ですが、AI事業にも力を入れています。

医療や金融、法律など専門分野に特化したAIモデルやカスタマーサービス向けのAIサービス(Tongyi Xiaomi)などを手掛けています。最近では、仮想キャラクター生成AIツールの「Animate Anyone」やダンス動画生成AI「DreaMoving」のリリースが話題を呼んでいます。

Qwen2.5-Maxの主な特徴として、MoEアーキテクチャの採用や20兆以上ものトークンを使用した事前学習、さらにはSFTおよびRLHFによるファインチューニングなどが挙げられます。それぞれのポイントについて詳しく紹介します。

Qwen2.5-Maxでは、MoE(Mixture of Experts)アーキテクチャを採用しています。「MoEアーキテクチャ」とは、複数の専門家(Experts)のようなサブネットワークを用いて、ユーザーの入力に応じて特定の専門知識が活用される仕組みです。

ユーザーの入力内容に応じて必要な専門家だけが対応するため、計算リソースの省エネを促進しています。Qwen2.5-Maxのパラメータ数は推定で1,000億(100B)規模と言われており、大規模でありながらもMoEにより高速な応答を実現している点が特徴です。

Qwen2.5-Maxの事前学習には20兆以上のトークンが使用されています。この膨大なテキストデータには、大学レベルの教養から専門知識、プログラミング言語、自然言語での対話データまでが網羅されています。

約9万語の小説に換算すると、約1億6,800万冊分のデータが用いられている計算です。圧倒的な量のデータセットを用いることで、高精度かつ迅速な対応を実現しています。

Qwen2.5-Maxのファインチューニングには、「SFT」および「RLHF」と呼ばれる手法が用いられています。SFT(教師あり微調整)とは、大規模言語処理モデル(LLM)を特定のタスクや用途に最適化するための手法です。

事前学習したモデルに、人間がラベル付けしたデータを使って追加学習させることで、特定分野における高精度な応対を実現しています。また、少ない計算リソースで高精度なモデルを構築することが可能です。

RLHF(Reinforcement Learning from Human Feedback)は、人間の評価によってLLMの出力内容を改善する強化学習手段です。AIモデルがより人間らしい自然な対応を実現することを目的としています。SFTを組み合わせることで、より文脈に配慮した応対能力や柔軟な適応性の強化につながります。

Qwenシリーズでは、テキスト生成や要約に加えて、以下4つの主要機能を搭載しています。

ChatGPTやGeminiなどと同じように汎用性の高い仕様であり、さまざまなシーンでの活躍が期待できます。

Qwen2.5シリーズにはMaxを含め9種類のモデルがあり、複数のモデルを組み合わせて使用できます。例えば、Qwen2.5-Maxと高速な長文に対応したモデル(Qwen2.5-Turbo)を組み合わせることで、より高度で理論的な文章生成を行うことが可能です。

モデルごとに、対応する分野や最大テキスト量、入力形式が異なるため、用途やシーンによって使い分けるとさらに効果的です。

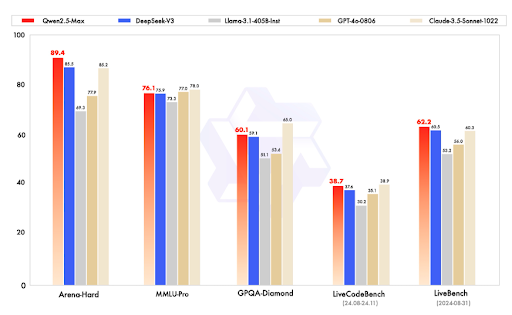

Qwen2.5-Maxは、複数の評価基準において高いスコアを記録しており、精度の高さと汎用性が証明されています。以下のグラフは、公式サイト上で公開されているベンチマーク比較です。

引用元:Qwen

上記5つのベンチマークのうち、4つで Qwen2.5-Maxはトップの評価を打ち出しています。指標別で見ると、複雑な問題解決能力や人間が好む回答の生成などを評価する「Arena-Hard」や、言語処理から数学問題まで幅広い知識を問う「LiveBench」では、Qwen2.5-MaxはGPT-4oやDeepSeek-V3を超えるスコアを記録しました。

知識と推論力を図る「MMLU-Pro」やプログラミング能力を問う「LiveCodeBench」では、Claude 3.5 sonnetの方がわずかに上ですが、総合的に見るとQwen2.5-Maxは性能の高いLLMモデルと言えます。

Qwen2.5-Maxは、複数の利用方法で始められます。それぞれの使い方を紹介します。

Chat版は、手軽にQwen2.5-Maxを利用できる方法です。以下の手順に沿って登録するだけで、簡単にチャットを開始できます。

ログインには、GoogleアカウントまたはGitHubアカウント、もしくはメールアドレスとパスワードの入力が選択できます。セキュリティ確認のため、CAPTCHA認証を完了する必要があります。

Hugging Face上で、Qwen2.5-Maxのデモ版が公開されています。ページにアクセスすると、すぐにデモ版が表示されるので、Inputの欄に質問や対話を入力するだけでスタートします。まずQwen2.5-Maxを試してみたいという場合は、利用してみましょう。

Qwen2.5-MaxのAPIキーを活用すれば、外部システムやアプリケーションと連携が可能です。Alibabaの公式サイトから、以下の手順でQwen2.5-MaxのAPIキーを取得しましょう。

事前にAlibaba Cloudにて支払い設定を完了している場合、「Activate」 ボタンで有効化するとAPIキーを取得できます。

Qwen2.5-Maxは、高性能なモデルですが、利用する際に注意点もあります。ここでは2つの注意点について解説します。

Qwenには一定の利用制限があります。例えば、短い時間に大量の入力を行うような場合、上限に達すると一時的に利用できなくなる可能性があります。Alibaba Cloud経由でのAPI利用の際には、特にリクエスト数や実行時間に注意して使うことが重要です。

また、画像や動画の生成など、特定のモデルにのみ対応している機能もあるため、各モデルの特徴や対応形式を確認しましょう。

Qwen2.5-Maxは、Alibaba Cloud上で動作しており、入力された情報は中国のサーバーに送信される可能性があります。セキュリティリスクを考慮し、機密情報や個人情報の取り扱いには十分注意が必要です。

特に企業や組織で Qwen を使用する場合は、データの送信先やデータ管理などについて、コンプライアンスに準拠していることを確認した上で利用することが望ましいです。

Qwen2.5-Maxは、MoEアーキテクチャを採用した最先端モデルです。20兆を超えるトークンで事前学習を行い、少ない計算リソースでより大規模な処理を可能にしています。自然言語処理能力に加え、Web検索やArtifacts機能、画像・動画生成などをワンストップで利用可能です。

公式データでは、同じ中国発のDeepSeek-V3やGPT-4oを超えるベンチマーク評価を示しており、AI業界でも注目を集めています。Alibabaの開発チームは、Qwenシリーズの継続的な開発を示唆しており、さらなるモデルの進化に期待が寄せられています。

アイスマイリーでは、生成AIサービスの一覧比較を無料でダウンロードいただけます。自社における業務効率化や生産性の向上に向けて、最新AIツールの導入検討にお役立てください。

Qwen2.5-Maxの商用利用について、現時点では明確に言及されていません。ただ、Alibaba Cloud経由でAPIを利用するため、Alibaba Cloudの規約に従う必要があります。利用規約を遵守した上で、適切に利用することが重要です。

Qwen2.5-Maxは日本語に対応しており、日本語での質疑応答や多言語への翻訳が可能です。ただ、中国語や英語に比べて精度が多少劣る可能性がありますが、一般的なトピックやテーマの対話であれば、自然な日本語で流暢にやり取りできます。 注意点として、専門分野に関する対話では、表現が不自然になる場合があります。また、日本語特有の言い回しや丁寧語のニュアンスをカバーしきれない可能性もあるため注意が必要です。

業務の課題解決に繋がる最新DX・情報をお届けいたします。

メールマガジンの配信をご希望の方は、下記フォームよりご登録ください。登録無料です。

AI製品・ソリューションの掲載を

希望される企業様はこちら