生成AI

最終更新日:2024/03/11

Alibaba 動画生成モデルEMO発表

Alibaba 動画生成モデルEMO発表

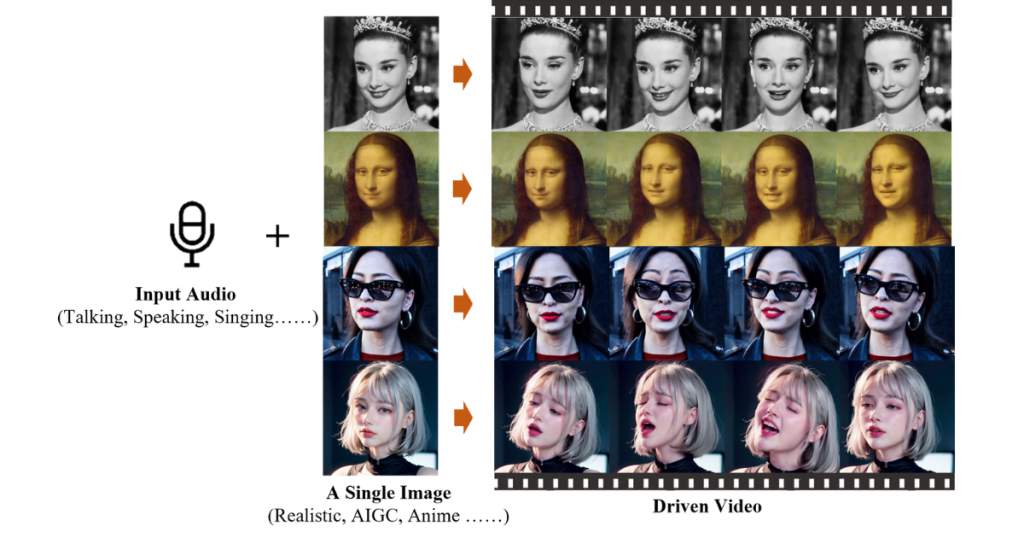

Alibabaは、単一の参照画像と音声データからリアルに動く人物動画を生成できるAIシステム「EMO」を発表しました。

このAIニュースのポイント

中国企業のAlibabaのInstitute for Intelligent Computingは、1枚の写真や絵のデータをもとに、会話や歌声の音声ファイルを使用して、音声の内容に基づいた自然な動きや顔の表情を再現するアバターの生成技術「EMO」(Emote Portrait Alive)を発表しました。入力音声の長さに応じて、任意の再生時間の動画を生成します。

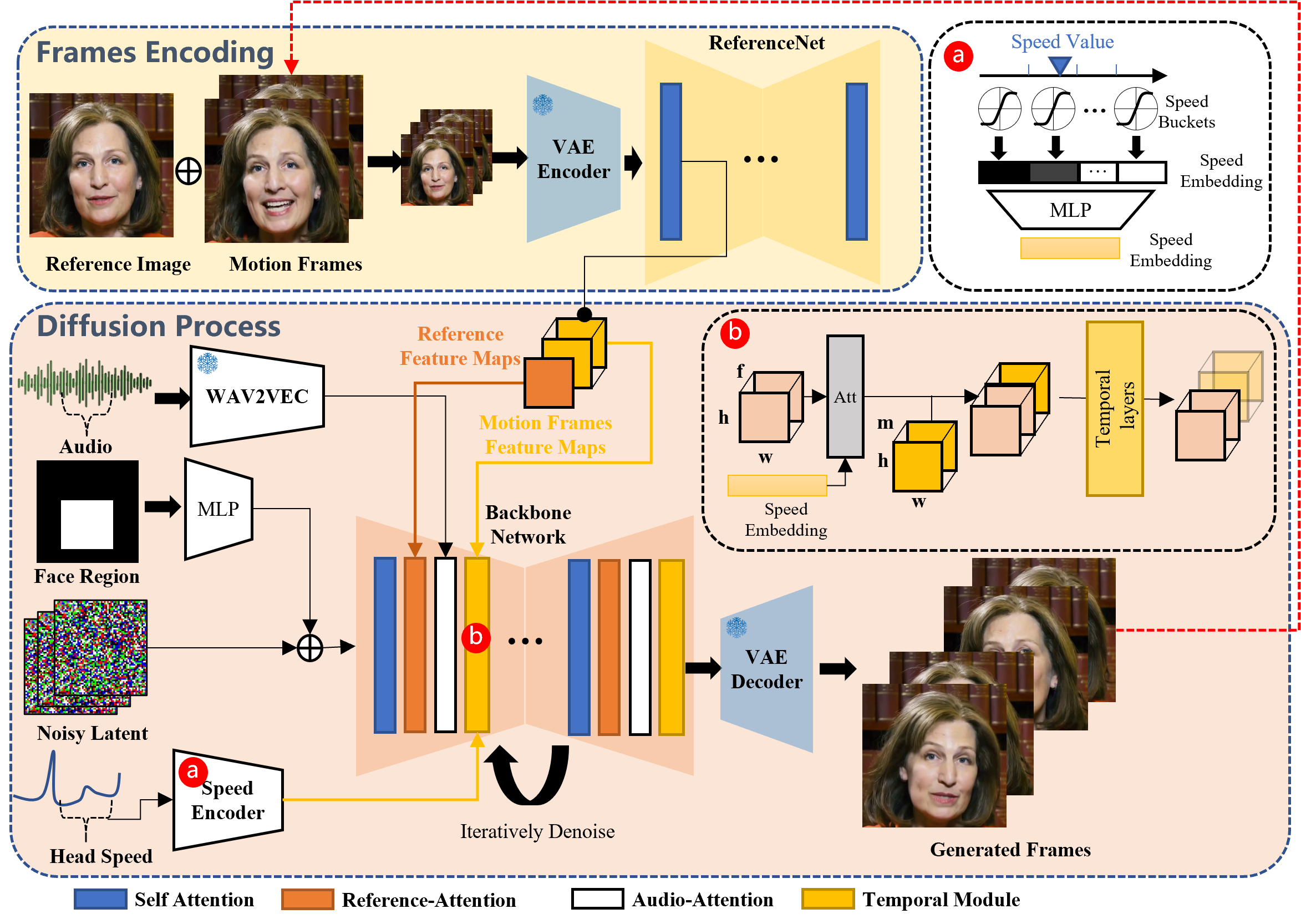

EMOは、音声を分析する音声エンコーダーと、参照画像から顔の特徴や動きをとらえるフレームエンコーディングによって、音声に合わせた動画を生成しています。

ノイズ除去処理を容易にするためにバックボーンネットワークも使用されており、音声に合わせて、従来より広い領域の表情を、自然かつ独自性を捉えて表現可能です。さらに、バックボーンネットワーク内では、リファレンス・アテンションとオーディオ・アテンションが適用されており、キャラクターの特徴を生かした動きになるように調整できます。

入力する画像は、写真やイラスト、AIによって生成した人物などが適用可能です。入力音声も様々な言語の音声や歌声に対応しており、ラップのようなスピードの早い音声においても口の動きを忠実に再現しています。

現在Alibabaは、学術研究と効果実証のみを目的にこのプロジェクトを発表しています。この新しい手法の応用により、映画制作やアニメーション、さらにはソーシャルメディアコンテンツなど、さまざまな分野での利用が期待されています。

出典:GitHub

業務の課題解決に繋がる最新DX・情報をお届けいたします。

メールマガジンの配信をご希望の方は、下記フォームよりご登録ください。登録無料です。

AI製品・ソリューションの掲載を

希望される企業様はこちら