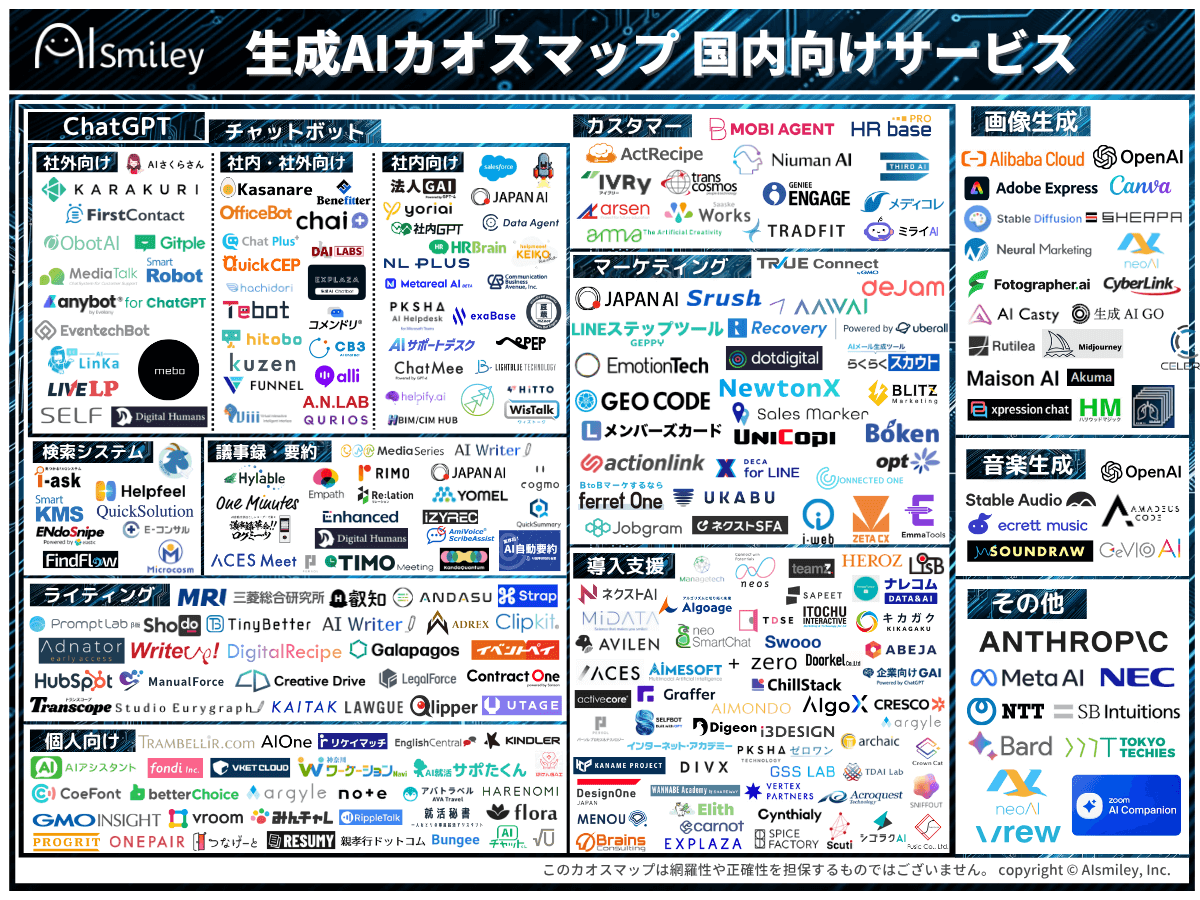

生成AI

AIエージェント

AIエージェント

生成AI

生成AI

ChatGPT連携サービス

ChatGPT連携サービス

AI受託開発

AI受託開発

対話型AI -Conversational AI-

対話型AI -Conversational AI-

ボイスボット

ボイスボット

バーチャルヒューマン

バーチャルヒューマン

教師データ作成

教師データ作成

AI研究開発

AI研究開発

通訳・翻訳

通訳・翻訳

声紋認証

声紋認証

機密情報共有・管理

機密情報共有・管理

契約書管理システム

契約書管理システム

ワークステーション

ワークステーション

FAQシステム

FAQシステム

AIカメラ

AIカメラ

生体認証

生体認証

インボイス制度対応システム

インボイス制度対応システム

データセットの収集・購入

データセットの収集・購入

コールセンター

コールセンター

人事・総務向け

人事・総務向け

インバウンド対策

インバウンド対策

コンバージョンアップ

コンバージョンアップ

KYT・危険予知で労働災害防止

KYT・危険予知で労働災害防止

無料AI活用

無料AI活用

顧客リスト自動生成

顧客リスト自動生成

ロボットで自動化

ロボットで自動化

LINE連携

LINE連携

セキュリティー強化

セキュリティー強化

テレワーク導入

テレワーク導入

AI学習データ作成

AI学習データ作成

配送ルート最適化

配送ルート最適化

非接触AI

非接触AI

受付をAIで自動化、効率化

受付をAIで自動化、効率化

AIリテラシーの向上サービス

AIリテラシーの向上サービス

日本語の手書き文字対応AI-OCR

日本語の手書き文字対応AI-OCR

Windows作業の自動化RPAツール

Windows作業の自動化RPAツール

リスク分析AIで与信管理

リスク分析AIで与信管理

紙帳票仕分けAI-OCRサービス

紙帳票仕分けAI-OCRサービス

サプライチェーン

サプライチェーン

自治体向けAI

自治体向けAI

AIコンサルティング

AIコンサルティング

最終更新日:2024/09/26

Google ハルシネーション対処モデルを発表

Google ハルシネーション対処モデルを発表

Googleは、ハルシネーションに対応するために開発された初のオープンモデル「DataGemma」を、2024年9月13日に発表しました。

このニュースのポイント

Googleは、LLMを基盤としたハルシネーションに対応するために開発された初のオープンモデル「DataGemma」を2024年9月13日に発表しました。

「DataGemma」は「Gemini」の軽量版LLM「Gemma」を基盤に、「Data Commons」の信頼性の高いデータを使って回答するモデルです。「Data Commons」は数十万の統計変数にわたる2400億を超えるデータポイントを含む、公開されているナレッジグラフで、国連(UN)や世界保健機関(WHO)、疫病予防管理センター(CDC)、国勢調査局などの信頼できる組織から習得されています。

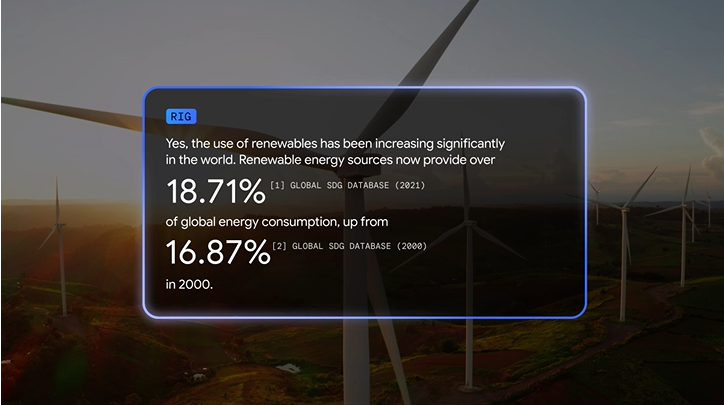

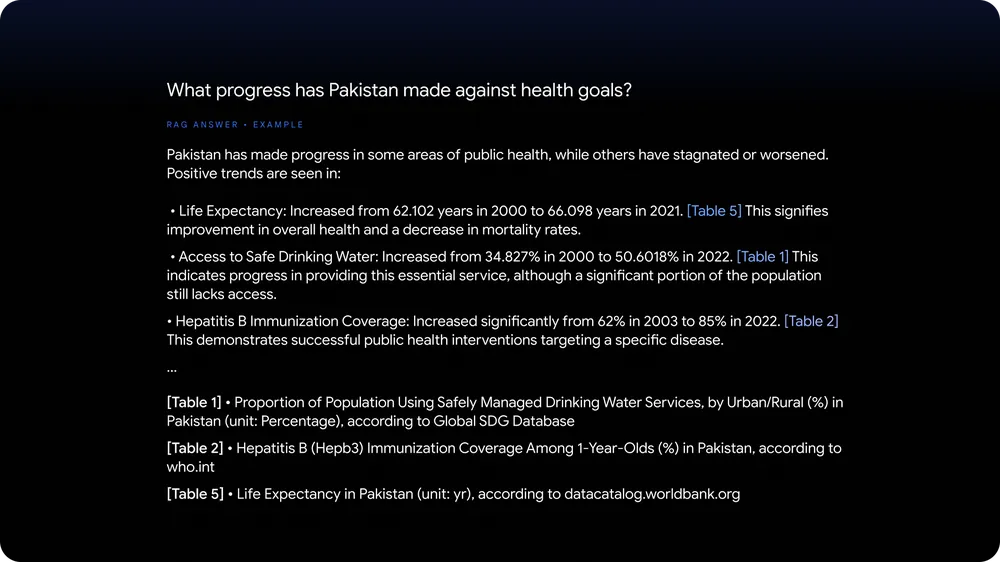

また「DataGemmaモデル」は、RIG (Retrieval-Interleaved Generation)とRAG (Retrieval-Augmented Generation)の2つのアプローチを利用し、LLMの事実性と推論を強化しています。

RIGは、信頼できるソースを積極的に照会し、Data Commonsの情報に対してファクトチェックを行うことで、Gemma 2の機能を強化します。

またRAGにより、言語モデルはトレーニング データ以外の関連情報を組み込み、より多くのコンテキストを吸収することでより包括的で有益な出力が可能になります。「DataGemma」は、モデルが応答生成を開始する前に「Data Commons」から関連するコンテキスト情報を取得するため、ハルシネーションのリスクが最小限に抑えられ、応答の精度が向上します。

RIGとRAGを使用した予備調査は初期段階ですが、数値事実処理における言語モデルの精度が向上しており、ユーザーの幻覚経験が減少する可能性が示されています。

Googleは、LLMの信頼性と信頼性を高めることは、AIが人々に正確な情報を提供することで、情報に基づいた意思決定を促進し、世界に対するより深い理解を促す未来を築くための鍵になるとコメントしています。

出典:Google

業務の課題解決に繋がる最新DX・情報をお届けいたします。

メールマガジンの配信をご希望の方は、下記フォームよりご登録ください。登録無料です。

AI製品・ソリューションの掲載を

希望される企業様はこちら