生成AI

最終更新日:2024/12/09

Groqとは?

Groqとは?

2024年8月14日のYahoo!ニュースで、アメリカのAIソリューション企業Groq.Incが新たに6億4000万ドル(約946億円)を調達し、市場のAIチップ需要に応えようとしていることが報じられました。

AIチップとは、AIによるディープラーニングや機械学習を実行するための半導体チップのことで、大量計算ができるにもかかわらず消費電力は少なくて済むというメリットがあります。

Groq.Incが作るAIチップはLPU(Language Processing Unit)と呼ばれ、GPUやCPUを超える計算能力を実現しています。

それでは、LPUはどのようにAI計算を高速化し対話型生成AIの進化に貢献しているのでしょうか。この記事では、LPUを搭載してAI計算の高速処理を可能にした対話型生成AIのGroqについて詳しく解説します。

Groq(グロック)は、Groq.Incが開発・運営している対話型生成AIを指し、今までの生成AIと比較すると回答の生成速度が飛躍的に速いのが特徴的です。このスピードは、Groq.IncのLPUがAI推論をを行うことができるため実現しました。

AI推論とは、AIが学習した内容を新しい状況にあてはめることで人間の推論をまねる能力のことを指します。Groq.Incでは創業時からAI推論に特化したAIチップの設計に取り組んでいるため、Groqにもこの技術が使われることになりました。

Groq.Incに出資したGeneral Global Capitalの共同創業者であるエミッシュ・シャー氏は、「彼らの推論速度は、明らかに市場に出回っているの他のどの製品よりも優れています」と評価しています。

ChatGPTは2022年11月にOpenAIが公開した対話型生成AIです。GroqとChatGPTには次のような違いがあります。

| Groq | ChatGPT | |

| 運営会社 | ・Groq.Inc

・AIチップの開発を中心とした事業を行っている |

・OpenAI

・AI研究とその商業化がメイン事業 |

| ターゲット | ・利用者にAI研究者、エンジニア、企業が多い | ・幅広い層が対象 |

| 日本語対応 | ・可能 | ・可能 |

| 出力速度 | ・500トークン/秒 | ・数十トークン/秒 |

| 特徴 | ・AI推論ができる | ・日常的な質問応答から、専門的な内容まで幅広いリクエストに応じる |

トークンとはAIが文章を理解するための単語で、例えば英語の「How are you」という文は3トークンと数えられます。

GroqとChatGPTは同じ対話型生成AIですが、ターゲット層が異なるためそれに応じて機能や特徴が異なるのがわかります。

Geminiは2023年12月にGoogleが公開したAIモデルです。

| Groq | Gemini | |

| 運営会社 | ・Groq.Inc

・AIチップの開発を中心とした事業を行っている |

・Google

・検索エンジン、Web広告、クラウドコンピューティング、ソフトウェア、ハードウェア関連事業を行っている |

| ターゲット | ・利用者にAI研究者、エンジニア、企業が多い | ・開発者、企業、マーケター、一般ユーザーなど幅広い |

| 日本語対応 | ・可能 | ・可能 |

| 特徴 | ・500トークン/秒という早い出力速度を持つ | ・テキスト、画像、音声、動画、コードといった異なるタイプの情報を統合して理解し、処理できる能力を持つマルチモーダルAI |

Groqは対話型生成AIとして活用されていますが、Geminiは対話型生成AIとして活用されるだけでなく、GoogleのサービスであるGmailやDocs、Google Meetなどにも組み込まれ、ユーザーをサポートしています。

Groqが生成AI市場で注目される背景について、以下の3つをご紹介します。

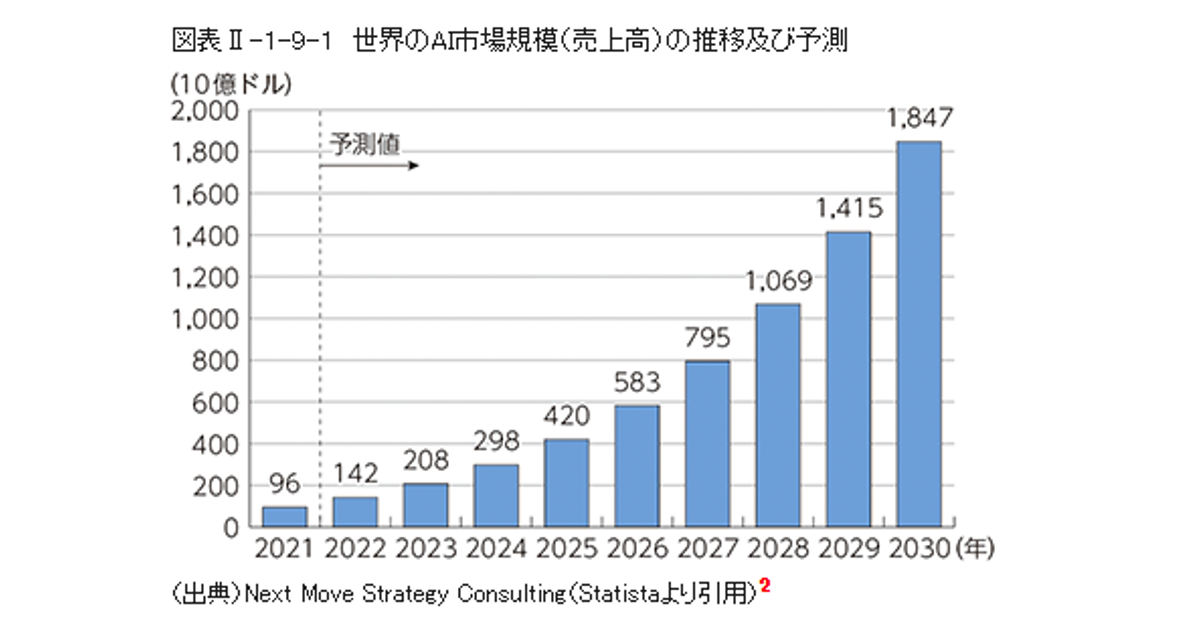

画像出典:総務省 情報通信白書「第Ⅱ部 情報通信分野の現状と課題 第9節 AIの動向」

2024年に総務省が公表した「令和6年版情報通信白書」によると、世界のAI市場規模(売上高)は2021年で96億ドルでしたが、2030年には1,847億ドルに増加すると予測されています。

AIの市場規模が加速度的に増えているため、LPUという新技術を搭載したGroqへも注目が集まっているのです。

参考:総務省 情報通信白書 「第Ⅱ部 情報通信分野の現状と課題 第9節 AIの動向」

2023年6月に株式会社帝国データバンクが行った「生成AIの活用に関する企業アンケート」において、1380社を対象に活用したことがある、または活用したい生成AIは何か尋ねたところ、「文章・コード生成AI」が93.1%でした。

ビジネスの場では文章生成が使われることがほとんどであるため、対話型生成AIで出力速度が早く、業務の効率化に役立つGroqにも注目が集まっています。

参考:TDB economic online「生成AIの活用に関する企業アンケート」

従来のAIは高速化すると回答の精度が低くなってしまうという特徴がありました。

しかしGroqはLPUが搭載されているため、大きなデータ処理やタスクを行うためにシステムを拡張しても、その処理速度や精度は落ちません。

日本語での品質回答はまだそこまで高くないという意見もありますが、LPUのこの特徴はAI業界においても注目を集める要因の一つとなっています。

Groqの使い方は以下の通りです。

1.Groqのトップページにアクセス

画像出典:Groq公式ホームページ

2.「Try it」に何か入力しようとしたり、下の3種類のボタンを選択したりするとアカウントの作成を求められる

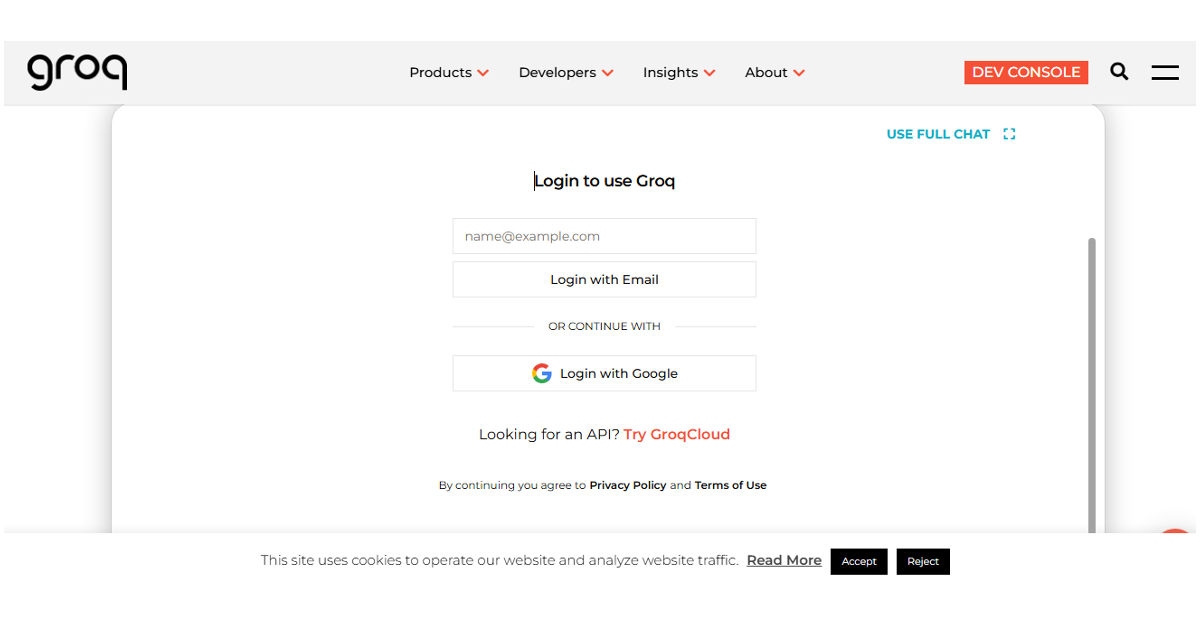

画像出典:Groq公式ホームページ

画像出典:Groq公式ホームページ

3.EメールかGoogleのアカウントを用いてログイン

4.「Try it」に質問文を入力して▶︎をクリック

画像出典:Groq公式ホームページ

画像出典:Groq公式ホームページ

操作自体は難しくないため、アカウントを作成するところから始めてみましょう。

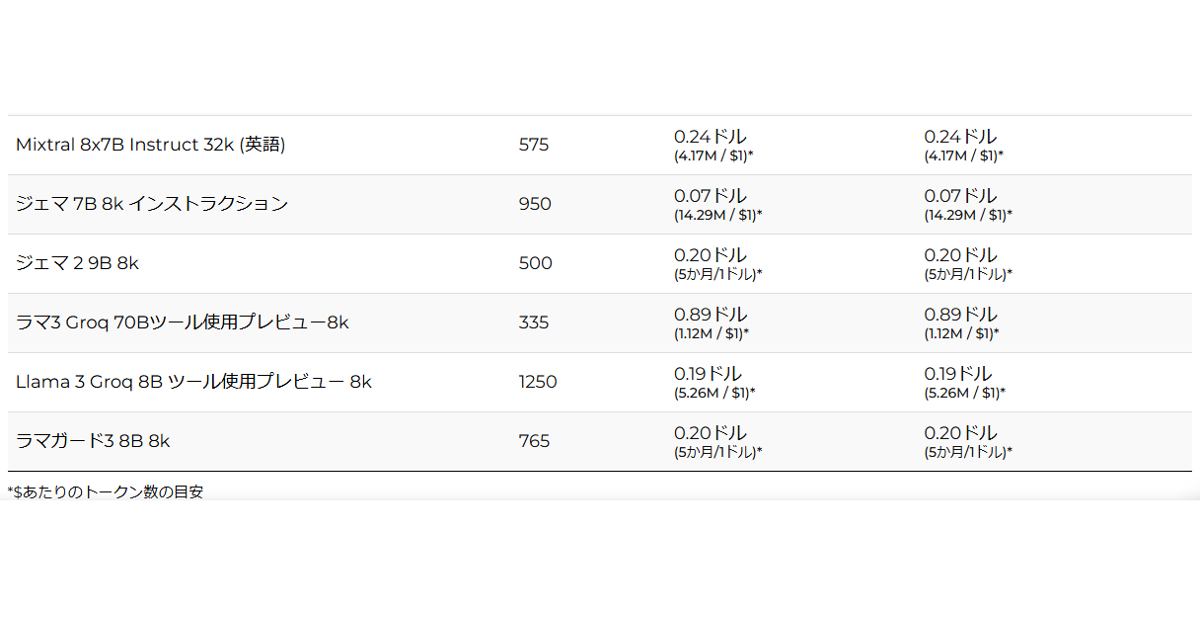

Groqの使用料金について、Groqを使用して大規模言語モデル(LLM)・自動音声認識モデル・ビジョンモデルを実行した場合の3つに分けてご紹介します。

画像出典:Groq 「Tokens-as-a-Serviceのオンデマンド価格設定」

Groqを使用して大規模言語モデルを実行した場合の入出力料金について、公式ホームページでは1秒あたりの出力トークン数・入力トークンの料金・出力トークンの料金が掲載されています。

入力トークン・出力トークン両方において0.04ドル〜0.89ドルまでと料金設定に幅があるため、自分の使いたい大規模言語モデルの料金を確認してから使うのが望ましいです。

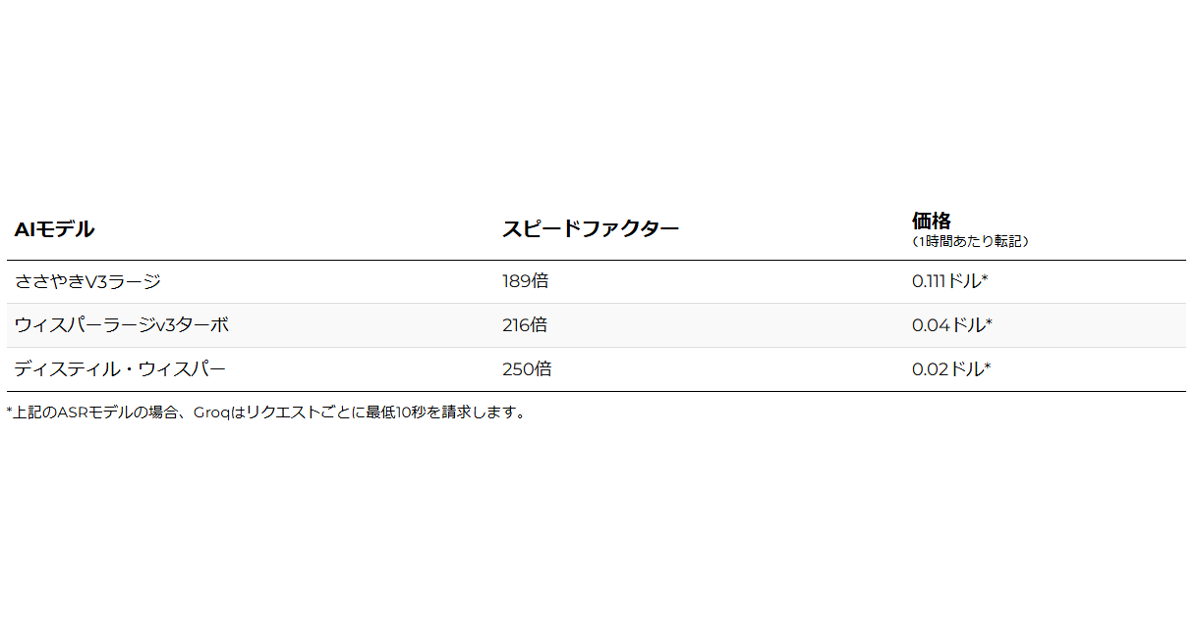

画像出典:Groq 「Tokens-as-a-Serviceのオンデマンド価格設定」

Groqを使用して自動音声認識モデルを実行すると、音声をテキストに変換することができます。

スピードファクターとは、自動音声認識の処理速度を表します。例えば、スピードファクターが189倍の場合、通常1分かかるタスクをGroqは約0.32秒(1分÷189)で完了します。

価格について、例えば0.111ドルなら、1時間分の音声をテキスト化した場合にかかる費用が0.111ドルという意味です。

こちらも大規模言語モデル使用の時と同様価格の幅が大きいので、費用が気になる人は確認してからの利用がおすすめです。

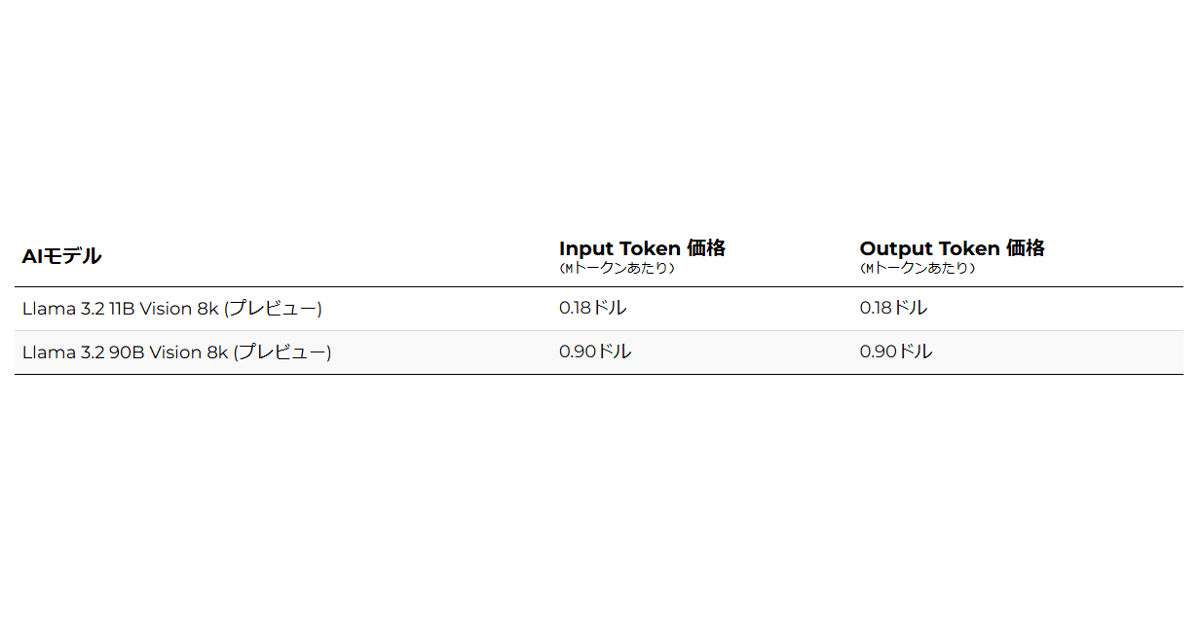

画像出典:Groq 「Tokens-as-a-Serviceのオンデマンド価格設定」

Groqを使用してビジョンモデルを実行すると、画像や映像のデータをテキストに変換できます。

料金は100万トークンあたりで計算され、入力しても出力しても同じ価格です。

例えばLlama-3.2 11B Visionモデルを使って100万トークンを入力し、同じく100万トークンを出力したとすると、0.18ドル×2(入力分と出力分)=0.36ドルとなります。

GroqとChatGPTの回答速度について比較実験をしてみたのでご紹介します。

ChatGPTが有利になるようプロンプトはChatGPTに作成してもらい、文字数もChatGPTに最適化しました。

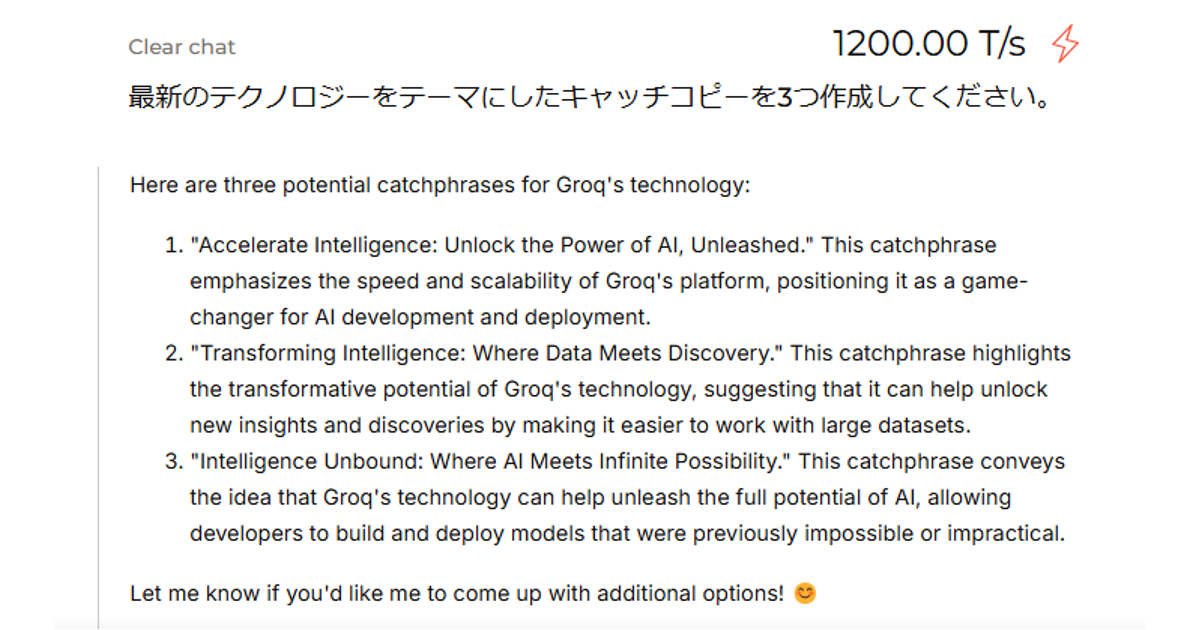

画像出典:Groq公式ホームページ

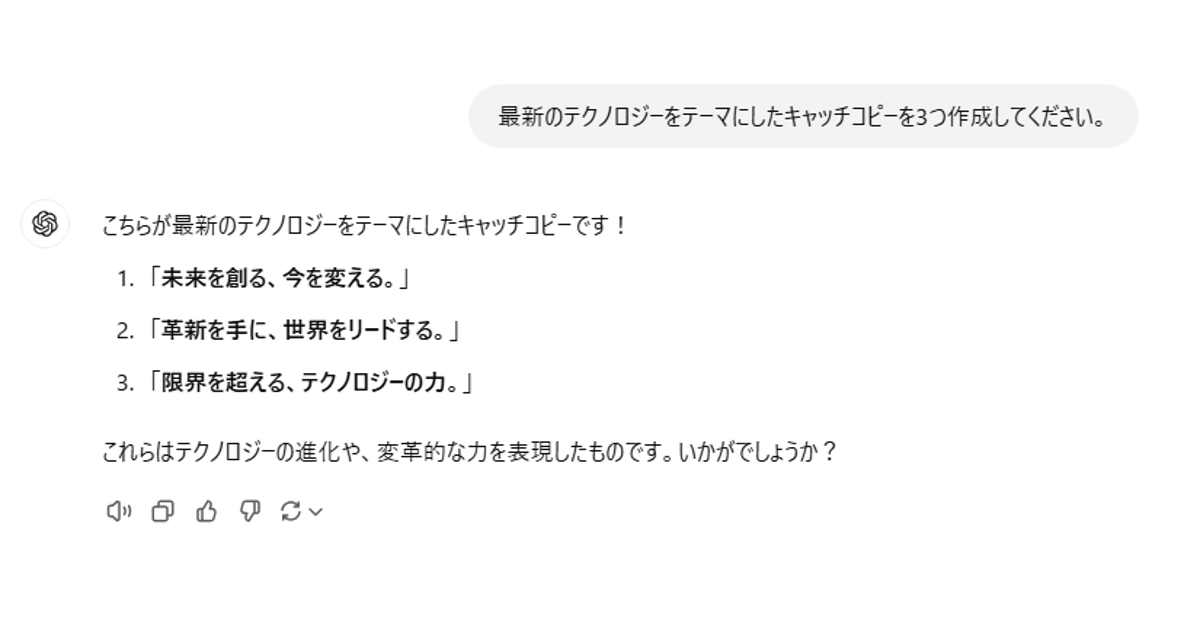

画像出典:ChatGPT公式ホームページ

最初に、ChatGPTでのプロンプトの文字数は50~150文字程度が適切とされる、簡単なタスクやアイデア生成において、GroqとChatGPTではどのくらい速度が異なるかを計測しました。

実験用のプロンプトは以下の通りです。

「最新のテクノロジーをテーマにしたキャッチコピーを3つ作成してください。」

生成されたキャッチコピーは画像の通りで、生成にかかった時間はGroqが0.14秒、ChatGPTが5.39秒でした。

なお、Groqのキャッチコピーを日本語訳すると次のような内容となります。

Groqは力強さを感じる表現を使い、ChatGPTは比較的万人受けしやすいやわらかい表現を用いているのが特徴的だと言えます。

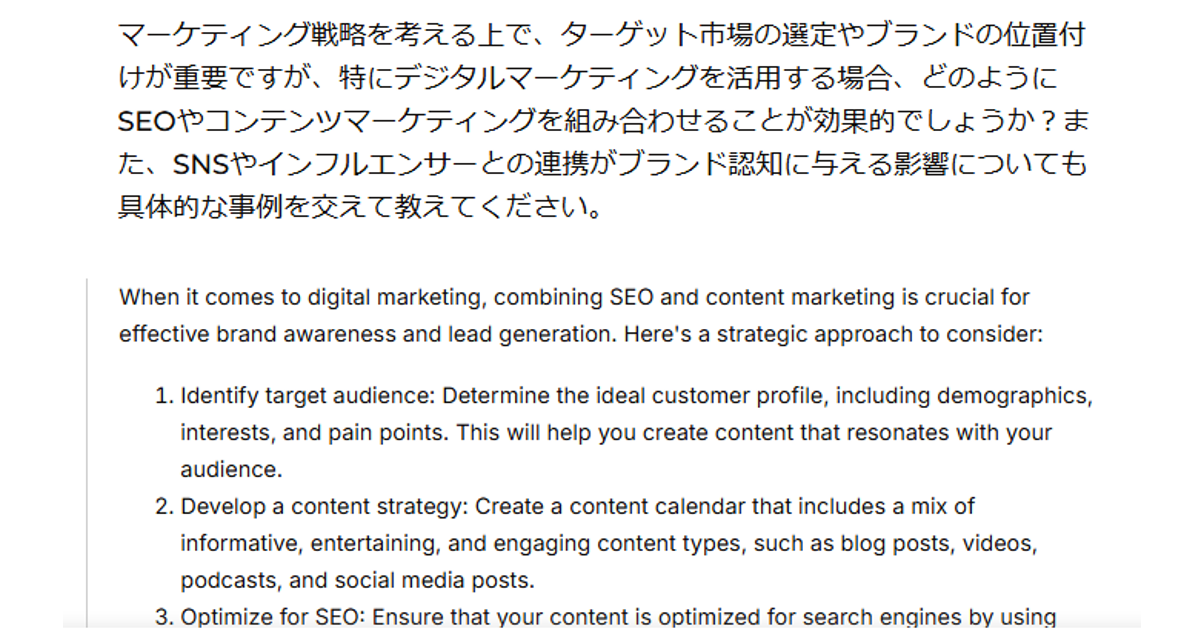

画像出典:Groq公式ホームページ

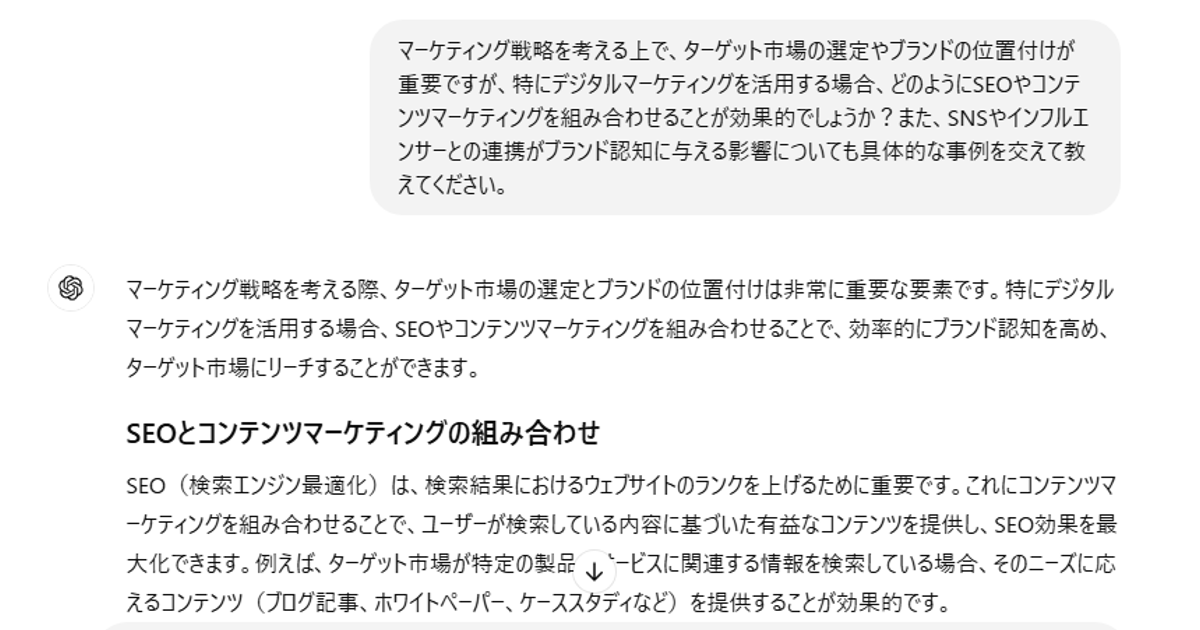

画像出典:ChatGPT公式ホームページ

次に、ChatGPTでのプロンプトの文字数は150~250文字程度が適切とされる、マーケティングについての質問回答において、どのくらい速度が異なるかを計測しました。

実験用のプロンプトは以下の通りです。

生成された回答は画像の通りで、生成にかかった時間はGroqが0.61秒、ChatGPTが17.06秒でした。

Groqが自分をマーケティングに活用したときのメリットも含めて回答したのに対し、ChatGPTは一般的な内容を簡潔に回答したのが印象的です。

画像出典:Groq公式ホームページ

画像出典:ChatGPT公式ホームページ

最後に、ChatGPTでのプロンプトの文字数は250~350文字が適切とされる、医療についての質問回答において、GroqとChatGPTではどのくらい速度が異なるかを計測しました。

実験用のプロンプトは以下の通りです。

生成された回答は画像の通りで、生成にかかった時間はGroqが0.55秒、ChatGPTが23.13秒でした。

Groqが要点を絞って簡潔に伝えているのに対し、ChatGPTは情報を整理して丁寧な文章で回答をしているのが特徴的だと言えます。

GroqとGroq.Incが開発・運営している対話型生成AIを指し、今までの生成AIと比較すると回答の生成速度が飛躍的に速いのが特徴的です。

この記事も参考にして、ぜひ業務の効率化のためにGroqを用いてみてください

業務の課題解決に繋がる最新DX・情報をお届けいたします。

メールマガジンの配信をご希望の方は、下記フォームよりご登録ください。登録無料です。

AI製品・ソリューションの掲載を

希望される企業様はこちら