生成AI

最終更新日:2026/02/10

ソブリンAI時代のインフラ戦略

ソブリンAI時代のインフラ戦略

※本記事は、2026年1月15日に行われたウェビナー「ソブリンAI時代のインフラ戦略 ~データ主権を担保するオンプレGPUサーバー基盤の最前線~」の内容をPR記事として構成したものになります。

生成AI・LLMの活用がPoCから本番フェーズへと移行する中で、「クラウド一択」だったインフラ戦略に変化が起きています。コスト・性能・セキュリティの要件を高度に満たすため、オンプレミスを組み合わせたハイブリッドなAI基盤構築が急速に広がっています。特に重要視されているのが、自社のデータを自社でコントロールする「データ主権(ソブリンAI)」の確保です。

本ウェビナーでは、デル・テクノロジーズ株式会社 インフラストラクチャー・ソリューションズ営業統括本部 製品本部 シニアプロダクトマネージャー 岡野 家和氏が登壇。ソブリンAI時代の設計思想から、最新のGPUアーキテクチャ、クラウドとのコスト比較まで、オンプレAI基盤を成功させるための戦略を解説しました。

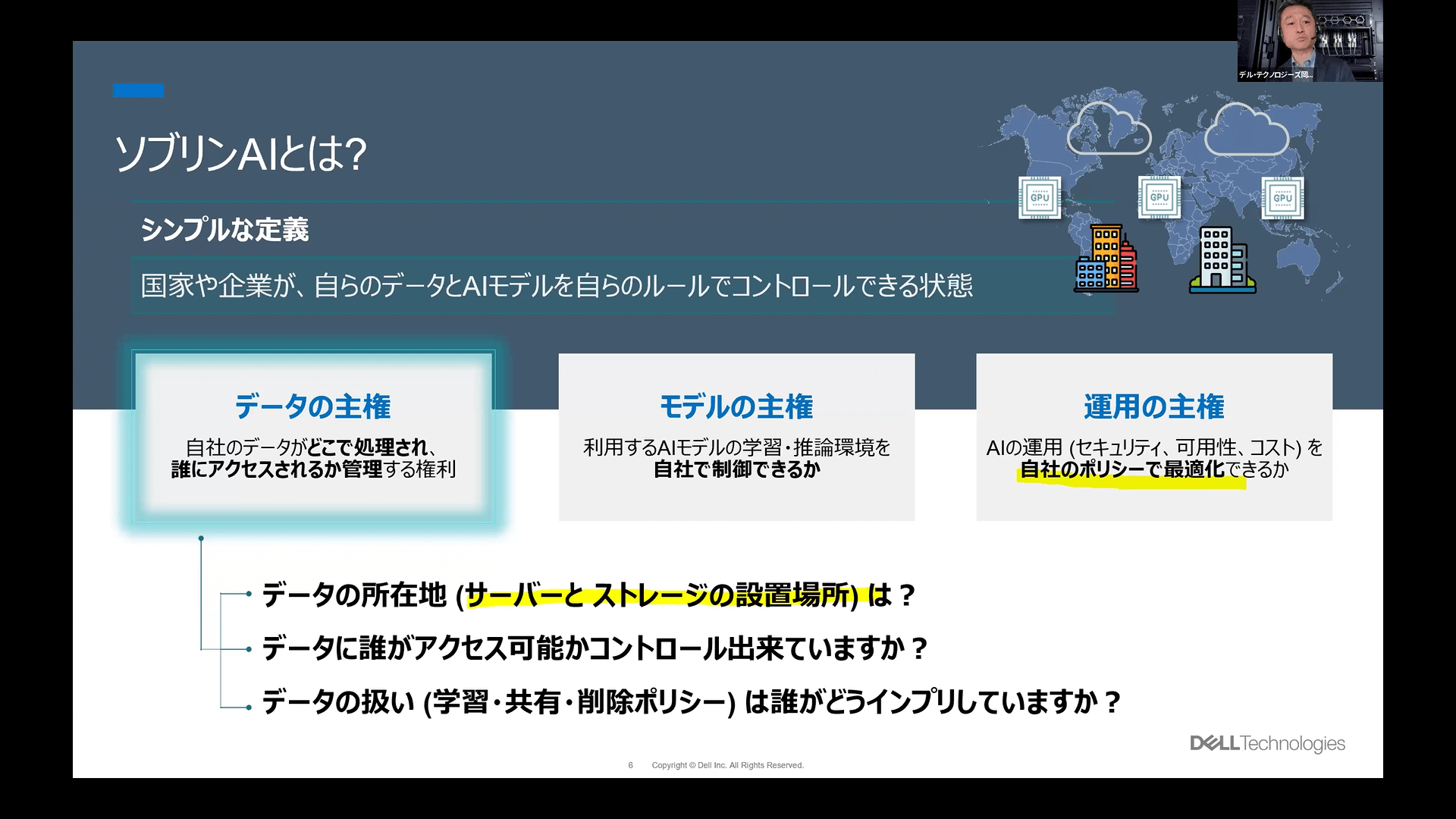

岡野氏はまず、ソブリンAIの定義と、その重要性について解説しました。ソブリンAIとは、「国家や企業が、自らのデータやAIモデルを自らの管理下でコントロールできる状態」であると述べました。

さらに細分化すると「データの主権」「モデルの主権」「運用の主権」という3つの要素に分けられ、中でも中心となるのが、自社データがどこで処理され、誰にアクセスされるかを管理する権利である「データの主権」です。

実際、どのような業種であっても、顧客情報や企業独自のノウハウ、医療情報といった「機微情報」は、AI活用への期待が高い一方で、セキュリティの観点から社外には出せない、規制により出せないものが多々あります。

こうしたデータを安全に活用し、AIの恩恵を最大化させるために、自社管理下で運用できるオンプレミス環境が今求められており、それがソブリンAIへの注目が集まる最大の要因となっています。

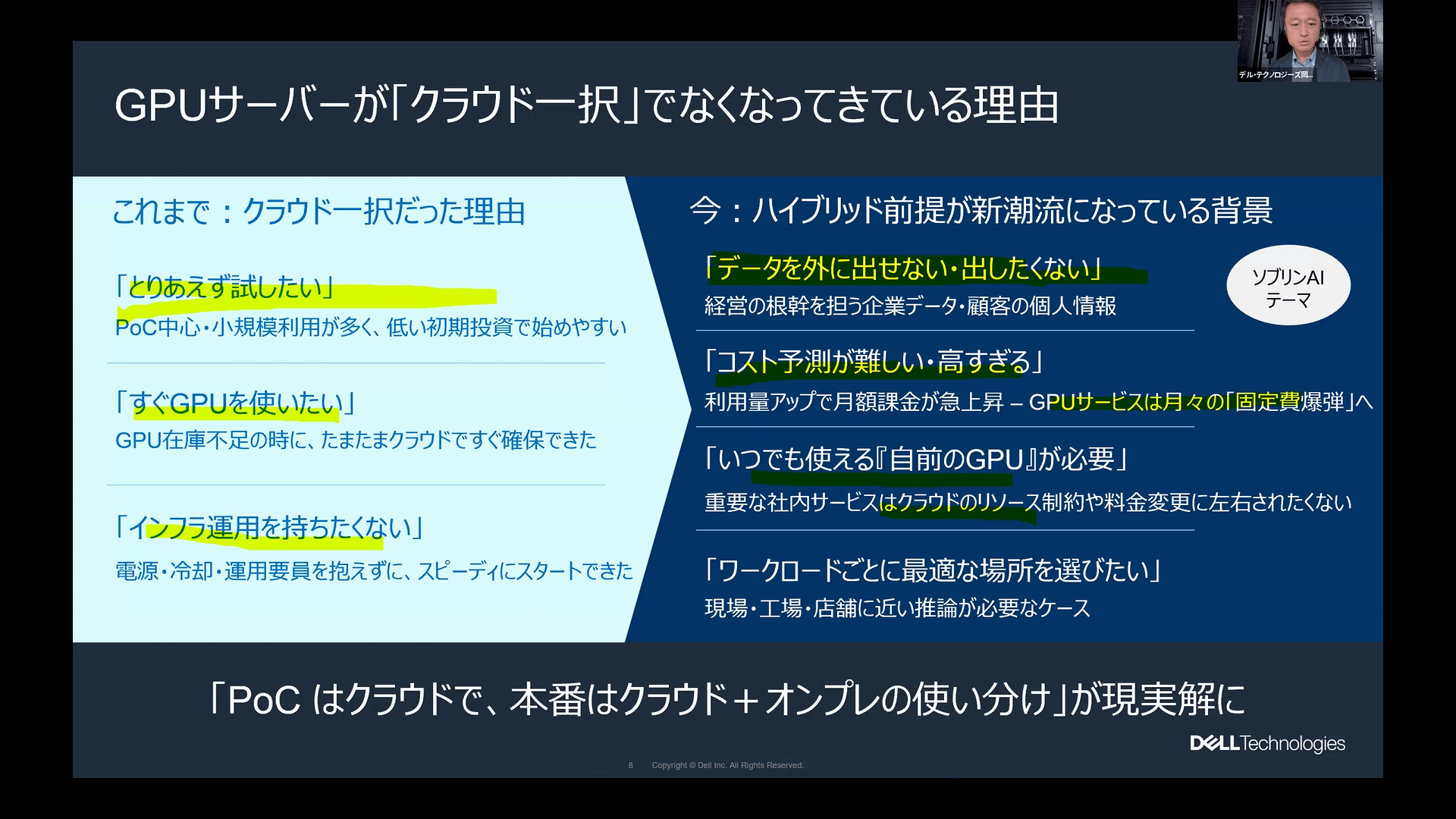

これまでGPUサーバーの導入といえば、初期投資の抑制やリソース確保の容易さから、「クラウド一択」という考え方が主流でした。しかし現在、その流れはハイブリッド利用を前提とする新潮流へと変わりつつあるといいます。

その背景には、「データを外に出せない・出したくない」というセキュリティ要件に加え、AI活用や研究が進むにつれ「利用量増大に伴うコストの急騰と予測の難しさ」や、人気のGPUが確保しづらい「リソース争奪戦」といった課題が顕在化しているためです。

こうした背景から岡野氏は、「PoCはクラウドで行い、本番環境では『いつでも確実に使える自前のGPU』としてオンプレミスを併用するハイブリッド活用が現実解となっている」と指摘します。

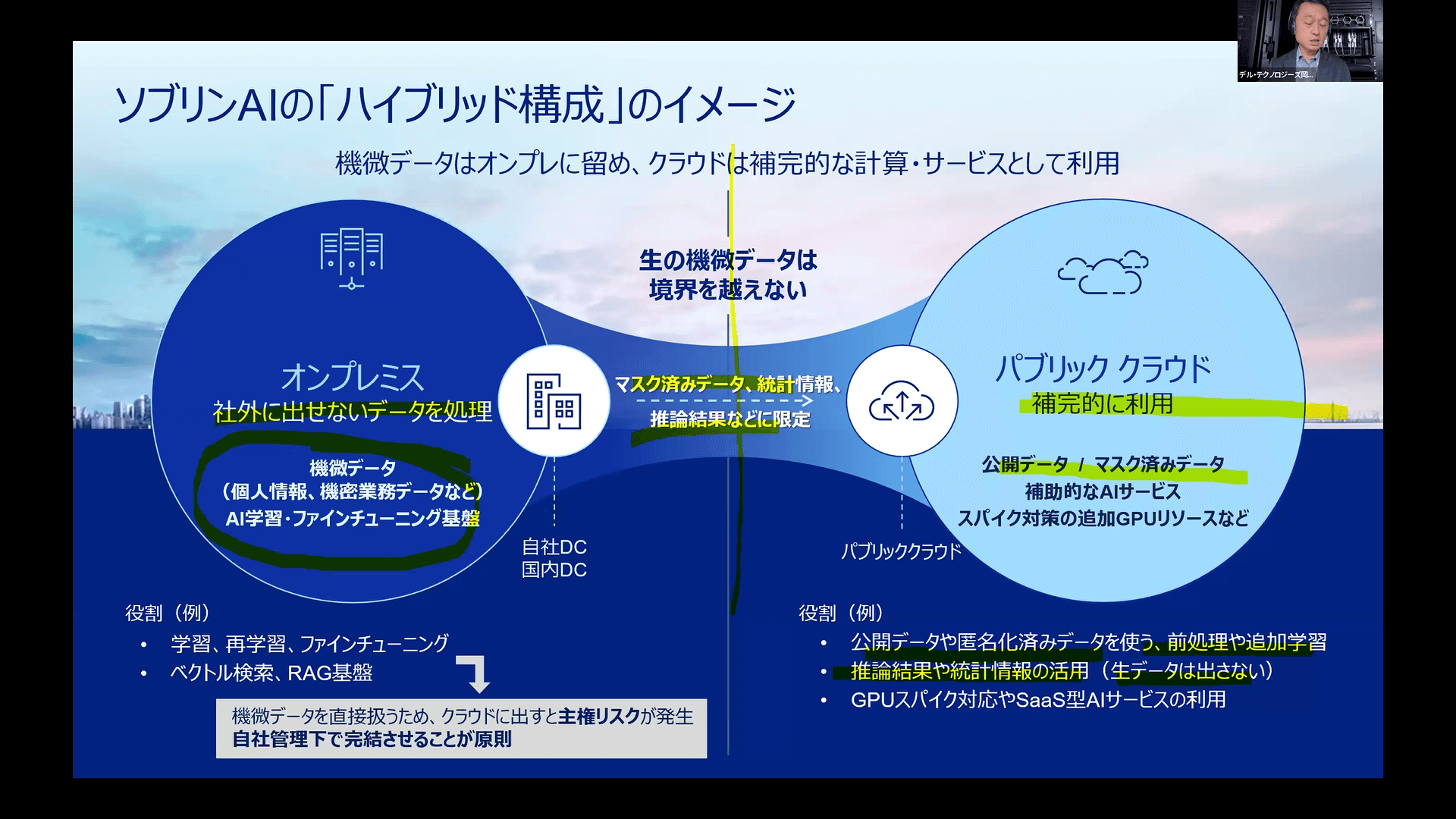

ここで重要となるのが、ソブリンAI時代における「ハイブリッド」の意味合いは、従来のものとは大きく異なる点です。従来のハイブリッドクラウドは、「アプリケーションやデータをシームレスに行き来させること」が目的でした。

一方で、ソブリンAI文脈での「ハイブリッド」は、「基本、データは動かさず計算(リソース)を動かす」という設計思想に基づき、どのデータをどこに置き、どこで使用するかを明確化することが目的となります。

具体的には、学習や再学習、ファインチューニング、RAG基盤など、機微データを直接扱う処理はオンプレミス環境に固定し、データ主権のリスクを排除します。

その上で、公開データや匿名化済みデータの処理など、クラウドに出してもリスクの少ない情報のみをクラウドで利用するなど、データの機密性に応じて場所を使い分ける構成こそが、ソブリンAI時代のハイブリッド戦略となります。

オンプレミスへの投資はハードルが高く感じられますが、岡野氏は「実際にはオンプレミスの方が圧倒的に安価になるケースが多い」とし、デル・テクノロジーズの顧客事例を紹介しました。

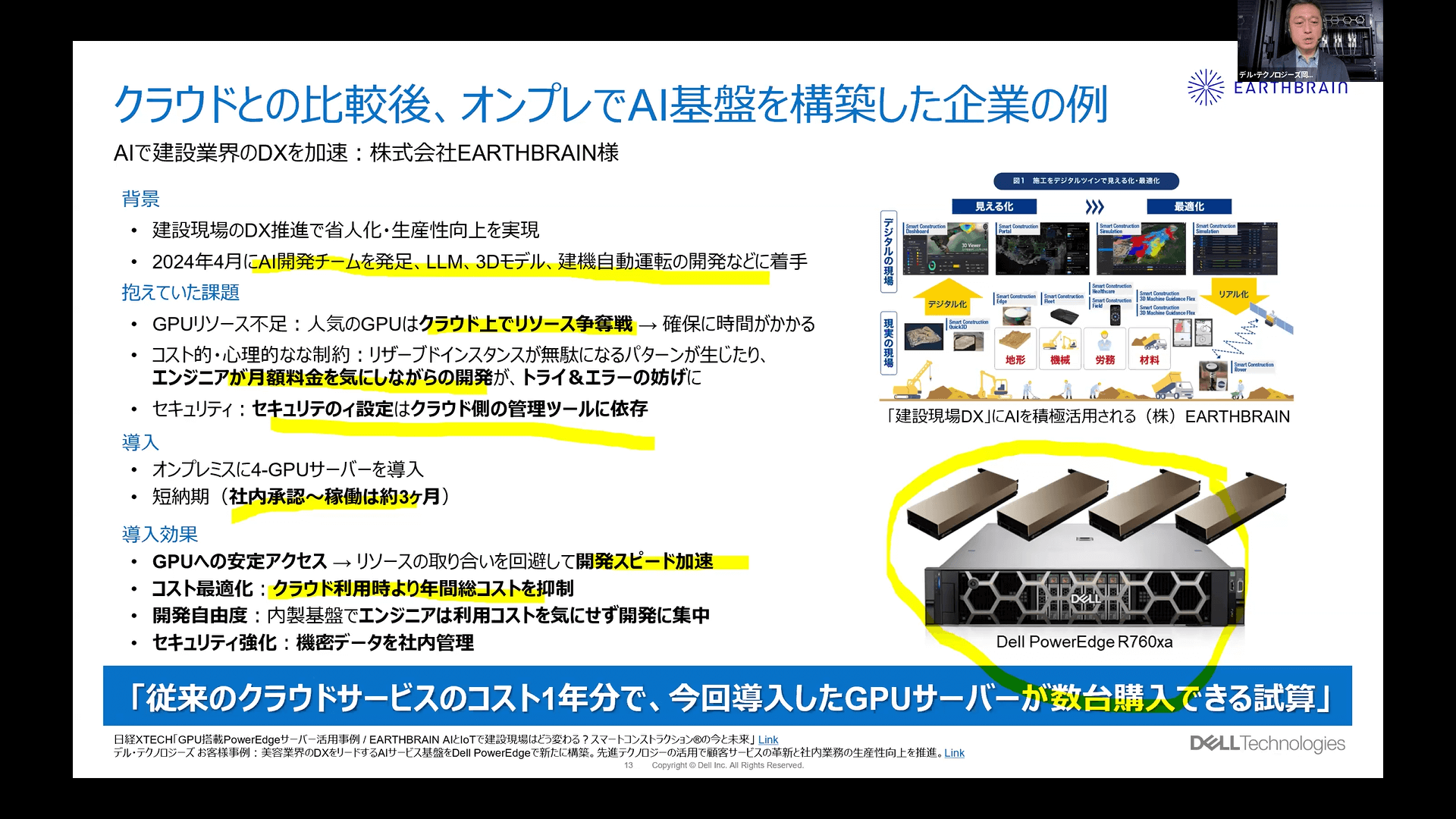

建設業界のDXを推進する株式会社EARTHBRAINでは、2024年4月にAI開発チームを発足し、LLMや3Dモデル、建機自動運転など様々なAI開発を行っています。EARTHBRAINは、当初はクラウドサーバーを利用していましたが、「オンプレミスでサーバーを保有してしまおう」と、導入に踏み切った事例です。

クラウドサーバーを利用する中で、人気のGPUリソースの確保に時間がかかる点や、コストを気にして試行錯誤(トライ&エラー)が抑制されてしまう点、セキュリティ設定がクラウド側の管理ツールに依存してしまう点などが課題に挙がっていました。

オンプレミスへの移行後、わずか3ヶ月で稼働を開始。驚くべきことに、「クラウド利用料の約1年分で、導入したGPUサーバー数台分が購入できる」という試算が出ており、コストを気にせず開発に集中できる環境を実現しました。

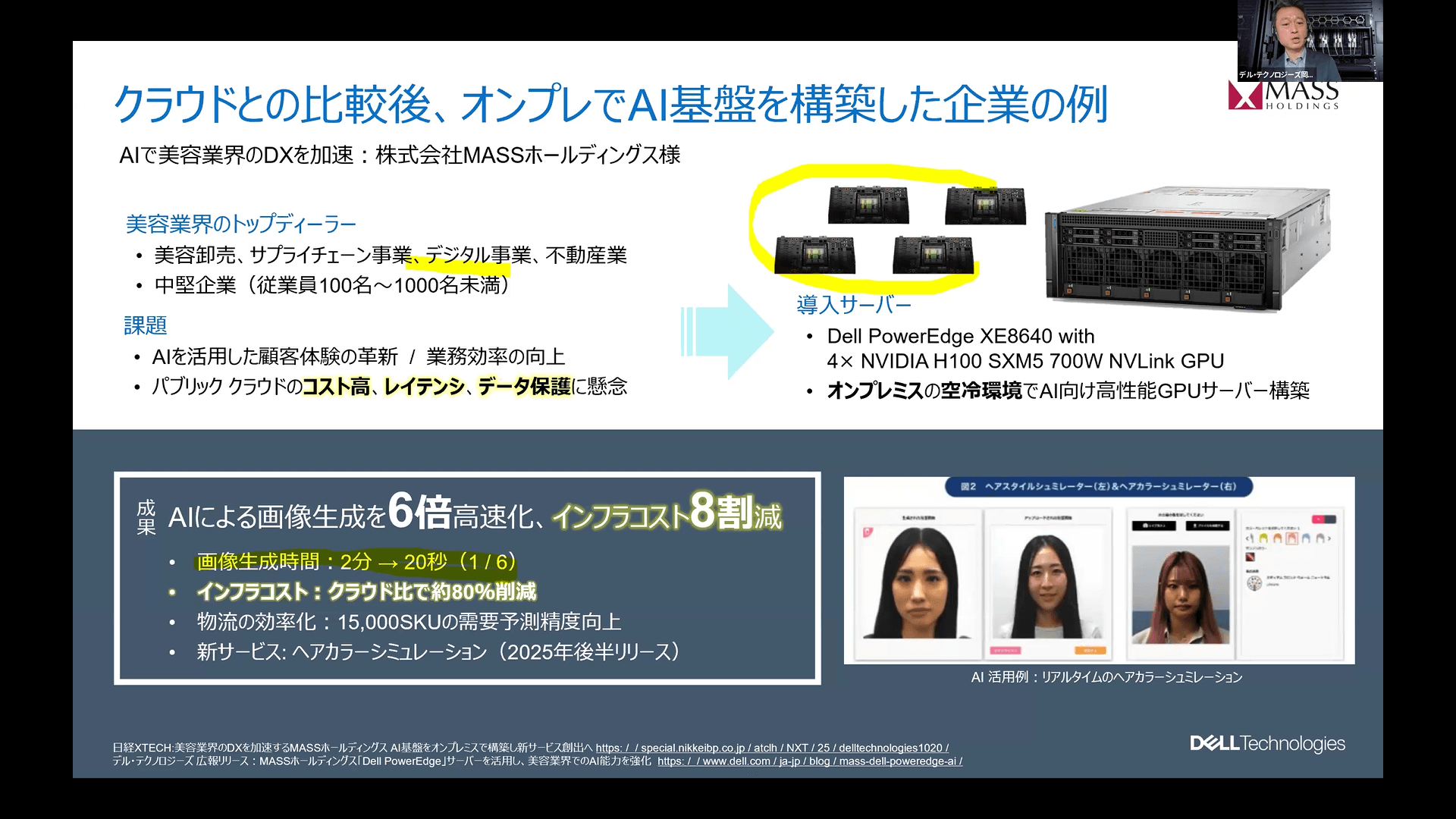

もう一つの事例として、AIで美容業界のDXを行う株式会社MASSホールディングスの事例も紹介。同社は、リアルタイムで顧客の写真からヘアカラーシミュレーションなどの画像生成にAIを活用しているほか、美容機器の流通における需要予測にもAIを導入しています。

パブリッククラウドのコスト高とレイテンシ(応答時間)、データ保護が課題でしたが、オンプレ基盤の導入によりインフラコストを約8割削減でき、さらに画像生成時間も6分の1に短縮されるなど、劇的なパフォーマンス向上を果たしました。

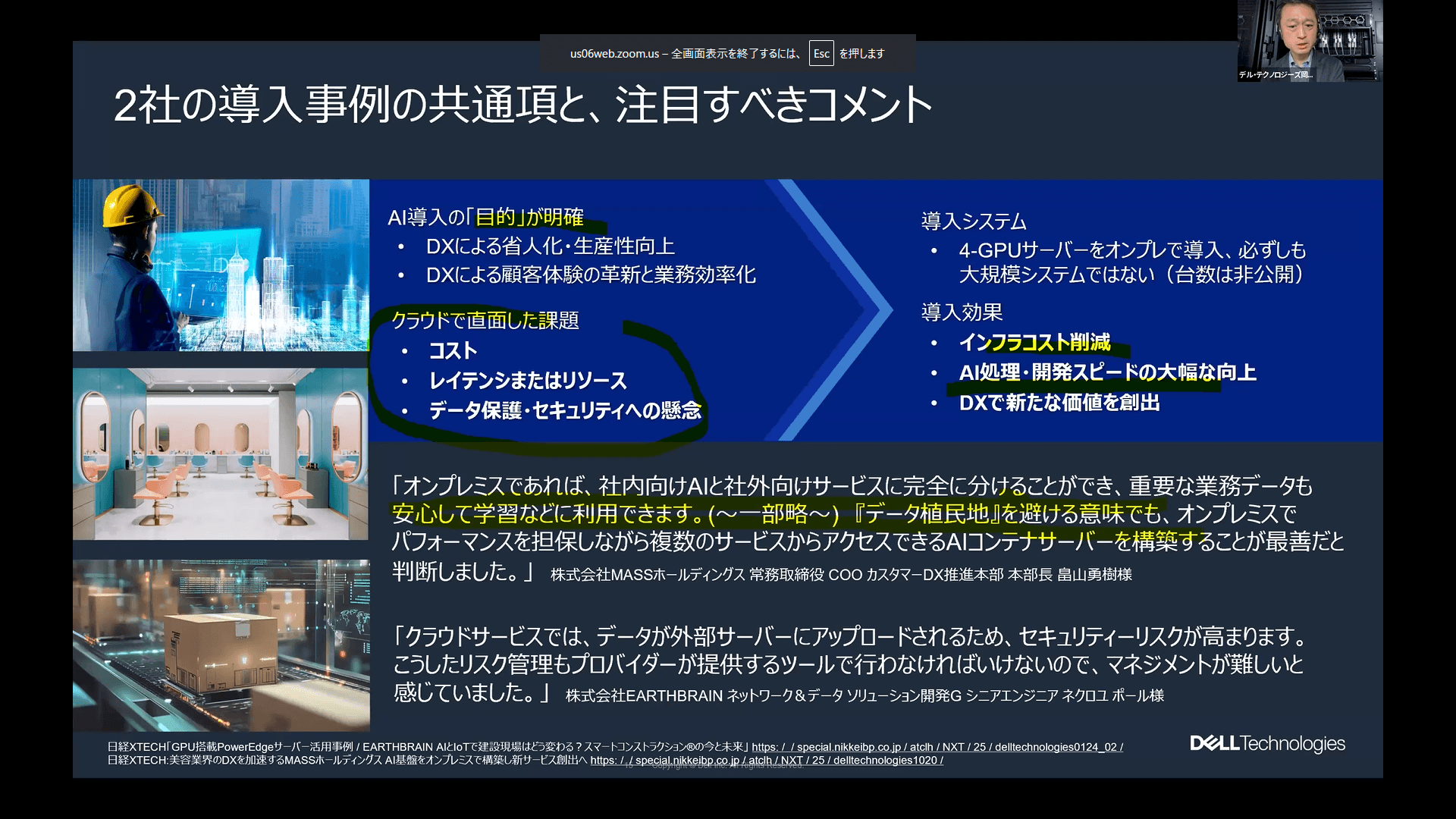

全く違う業界の2つの事例でしたが、どちらもAI導入の目的が明確であり、クラウドで直面した課題も「コスト」「リソース」「セキュリティ問題」という点で共通していました。GPUサーバー導入後の顧客の声としても、オンプレミスへの回帰によってセキュリティ問題の懸念点が解消できたとしています。

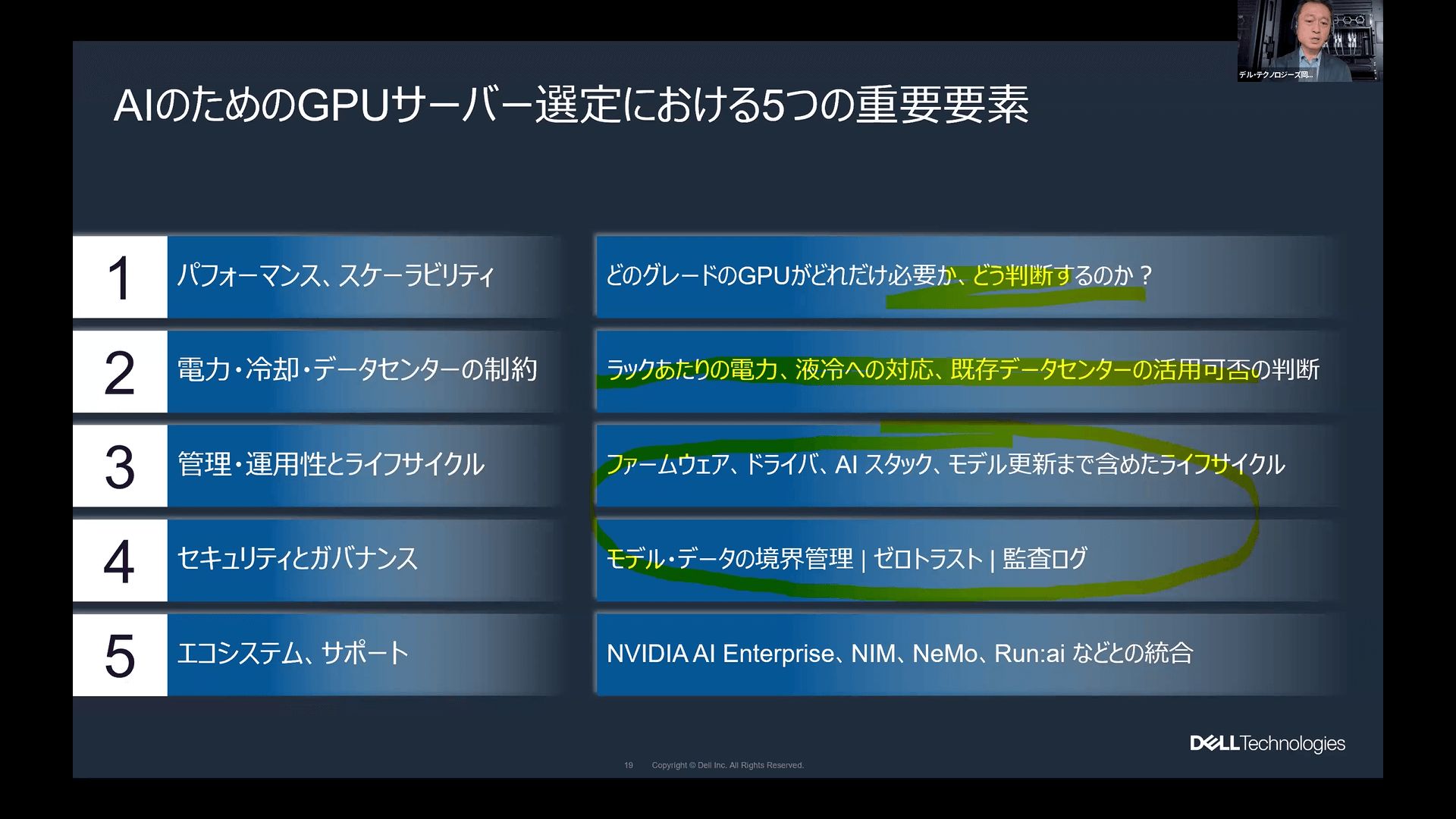

GPUサーバーの必要性は理解できたものの、具体的にどのような基準で選べばよいのかという疑問に対し、岡野氏より選定の重要ポイントが解説されました。

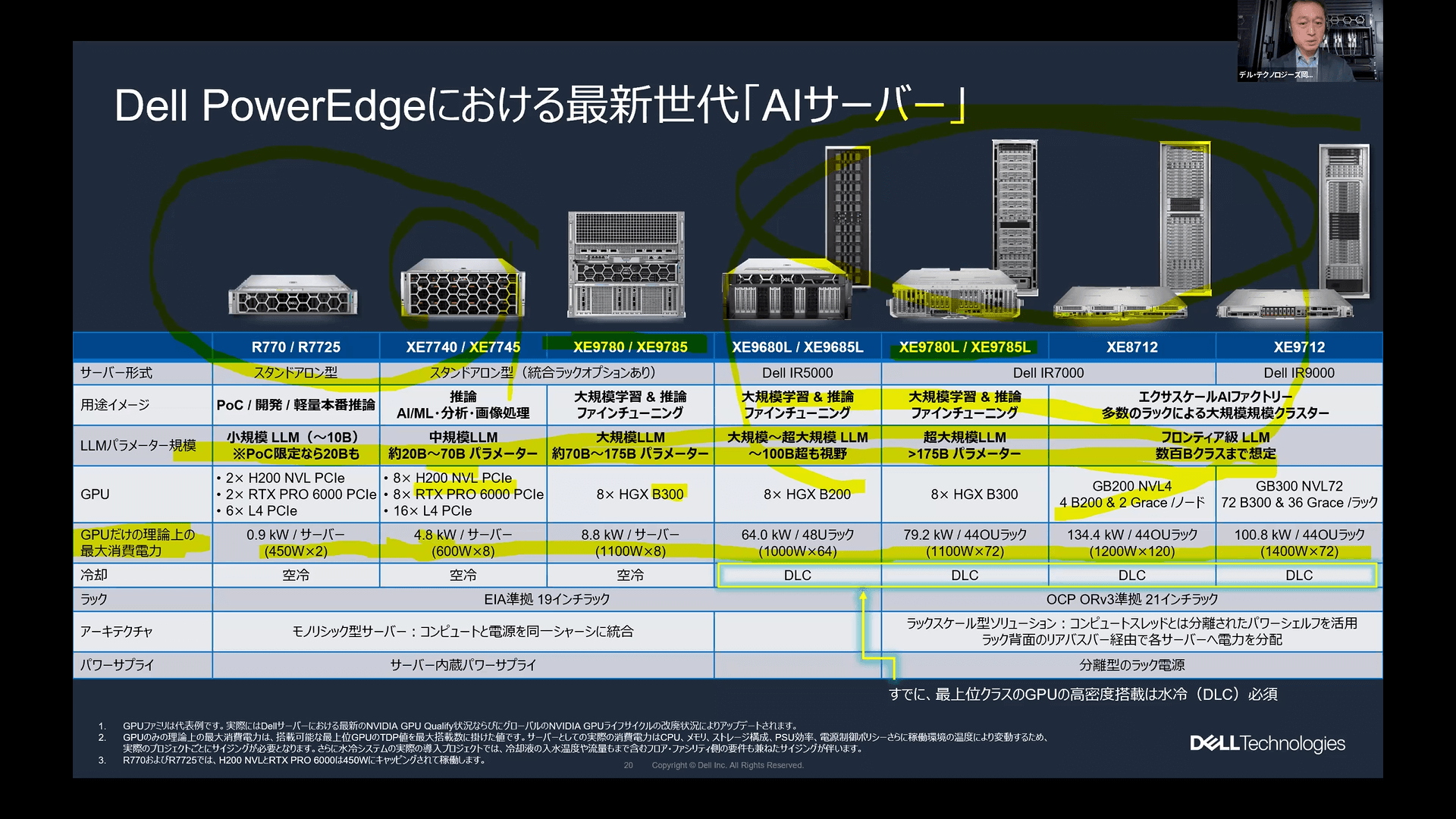

まず前提として、現在のGPU市場はNVIDIAが一強の状態にあり、その中でも「Blackwell」世代が新たな主流となっています。

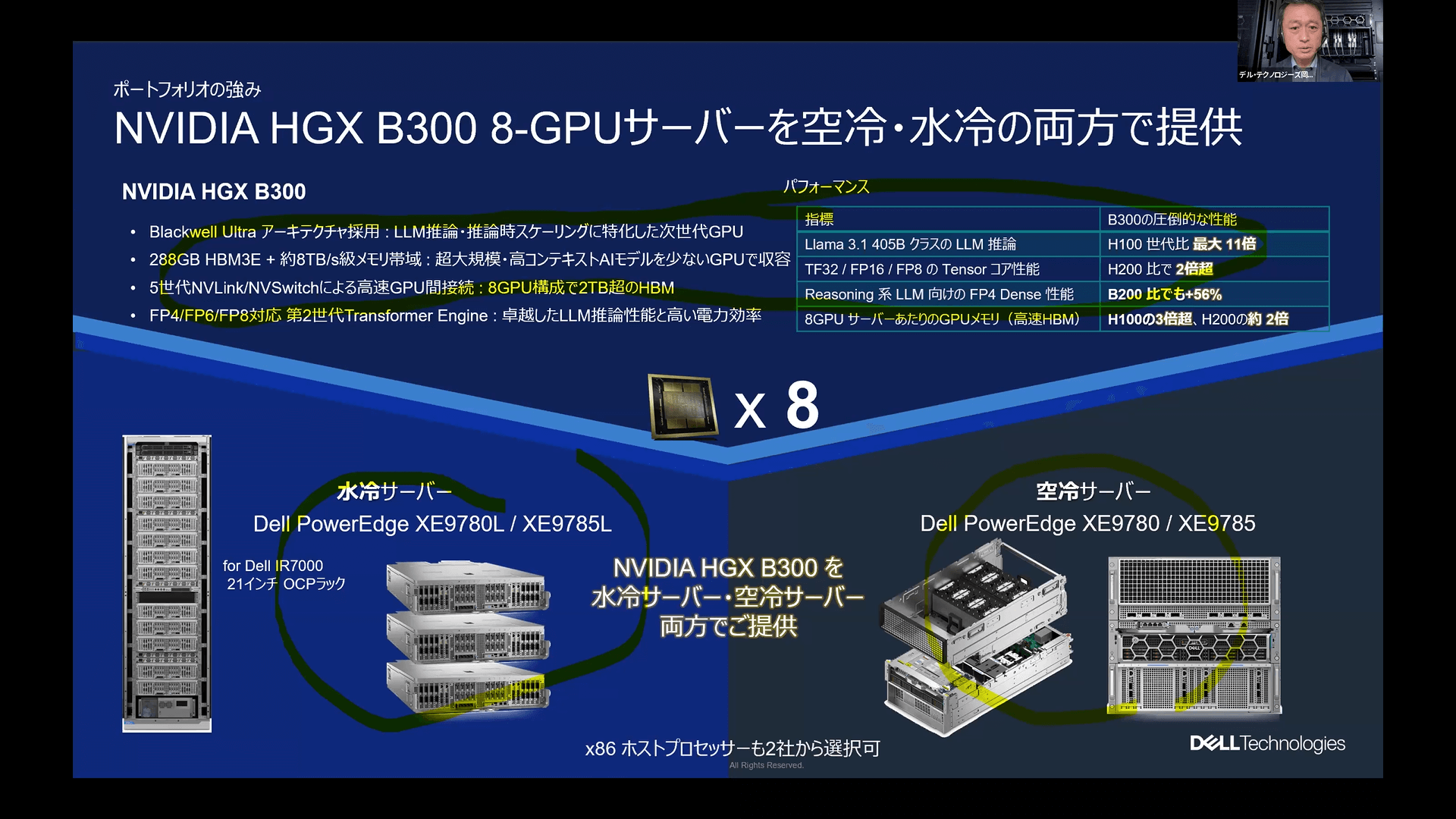

NVIDIAが提供するBlackwellには大きく分けて2つの形態があります。一つはデータセンター向けの単体GPUやモジュールとして提供されるB200やB300シリーズ、もう一つはGPU、CPU、ネットワーク構成までをNVIDIAが一体設計したラックスケール製品のGB200やGB300シリーズです。

B200やB300といったシリーズは、構成によっては空冷環境での運用も可能ですが、GB200やGB300シリーズのようなラックスケール製品は、システム全体の極めて高い熱密度を処理するため、水冷を前提とした設計となっています。

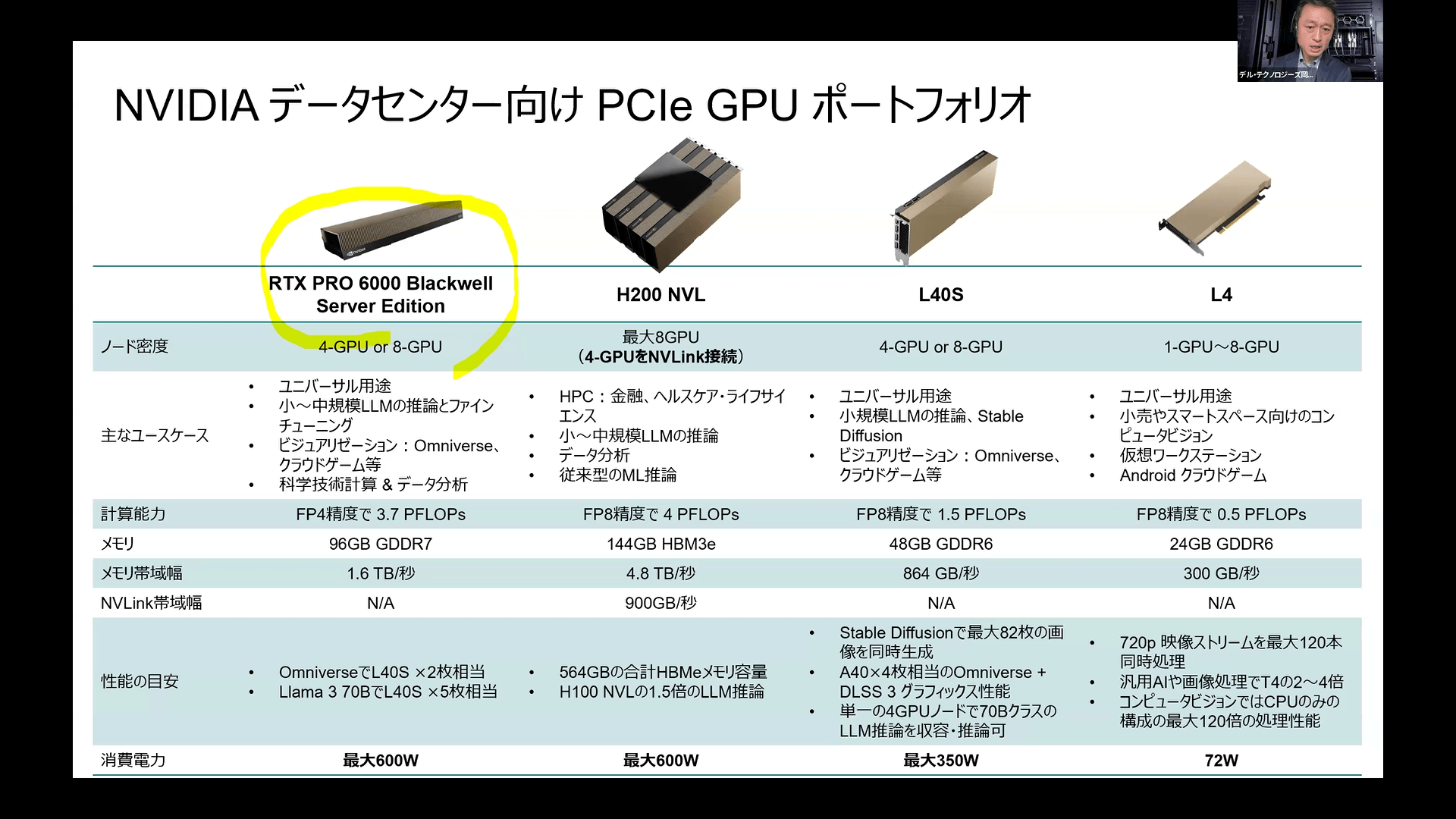

また、これらとは別にデータセンター向けのPCIe型GPUも引き続き提供されており、RTX PRO 6000 Blackwell Server Editionなどのモデルもリリースされています。

こうした技術動向を踏まえ、AIのためのGPUサーバー選定においては「パフォーマンス、スケーラビリティ」、「電力・冷却・データセンターの制約」、「管理・運用性とライフサイクル」、「セキュリティとガバナンス」、「エコシステム、サポート」という5つの要素を総合的に判断することが不可欠です。

パフォーマンスとスケーラビリティのみを追求するのであればGB200やGB300などの水冷ラックスケールが最高峰となりますが、自社のワークロードやデータ規模、パラメータ数に合わせて「どのGPUをどれだけ導入するべきなのか」を最適化することが重要になります。

これに対して、デル・テクノロジーズでは、空冷サーバーから水冷ラックスケールまで、顧客のAIデータセンターの用途イメージに合わせて多様な選択肢を提供しています。

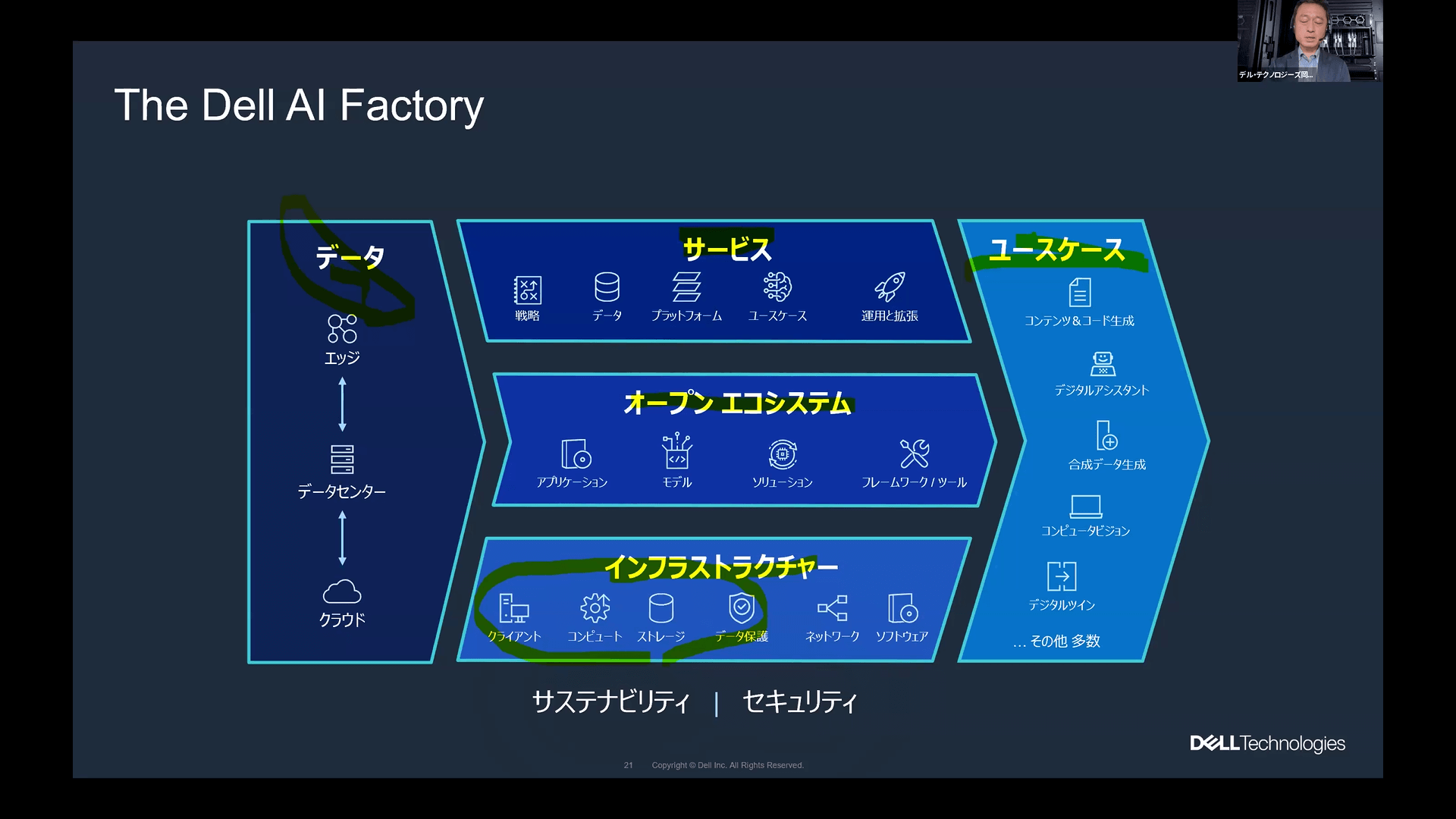

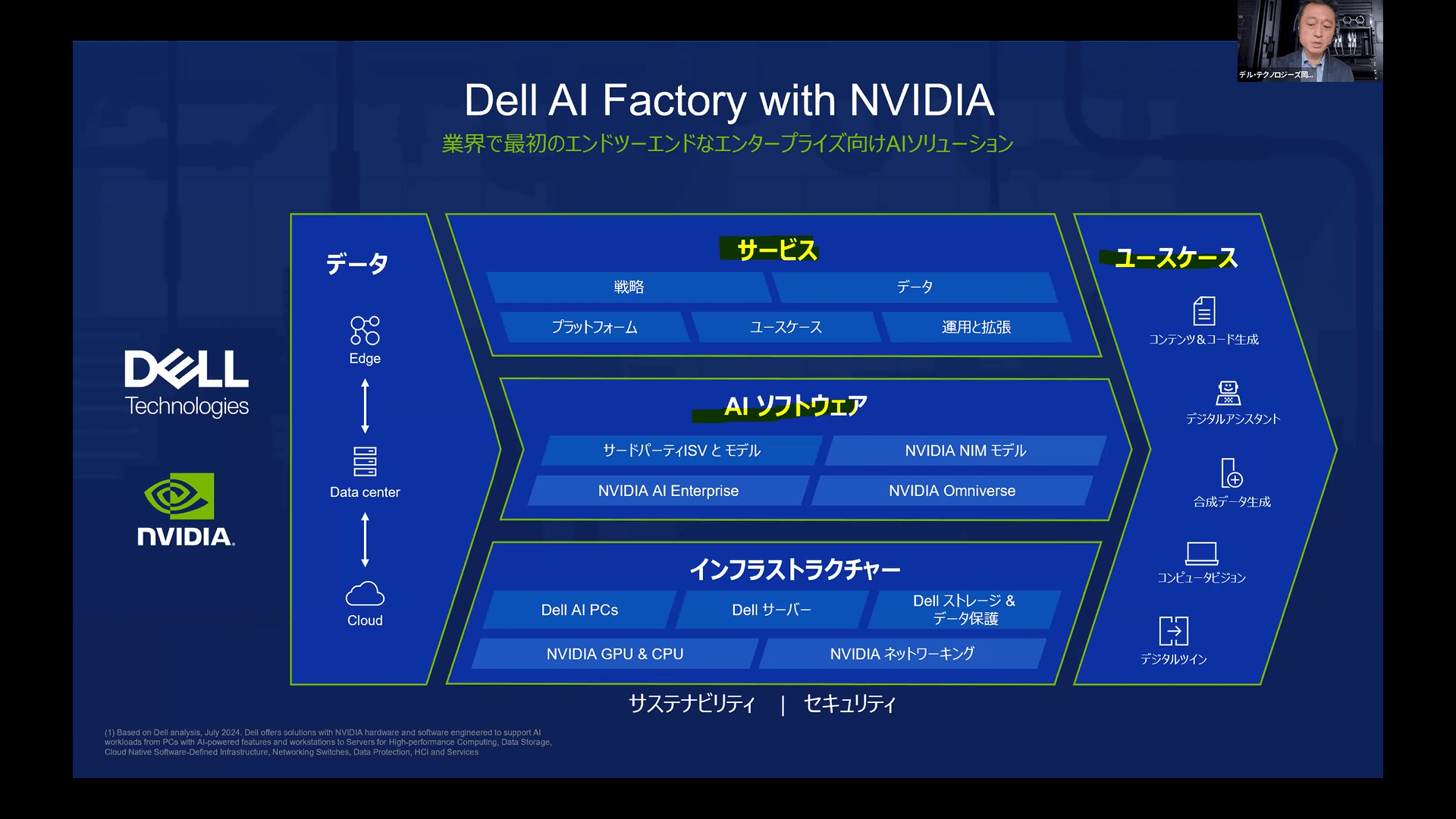

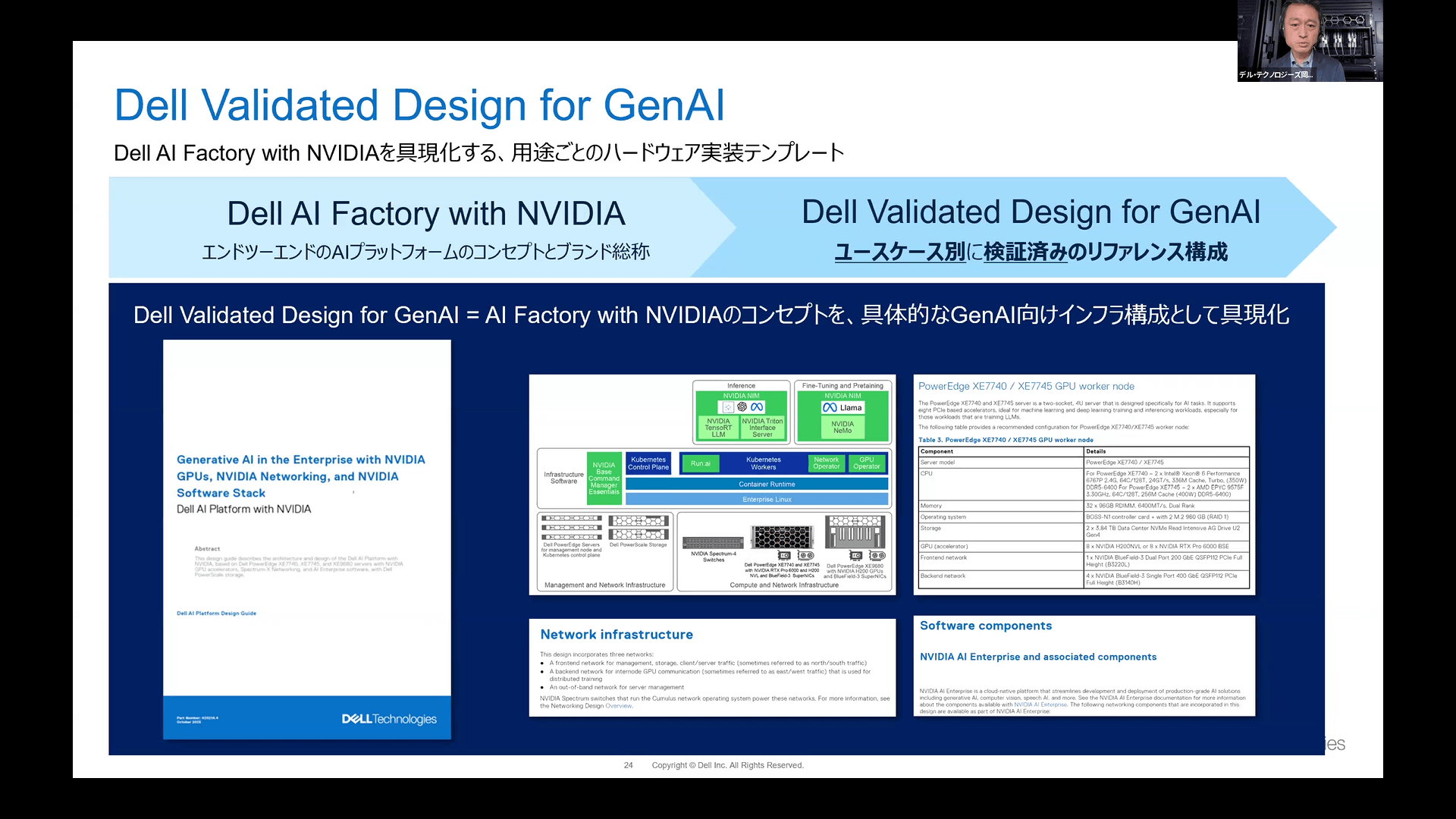

さらに、「Dell AI Factory」というコンセプトを掲げ、ハードウェアだけでなくソフトウェアやコンサルティングを含めたトータルな支援体制を整えています。

その中核となる「Dell AI Factory with NVIDIA」では、NVIDIAのエコシステムに特化したソリューションを提供しています。具体的な要件が決まっていない段階でも、ユースケースごとに検証済みのリファレンス構成である「Dell Validated Design for GenAI」を活用することで、最適なインフラを具体化することが可能です。

具体的な空冷サーバーの代表例として紹介された「Dell PowerEdge XE7740 / XE7745」は、最新のPCIe GPUを最大8基搭載可能です。

8基搭載時の冷却問題を解決するため、CPU部分とGPU部分を2階層構造に分け、12基の大型高性能ファンをGPU冷却に専念させる設計を採用しています。

搭載されるNVIDIA RTX PRO 6000 Blackwellは、前世代の同レベル帯だったL40Sと比較し、トークン生成速度が約4.8倍、電力効率は約9.8倍、またAIデータセンター用であったH100と比較しても電力効率が約1.6倍向上しており、大幅な性能向上が実現されています。

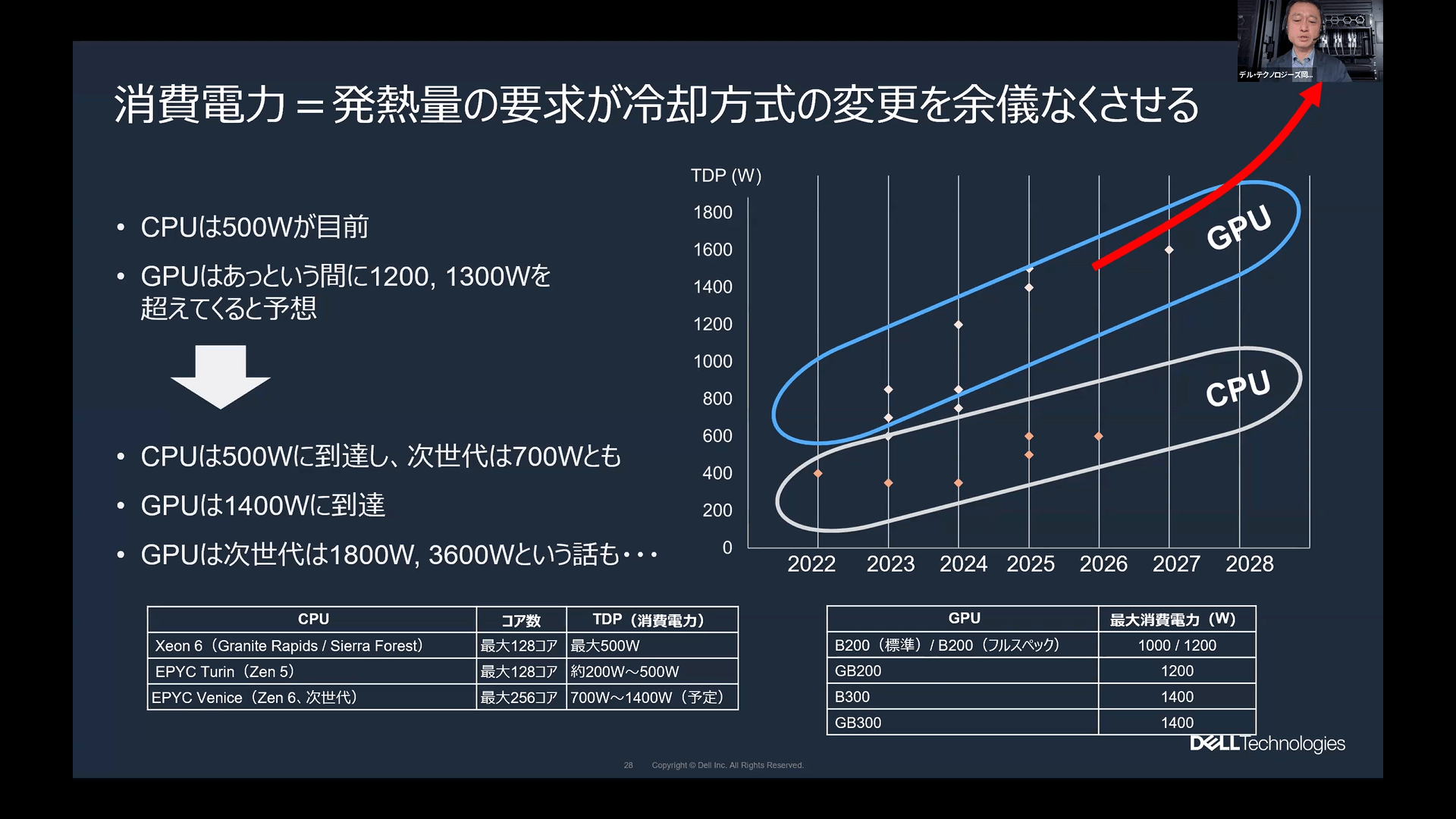

現在、CPUやGPUの消費電力は急速に増大しており、特にハイエンド構成においては空冷での冷却が限界に達しつつあります。また、空冷システムでは物理的なスペースの制約も大きく、サーバーの高密度実装が困難になるという課題も無視できません。

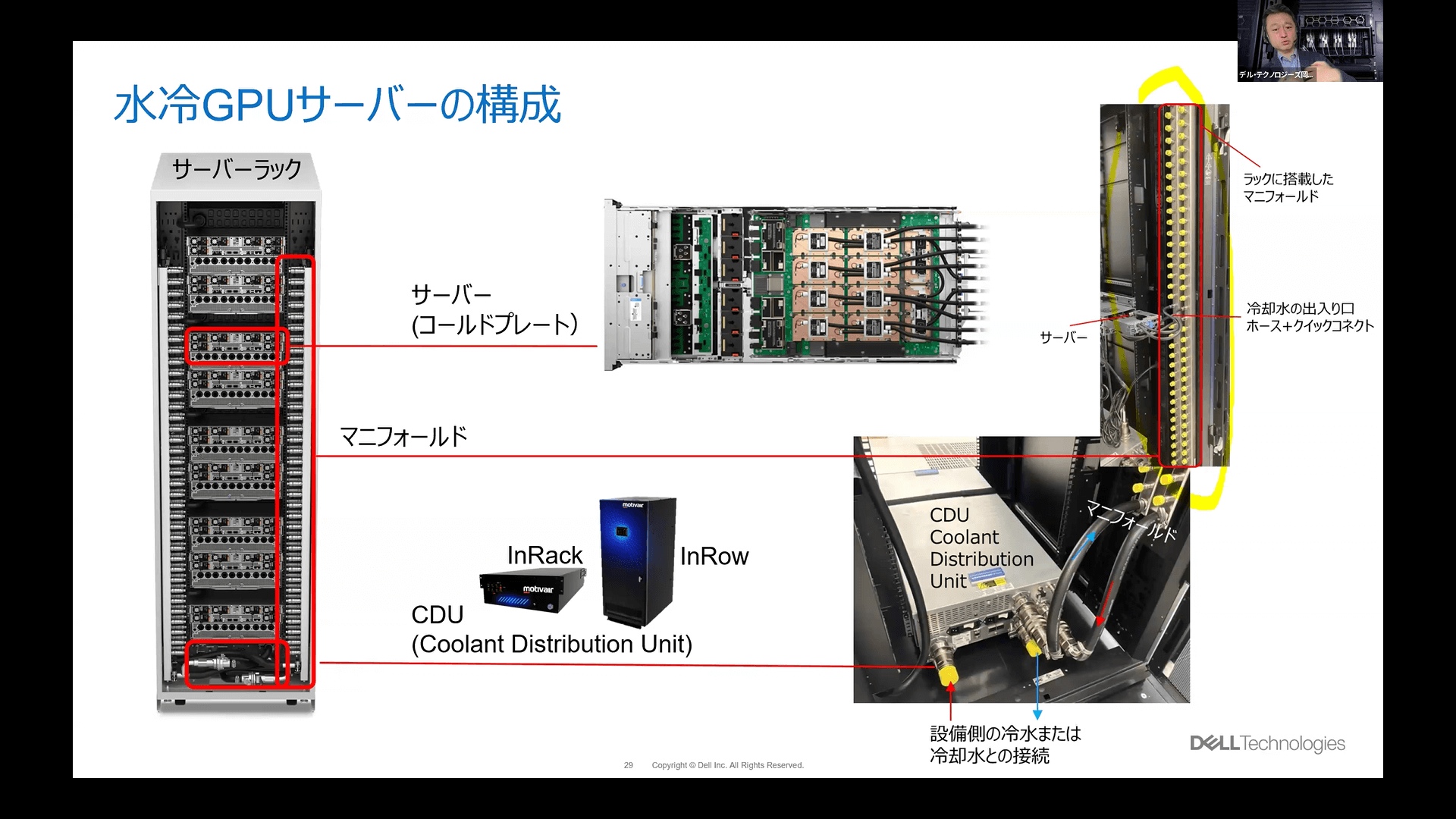

それらの課題に応えるのが水冷システムです。水冷の導入には専用の冷却設備や配管工事が必要となるものの、デル・テクノロジーズは今後さらに進むGPUの高性能化と発熱量の増加を見据え、水冷サーバーのラインナップを急速に拡大させています。

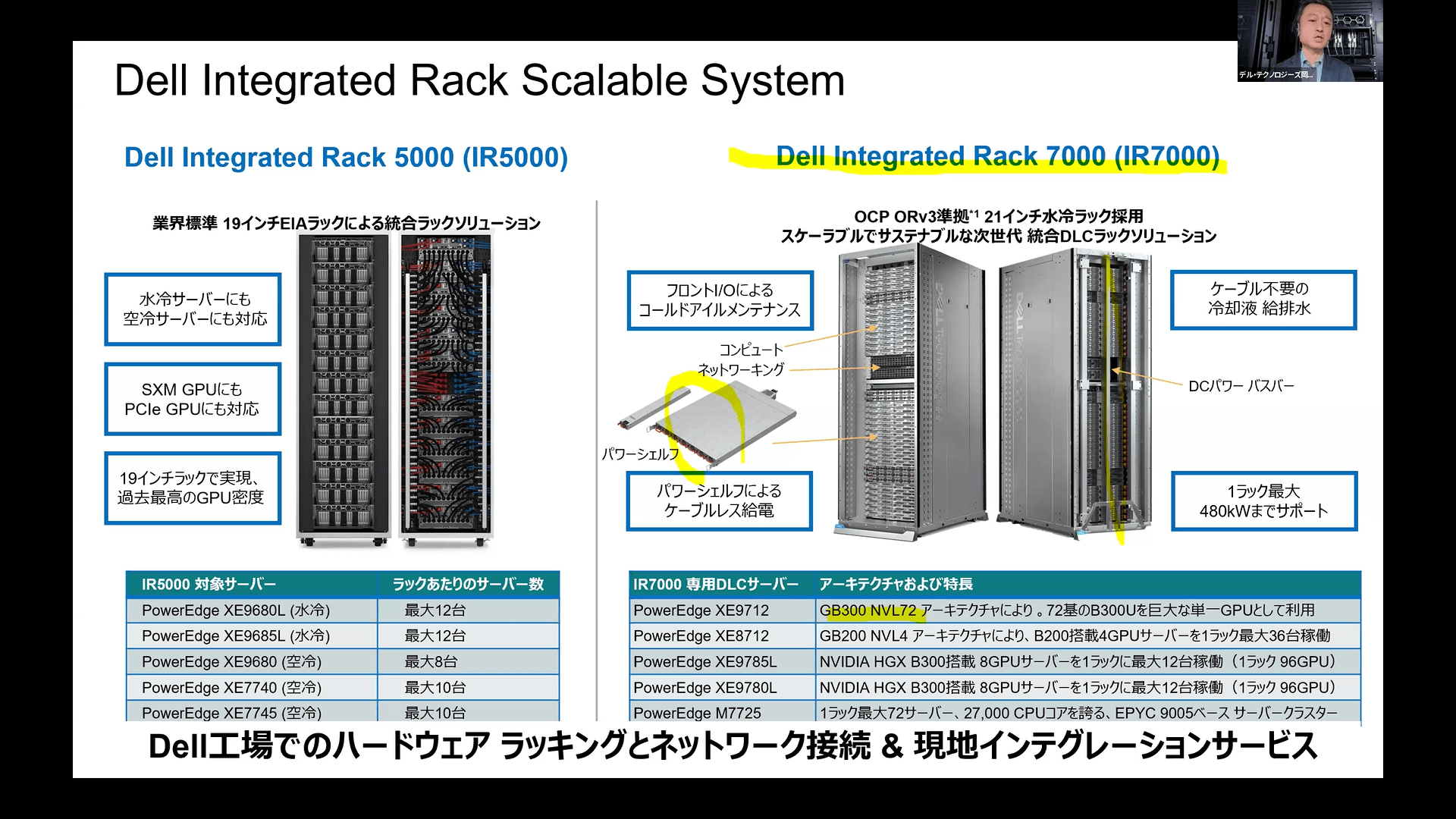

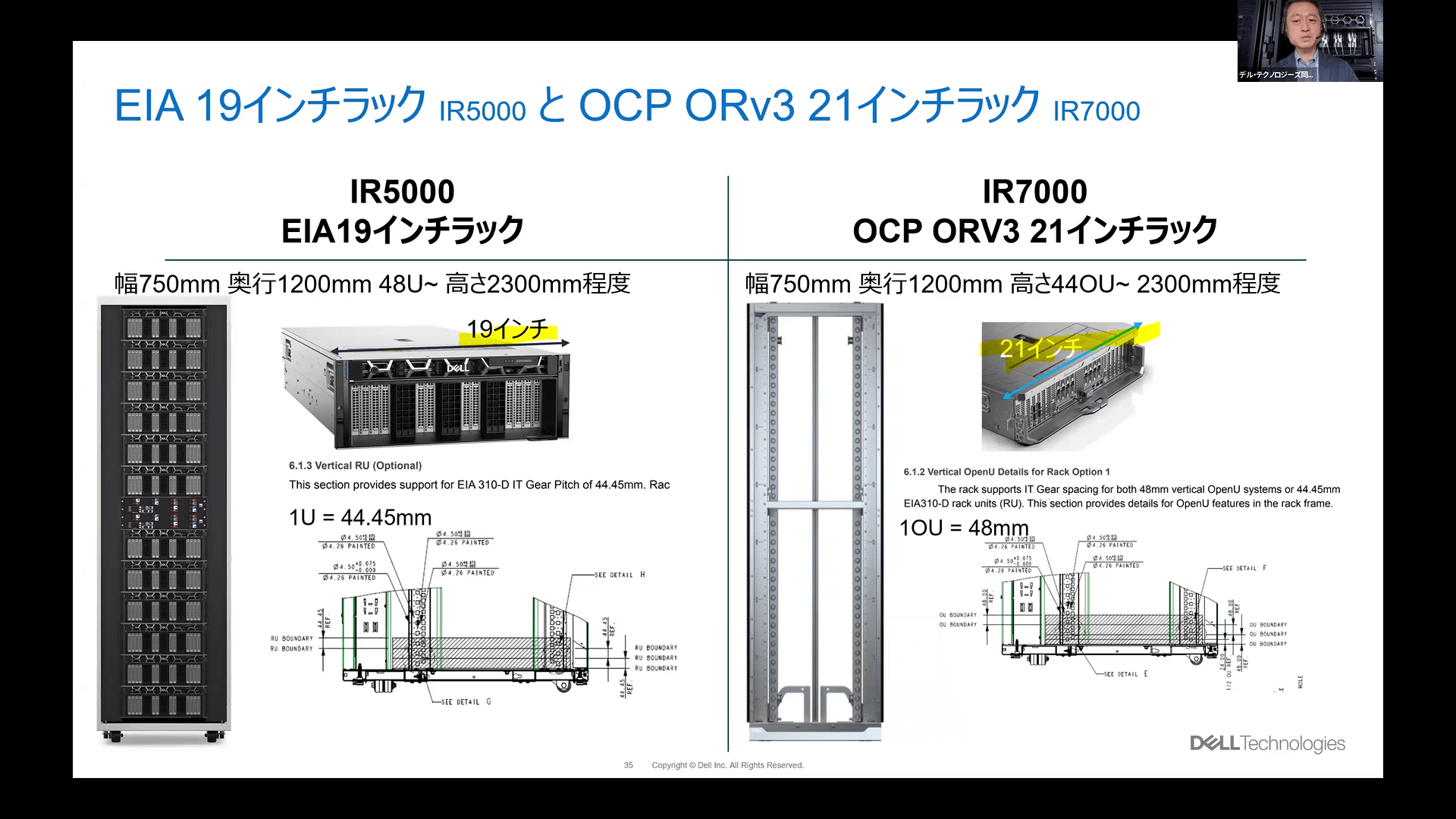

デル・テクノロジーズが提供するラック統合サービスには、主に2つのラインナップが用意されています。一つはOCP規格に準拠した21インチ水冷ラックの「Dell Integrated Rack 7000(IR7000)」、もう一つは業界標準である19インチEIA規格を採用し、空冷と水冷の両方に対応した「Dell Integrated Rack 5000(IR5000)」です。

特にIR7000は、最新のNVIDIA GB300 NVL72アーキテクチャに対応しており、それ以外にも複数のGPUサーバーに対応できる柔軟性を持っています。ラック構造も従来のものと大きく異なり、フロントI/Oによる前面側でのメンテナンスや、パワーシェルフとバスバーによるケーブルレス給電を可能にしています。

また、ブラインドメイト接続によって冷却液の配管からホースを排除しており、従来の背面がケーブルやホースで埋め尽くされる問題を解消し、スマートな運用環境を実現しています。

なお、21インチラックであっても外寸幅はIR5000と同じ750mmであるため、データセンターの設置面積を変えずに高密度化を図ることができます。

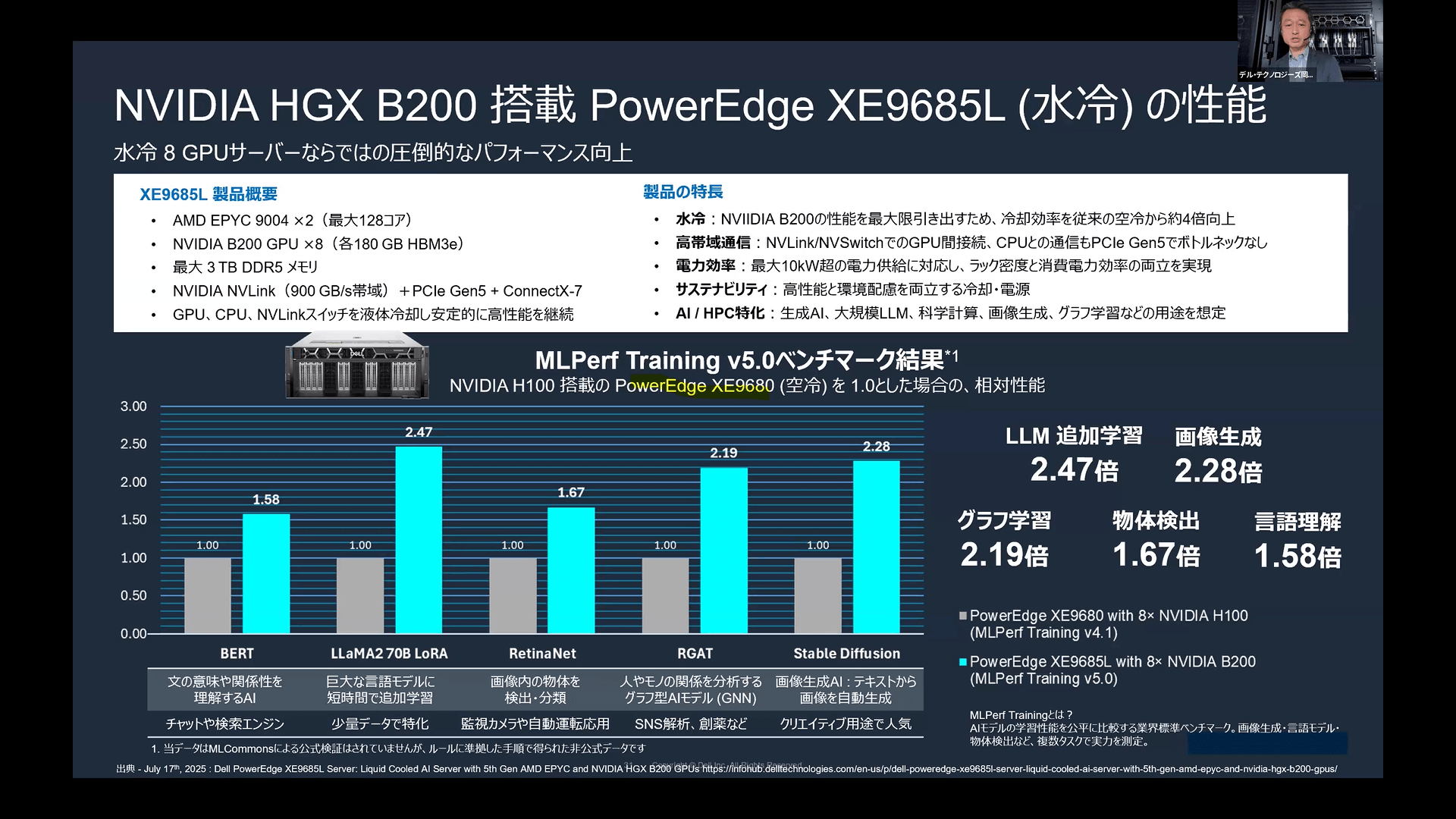

水冷仕様のNVIDIA HGX B200を搭載した「PowerEdge XE9685L」と、空冷のNVIDIA H100を搭載した「PowerEdge XE9680」の性能を比較すると、その差は歴然で、LLM追加学習で2.47倍、画像生成で2.28倍、グラフ学習で2.19倍、物体検出で1.67倍、言語理解で1.58倍と、冷却方式の選択がAIの「速度」に直結することが示されています。

デル・テクノロジーズの「Dell PowerEdge」が持つ大きな強みは、ハイエンドなNVIDIA HGX B300搭載機において、他社では選択肢が限られがちな中で空冷と水冷の両方のモデルを提供できる柔軟性にあります。

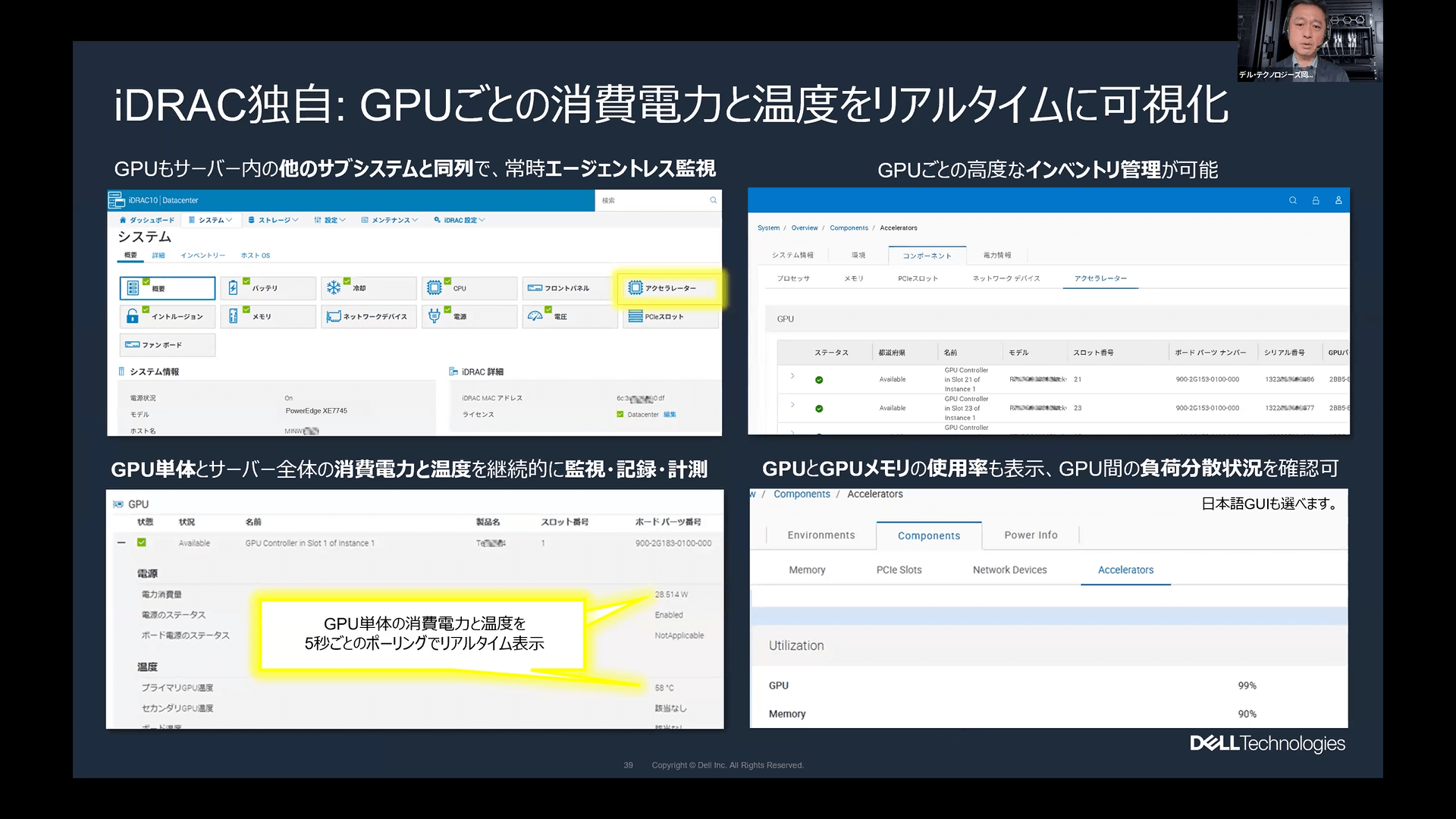

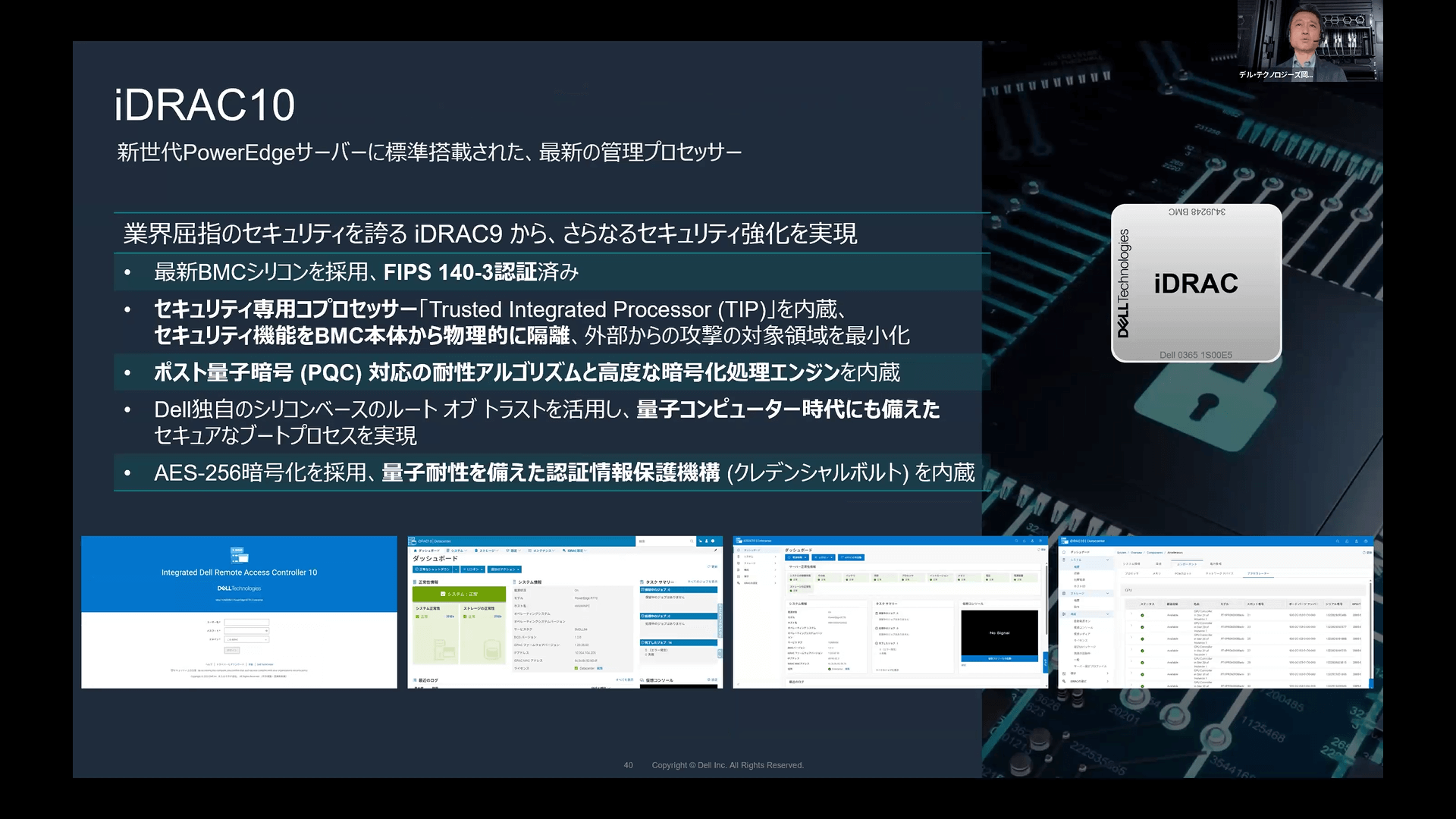

また、「Dell PowerEdge」サーバーに搭載されたリモート管理機能「iDRAC」は、他社製品と比較してもGPUの監視能力が非常に高く、詳細な電力や温度の可視化ができる点において、顧客からも高い評価を得ています。

そしてソブリンAI、すなわち「データの主権」を物理層から守るためには、そのデータを入れるサーバー自体のセキュリティが堅牢でなければなりません。

最新の「iDRAC10」では、将来的な脅威である量子コンピュータによる解読にも耐えうる「量子耐性」を備えた認証情報保護機構を内蔵しており、セキュリティに徹底的にこだわった設計となっています。

導入後の運用を支えるテクニカルサポートについても、国内の正社員エンジニアが一次窓口から対応する手厚い体制を構築しています。

さらに、世界的な需要増で納期が課題となる中で、デル・テクノロジーズは強固なサプライチェーンとサプライヤーとの緊密な連携を活かし、リードタイムの最小化を実現している点もオンプレミス回帰を検討する企業にとって大きな安心材料となっています。

岡野氏は「ソブリンAIとは、セキュリティとコンプライアンスを担保しながら、重要なデータを動かさずに活用すること」と改めて強調しました。企業が保有する重要なデータを外部に出すことなく、セキュリティとコンプライアンスを担保しながら活用するためには、すべてをクラウドに依存するのではなく、オンプレミスとクラウドを適切に使い分けることが最適解となります。

その上で、AIインフラの構築の第一歩は、まず「AIで何をしたいのか」というユースケースと、扱う「データサイズ」を見極めることです。

機材選定のフェーズでは、電力・冷却といった物理的な制約に加え、オンプレミスサーバー自体の管理性やセキュリティも重要な評価ポイントとなります。データサイズとユースケースを見極め、現実的なオンプレミスとクラウドのハイブリッド構成を検討する必要があるでしょう。

デル・テクノロジーズでは、AI活用に必要な検証済みの幅広いソリューションに加え、国内体制による手厚いサポート、そして強固なサプライチェーンを提供しています。AIデータセンター構築の課題解決に向けて、まずはデル・テクノロジーズへ相談することで、解決への糸口が見つかるはずです。

業務の課題解決に繋がる最新DX・情報をお届けいたします。

メールマガジンの配信をご希望の方は、下記フォームよりご登録ください。登録無料です。

AI製品・ソリューションの掲載を

希望される企業様はこちら