生成AI

最終更新日:2024/08/20

データ収集の方法を解説!

データ収集の方法を解説!

本記事を読むことで、データ収集の重要性や具体的な方法、収集時のコツや注意点について理解が深まります。効果的なデータ活用を実践するためには、まずデータをいかに収集するかが肝心です。

ビッグデータ時代の現在、データに基づく意思決定は企業の生命線とも言えます。データ収集の基本を押さえて、業務に活かしていきましょう。

データ収集とは、特定の目的のために必要なデータを集めることを指します。インターネットの普及によって大量のデータが生成・蓄積されるようになり、近年ではデータ収集の重要性が非常に高まっています。

企業活動において、データは経営判断を下すための重要な材料となります。例えば、マーケティング領域では、顧客データを収集・分析することで、ターゲットの行動や嗜好を把握し、効果的なプロモーション施策の立案に役立てられます。データに基づく意思決定を「データドリブン」と言い、現在ではほとんどの企業がこの考え方を取り入れています。

ただし、データを集めれば良いというわけではありません。目的に応じて本当に必要なデータを見極め、適切な方法で収集することが重要です。次章以降で、データ収集の目的やポイントについて詳しく見ていきます。

データ収集は、主に以下のような目的を持って行われるものです。

データ収集を行う1つ目の目的は、ビジネス上の課題がどのような状況にあるかを正確に把握することです。売上の増減や顧客の推移、商品の在庫状況など、経営状態を表すデータをもとに現状分析を行います。

データで現状を可視化することで、例えば「売上が低迷している原因は新商品の不振にある」といった課題が浮き彫りになります。このように、データ収集と分析を通じて、現状をより深く理解することができるのです。

曖昧な思い込みではなく、客観的なデータに基づいて現状を把握することが、打つべき対策を明確化し、、経営効率を高めることにつながります。

データ収集の2つ目の目的は、ビジネス課題の解決に向けた仮説を立案することです。前述の通り、データ分析によって経営上の課題の問題を発見できたら、次はその原因を探る必要があります。

例えば、「新商品が売れない原因は、品質の問題によるリピート率の低さではないか」といった仮説を立てます。この際、品質管理のデータや顧客の評判、他社製品との比較データなど、仮説の裏付けとなるデータを収集することが重要です。

このように、データを収集・分析しながら、課題解決のための「推測」を重ねることを仮説立案と言います。仮説を立てることで、「どのデータを集めればよいか」「どう分析すればよいか」などの指針を立てられます。

データ収集の3つ目の目的は、立てた仮説を実際のデータで検証することです。先の例で言えば、「品質の改善によってリピート率が上がり、売り上げも回復する」といった仮説の正しさを確かめる作業になります。

ここで収集するべきデータは、品質管理の指標や施策前後の売上高、顧客アンケートの結果などです。仮説検証は、PDCAサイクルで言うCheckの結果になります。Checkの結果、仮説通りの成果が出ていれば、分析と対策を練り直す必要があります。

いずれにしろ、仮説検証のプロセスを経ることで、目の前の課題の本質が見えてくるはずです。絶え間ない仮説検証の積み重ねが、課題解決のスピードを加速させ、ビジネスの成功を導きます。

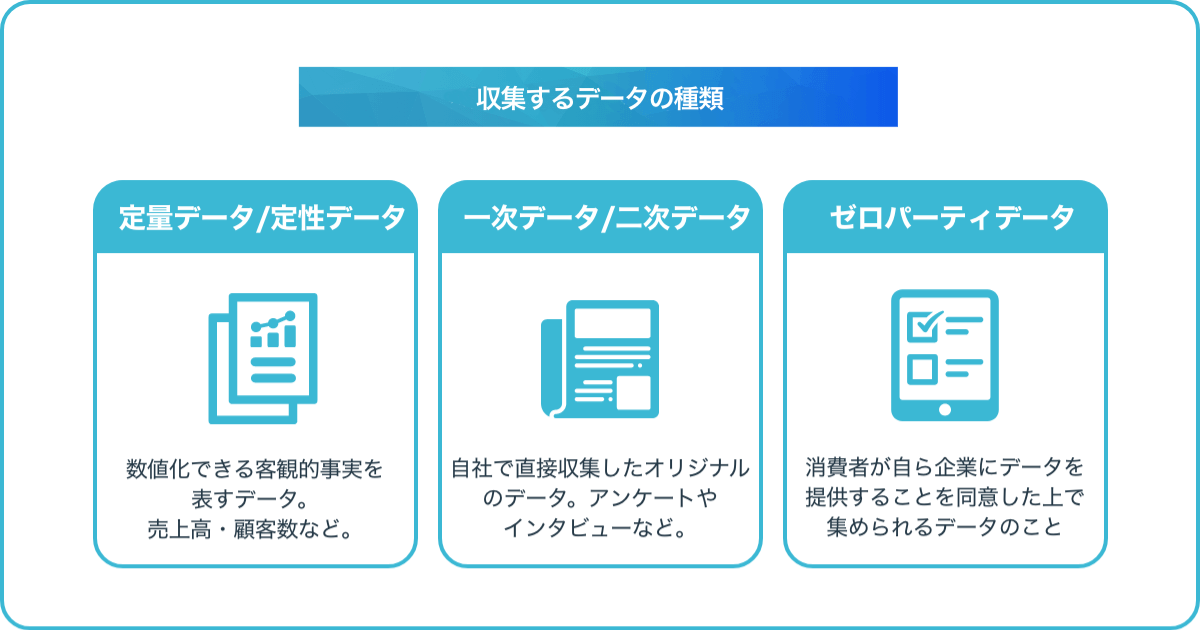

データの収集方法を理解する前に、まずは収集するべきデータの種類について整理しましょう。集めるデータは、主に以下のような分類で区別されます。

定量データは、数値化できる客観的事実を表すデータで、売上高・顧客数・在庫数・Webページの閲覧数など、数字で示せるものが該当します。定性データは、数値化しにくい主観的な内容を表すデータで、顧客の声・従業員の感想・商品レビューなどが含まれます。

定量データの特徴は、比較や分析がしやすいことです。数字であるため、他のデータとの関連性を探ったり、時系列の変化を追ったりと、統計的な扱いに適しています。一方、定性データは、なぜそのような数字になっているのかという理由や背景を知るために有効です。

つまり、定量と定性、双方のデータを組み合わせることで、より立体的にな分析が可能になります。偏りのない意思決定を行うためには、両面からのアプローチが欠かせません。

| 定量データ | 定性データ | |

| 意味 | 数値で表現できるデータのこと。統計的な 処理や分析が可能であり、客観的な比較や傾向の把握に適している。 | 言葉や文章、画像、音声など、数値化が難しいデータのこと。対象者の心理や意図、背景などの深い理解に適している。 |

| 具体例 | ・年齢、身長、体重

・収入、売上、アクセス数 ・満足度の評価点数 ・購入商品の数量、金額 ・ウェブサイトの滞在時間 |

・インタビューの回答

・自由記述アンケート ・SNSの投稿内容 ・行動観察記録 ・グループディスカッションの発言 |

| 利点 | ・統計的な分析が可能

・データの収集や処理が比較的容易 ・客観性が高く、比較や傾向の把握がしやすい ・大規模なデータ収集に適している ・一般化や法則化が可能 |

・対象者の心情や意図、背景などの深い理解が可能

・予期せぬ発見や新たな仮説の発見につながる ・文脈に沿った解釈ができる ・個別具体的なケースの理解に適している ・自由な表現から多様な意見を収集できる |

| 欠点 | ・数値だけでは対象者の心情や背景がわからない

・設問の設計によって結果が左右される ・平均値や割合では個別の事情が見えにくい ・定型的な回答が多くなりがち ・質的な違いを捉えにくい |

・収集や分析に手間と時間がかかる

・データの定義や解釈が難しい ・分析者の主観が入る余地がある ・一般化や法則化が難しい ・定量的な比較や傾向の把握が難しい |

一次データ(プライマリーデータ)は、自社で直接収集したオリジナルのデータを指します。アンケートやインタビュー、実験など、目的に応じて独自に集めるデータがこれに当たります。

二次データ(セカンダリーデータ)は、他社や外部機関が公開している既存のデータで、政府統計や業界レポート、企業の公表データなどが該当します。一次データと比べて、入手が容易で費用がからないのが特徴です。

一次データの強みは、自社の課題に即したデータが得られることです。反面、収集に手間とコストがかかります。二次データは汎用性が高い分、自社の意思決定に必要十分とは限りません。したがって、一次と二次、双方のデータを状況に合わせて使い分けることが望ましいです。まずは二次データを入手し、不足分を一次データで補うといった具合です。

| 一次データ(プライマリーデータ) | 二次データ(セカンダリデータ) | |

| 意味 | 自分で直接収集したオリジナルのデータのこと。特定の目的や調査に合わせて、必要な情報を自ら集める。 | 他者によって収集され、すでに公開されているデータのこと。政府機関の統計、企業の報告書、学術論文など、様々な形で存在する。 |

| 具体例 | ・自社で実施したアンケート調査の結果

・自社サイトの利用履歴データ ・自社店舗での購買データ ・自社商品のモニター調査の結果 ・自社で行ったグループインタビューの記録 |

・総務省の人口推計

・経済産業省の商業動態統計 ・国税庁の民間給与実態統計調査 ・日本銀行の企業短期経済観測調査 ・他社の市場調査レポート |

| 特徴 | ・目的に合わせて必要な情報を収集できる

・データの鮮度が高く、最新の状況を反映している ・競合他社が持っていない独自のデータが得られる ・収集にコストと時間がかかる ・サンプル数が限られることが多い |

・安価に大量のデータを入手できる

・収集に時間がかからない ・専門機関による信頼性の高いデータが多い ・目的に合わない、古いデータが混在することもある ・競合他社も同じデータを利用できる |

ゼロパーティデータとは、消費者が自ら企業にデータを提供することを同意した上で集められるデータのことです。例えば、メールマガジンの登録時に氏名や生年月日、興味関心を任意入力してもらうデータがこれに当たります。また、eコマースサイトで商品購入する際、購入理由や用途をアンケート形式で尋ねるのもゼローパーティデータ収集の一環と言えます。

ゼロパーティデータの最大の特徴は、消費者との信頼関係があってこそ成立するという点です。単にデータを取得するだけでなく、その見返りとして、消費者にメリットを提供する必要があります。

そのメリットとは、パーソナライズされたサービスの提供であったり、会員限定の特典だったりします。いずれにしろ、企業と顧客の”Win-Win”の関係性があって、初めて高品質のデータ収集が実現します。昨今のCookieに対する規制強化の流れを受け、ゼロパーティデータの重要性は今後ますます高まることが予想されます。自社でもゼロパーティデータにどう取り組むべきか、検討が必要な時期と言えます。

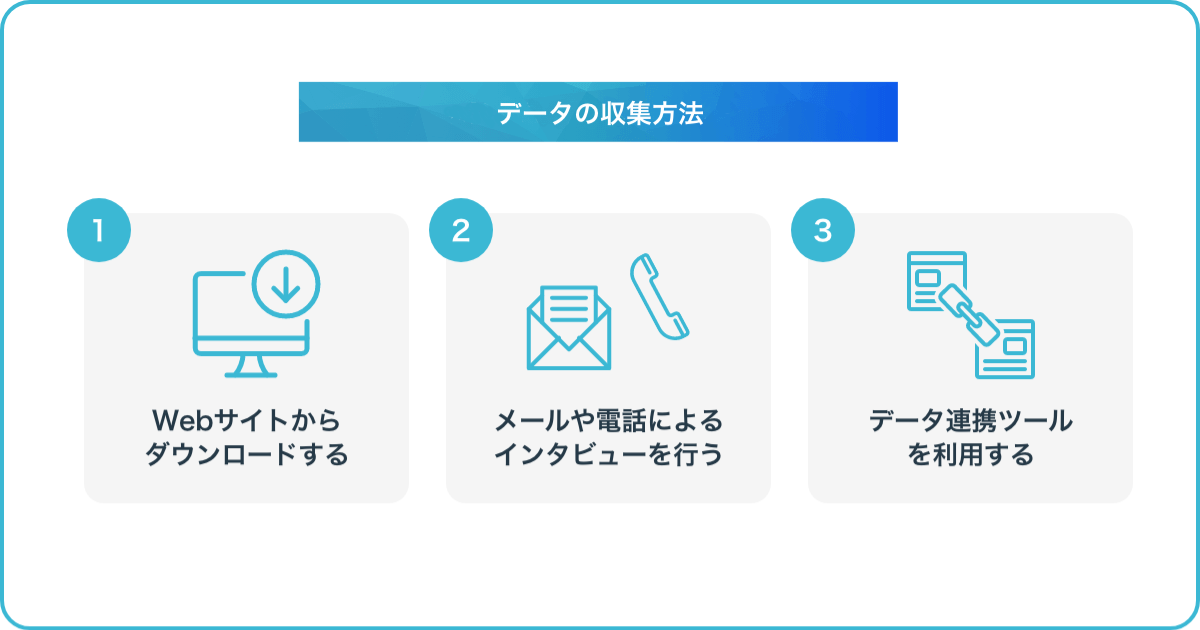

データ収集の具体的な方法について見ていきましょう。基本的な流れとして、まず収集の目的を明確にし、それに適したデータの種類を選択します。次に、データソースを特定し、適切な収集方法を実行する、という流れになります。データ収集でよく使われる代表的な方法として、以下のようなものがあります。

企業や政府機関が公表しているデータを、Webサイトからダウンロードして入手する方法です。例えば、総務省統計局のe-Statでは、国勢調査や経済センサス、家計調査など、様々な統計データを入手できます。また、データカタログサイトDATA.GO.JPでは、政府のオープンデータが分野別に公開されています。

海外に目を向ければ、Data.gov(アメリカ)、EU Open Data Portal(EU)など、政府系のデータカタログが充実しています。企業のサイトでは、Google Trends(検索トレンド)、Facebook IQ(民間企業向けデータ)など、マーケターに有益なデータが無料で提供されているケースもあります。

これらのサイトでは、CSV、Excel、JSON形式など、分析しやすい形式でデータをダウンロードできるのが特徴です。情報の信頼性が高く、手軽に入手できるのが大きなメリットです。ただし、二次データであるが故に、自社の課題解決に必要十分とは限りません。あくまで社内データの補完として活用するのが賢明です。

ウェブAPIとは、あるウェブサービスの機能や所有するデータに、外部のアプリケーションからアクセスするための仕組みのことです。例えば、Twitter APIを使えば、ツイートデータを取得して、分析に活用できます。Youtube Data APIでは、動画の再生回数やコメントなどのデータを収集可能です。

多くの企業が、自社サービスのAPIを公開しています。それらを活用することで、サービス同士を連携させ、ユニークなデータ収集と分析が実現します。APIを使ったデータ収集最大のメリットは、情報を自動的に収集し、常に最新のデータを入手し続けられることです。プログラミングの知識さえあれば、ほぼリアルタイムでデータを収集できます。

反面、実装に専門的なスキルが必要なことがネックになります。外部委託などでエンジニアリングリソースを確保しなければ、社内での利用は難しいかもしれません。また、APIを用いる際は、データの利用規約をよく確認しましょう。無秩序な収集は規約違反に問われる恐れがあります。取得したデータの扱いにも注意が必要です。

スクレイピングとは、ウェブサイトから任意のデータを抽出する技術です。サイトの運営者が明示的に提供していないデータも、スクレイピングを使って収集することができます。手法としては、Pythonなどのプログラミング言語を使って、HTMLソースコードからデータを抜き出すのが一般的です。市販のスクレイピングツールを使う、ブラウザの拡張機能を使うなど色々な方法があります。

スクレイピングの特徴は、他の方法では入手困難なデータも収集できることです。例えば、競合他社の価格データや顧客のレビューデータ、ソーシャルメディア上の口コミなども収集可能です。

Cookieを発行することは、ウェブサイト上でのユーザーの行動を追跡し、データを収集する代表的な方法の一つです。Cookieとは、ウェブサイトがユーザーのブラウザに送信する小さなテキストファイルのことを指します。Cookieには、ユーザーIDや閲覧履歴、設定情報などが記録されます。

具体的には、ユーザーがウェブサイトにアクセスすると、サーバーからCookieが発行されます。Cookieには一意のIDが割り当てられ、ユーザーのブラウザに保存されます。

次回以降、ユーザーが同じウェブサイトを訪問するすると、ブラウザはCookieをサーバーに送信します。これにより、サーバーはユーザーを識別し、過去の行動履歴などと紐付けてデータを収集できるのです。

Cookieを用いたデータ収集のメリットは、ユーザーの行動を継続的に追跡できる点です。例えば、ユーザーがどのページを閲覧したか、どの商品に興味を示したか、どのくらいの頻度でサイトを訪れているかなどを知ることができます。これらの情報は、サイトの改善やマーケティング施策の立案に役立ちます。

複数のクラウドサービスやアプリケーション間でデータをやり取りできるのが、データ連携ツールです。社内の各所に点在するデータを一元化し、積極的に活用できます。例えば、SalesforceなどのCRMツールとGoogle Analyticsを連携させれば、顧客データとWebサイトのアクセスデータを組み合わせた分析が可能になります。

マーケティングオートメーションツールの「Pardot」、データ連携プラットフォームの「Zapler」など、様々なツールが存在しています。データ連携ツールの魅力は、プログラミングなどの専門的なスキルがなくても、データの収集や活用ができることです。直感的な操作性で、誰でも簡単にデータをやり取りできます。

ただし、外部サービスを利用する関係上、データをうクラウド上に預けざるを得ません。機密情報の取り扱いについては、慎重に検討する必要があります。

IoT(Internet of Things)とは、センサーやデバイスがインターネットに接続され、データをやり取りする仕組みを目指します。例えば、ウェアラブルデバイスを使えば、ユーザーの心拍数や歩数、睡眠時間といったデータを収集できます。工場に設置したセンサーからは、製造ラインの稼働状況や在庫の推移がリアルタイムにモニタリング可能です。

IoTの特徴は、今まで人の手を介さなければ取れなかったデータを、自動的かつ高頻度に収集できる点です。

データ活用の幅が大きく広がる反面、デバイスの導入・運用コストや、セキュリティ対策に余念がないことが求められます。IoTならではの課題にも目を配る必要があリます。

データ収集の王道とも言えるのが、インタビューやアンケートによる方法です。その特徴は、収集するデータの設計を自由に行えることです。質問の対応や尋ね方を工夫することで、自社の課題に即した生の声を集められます。

インタビュー形式の場合、回答者の反応を見ながら柔軟に対応できるのも利点です。また、アンケート形式は、大規模調査に向いているという利点があります。一方で、母集団の代表性の問題や回答バイアスの影響は避けられません。データの解釈には注意を要します。

加えて、インタビューは一件あたりのコストが高くつき、アンケートも設計と実施に手間がかかります。費用対効果を勘案しつつ、最適な方法を選ぶことが肝要と言えます。

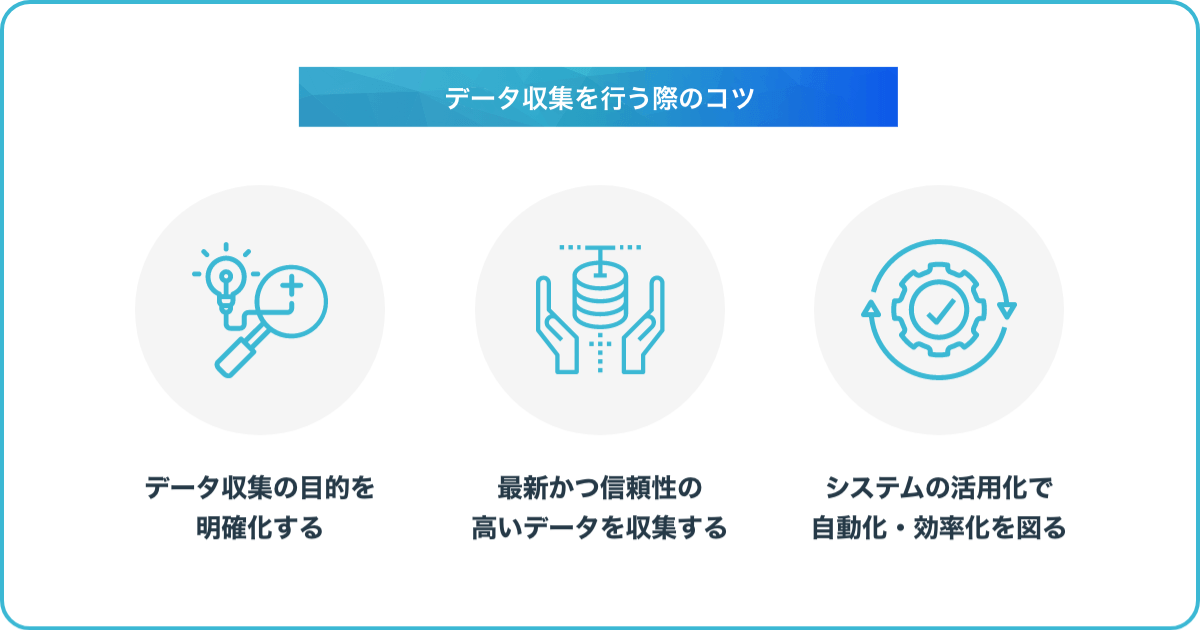

ここまで見てきたように、データ収集には様々な手法があり、それぞれに特徴があります。ここからは、データ収集を効果的に行うための重要なポイントとして、以下の3つをご紹介します。

データ収集の成否を分けるのが、目的を適切に設定できるかどうかです。漫然とデータを集めても、課題解決に役立つ情報は得られません。集める前にまず立ち止まって、今回のデータ収集が何を目指すのかをはっきりさせましょう。

その際のポイントは、「このデータを取得したら、具体的にどのような分析や施策を行うのか」を明文化することです。例えば、「購買履歴データから優良顧客を抽出し、追加販売を促すダイレクトメールを送る」などの形で、データ活用のシナリオまで落とし込みます。

こうしておけば、本当に必要なデータだけを過不足なく収集できます。また、データ収集後のアクションまでスムーズに移れます。

粗悪なデータを大量に集めても、正しい意思決定にはつながりません。データ収集では、情報の鮮度と信頼性が何よりも重要なのです。そのためには、情報ソースの選定が欠かせません。データの出所が明らかで、定期的に更新されているものを選ぶようにしましょう。

また、可能な限り一次情報を集めることも重要です。伝達情報やうわさ話は、とりこぼしが多いだけでなく、事実と異なることも少なくありません。一次情報の収集が難しい場合は、複数の情報筋から同じ事実が確認できるデータを優先的に扱うのも一つの手です。

いずれにしろ、集めたデータの中身をよく吟味し、最新かつ確度の高いものだけを選り分ける作業が不可欠です。

データ収集は地道な作業になりがちですが、前述のようなシステムやツールを活用することで、大幅な効率化ができます。定型的なデータ収集は、できる限り自動化するのが賢明です。例えば、APIでデータを定期的に取り込むなどの方法があります。

非定型データの収集も、スクレイピングやデータ連携ツールを使えば、手作業を大幅に減らせるはずです。

単調な繰り返し作業から解放されることで、より付加価値の高い分析業務に専念できます。結果的に、人件費の削減とデータ活用の高度化を同時に実現できます。また、ツールの導入に際しては、ユーザビリティやアフターサポートもチェックしましょう。使いにくいツールでは、現場に定着せず、宝の持ち腐れになってしまいます。

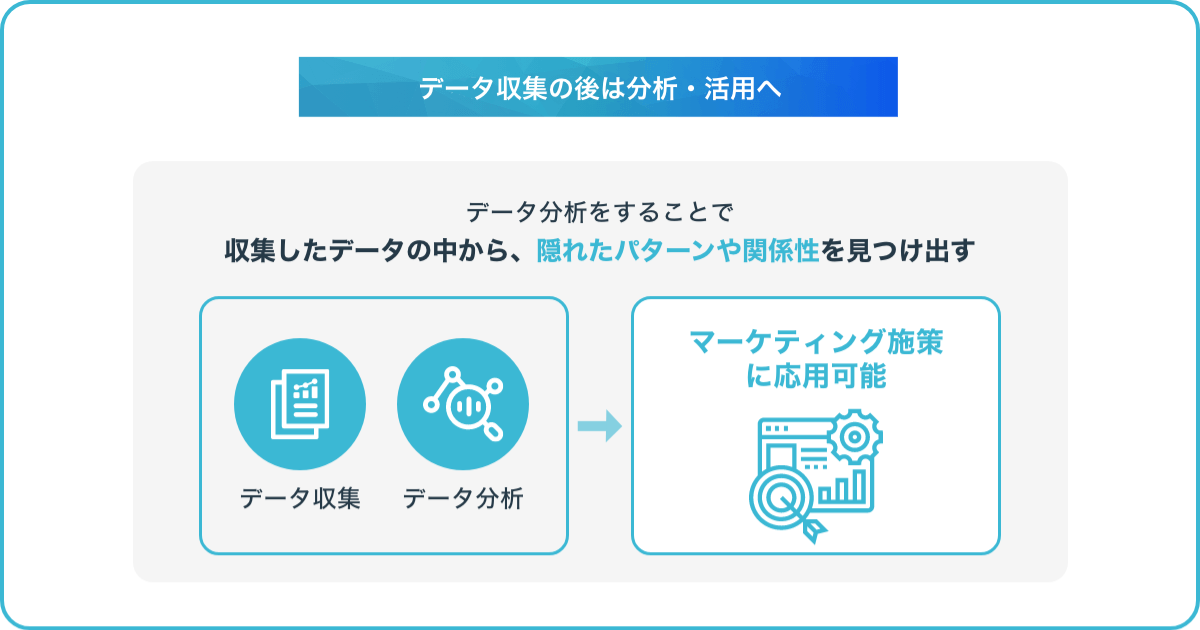

収集データは、そのまま寝かせておいては何の意味もありません。蓄積したデータを活用・分析して、はじめて意思決定に役立てることができます。データ分析とは、収集したデータの中から、隠れたパターンや関係性を見つけ出す作業を指します。

例えば、「商品Aを購入した人は、商品Bも購入する傾向がある」といった具合に、データの相関関係を導き出すのがデータ分析です。一方、データ活用とは、分析で得られた知見をビジネスの意思決定に用いることを指します。分析結果を元に、「商品AとBの販売を連動させるキャンペーンを打つ」などのマーケティング施策に落とし込むイメージです。

つまり、データ分析と活用は、データ収集の次に来るべきフェーズということになります。データ収集だけに注力して分析がおろそかになっては、本末転倒と言わざるを得ません。データ分析の手法については、下記の関連記事で詳しく解説しています。

関連記事:データ分析とは?基礎から分かる手法と流れ、仕事でのメリットも解説

データ収集とは、現状の把握、仮説の立案・検証などを目的として、必要なデータを集める行為を指します。収集するデータには、定量データと定性データ、一次データと二次データ、ゼロパーティデータなどの種類があります。

データの収集方法は多岐にわたり、Webサイトからのダウンロード・ウェブAPIの利用・スクレイピング・Cookieの発行・データ連携ツールの利用・IoT機器の活用・メールや電話でのインタビューなどがあります。データ収集を行う際のコツとしては、明確を目的化すること、最新かつ信頼性の高いデータを収集すること、システムの活用で自動化・効率化を図ることなどが挙げられます。

収集したデータは、そのままでは価値が限定的であるため、分析・活用することで初めて意味を持ちます。データ収集は、データ活用の第一歩であり、収集したデータを適切に分析・活用することで、ビジネスの意思決定や問題解決に役立てることができます。

業務の課題解決に繋がる最新DX・情報をお届けいたします。

メールマガジンの配信をご希望の方は、下記フォームよりご登録ください。登録無料です。

AI製品・ソリューションの掲載を

希望される企業様はこちら