生成AI

最終更新日:2024/04/10

Databricks オープンなLLM DBRX公開

Databricks オープンなLLM DBRX公開

Databricksは、汎用LLM「DBRX」を公開しました。オープンソースでありながら最高水準の性能を誇ります。

このAIニュースのポイント

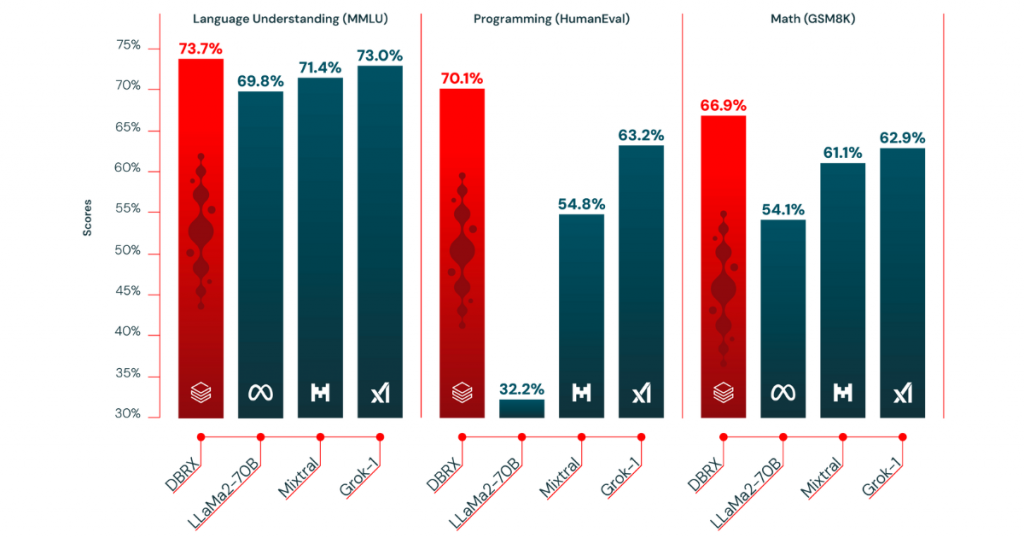

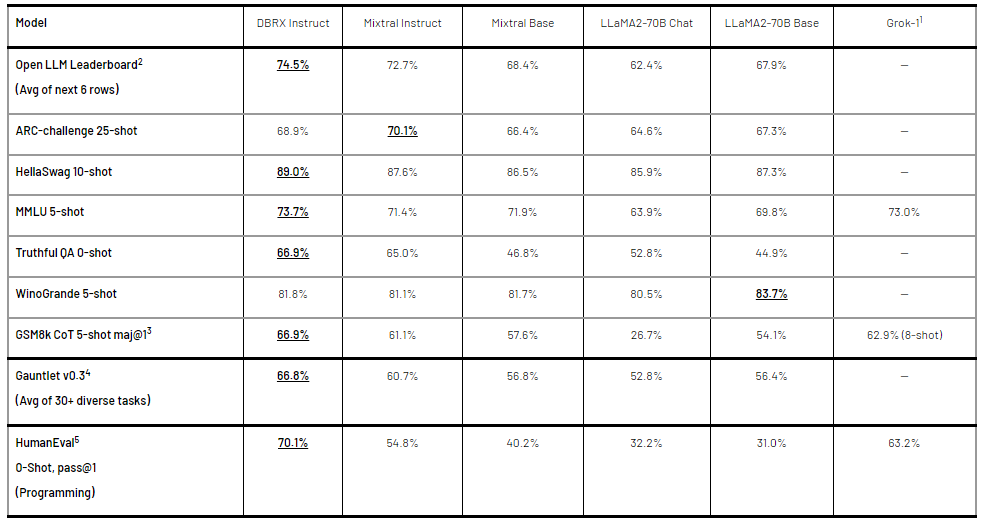

米AI企業のDatabricksは3月27日、同社が開発した最新のオープンソースの言語モデル、「DBRX」のリリースを発表しました。「DBRX」は、標準ベンチマークにおいて最先端の性能を誇り、これまでクローズドなAPIに限られていた機能がオープンに提供され、プログラミングにおいても優れたコードモデルとして活躍します。

「DBRX」は、ネクストトークン予測を使用してトレーニングされた、Transformerベースのデコーダー専用のLLMです。GPT-3.5を上回り、Gemini 1.0 Proと競合する性能を持ちます。合計1320億パラメータを備えた専門家混合(MoE)アーキテクチャを採用しており、トレーニングと推論パフォーマンスを大幅に向上させるとともに、前世代モデルと同等の品質をほぼ四分の一の計算量で実現します。

「DBRX」は、オープンソースプロジェクトMegaBlocksに基づいて構築されたMoEを採用しており、16人のエキスパートによる独自のトレーニングスタックを使用しています。これにより、推論スループットは非MoEモデルより2~3倍高くなり、MetaのLLM「LLaMA2-70B」よりも最大2倍高速に推論を行います。また、テキスト生成はユーザーあたり最大150トークン/秒を実現します。

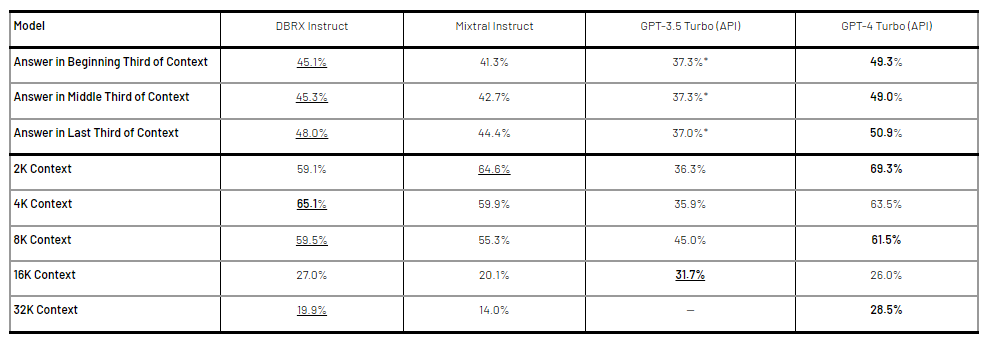

「DBRX」の構築には3072基のGPU「NVIDIA H100」が使用され、3カ月にわたってトレーニングが行われました。さらに、品質とセキュリティの向上のために人間のフィードバックを収集し、手動でのモデル実験も行われました。トレーニングには12Tトークンのデータが使用され、32kトークンの最大コンテキスト長を備えています。こられにより、ほぼすべてのベンチマークにおいてあらゆるLLMのスコアを上回る結果となりました。

DatabricksはDRBXが自社のAI製品の中核であるとし、企業などがこの機能を活用して自社データをコントロールすることに期待しています。また、「DBRX」での取り組みは始まりにすぎず、今後もさらなる成長に取り組んでいくとコメントしています。

出典:Databricks

業務の課題解決に繋がる最新DX・情報をお届けいたします。

メールマガジンの配信をご希望の方は、下記フォームよりご登録ください。登録無料です。

AI製品・ソリューションの掲載を

希望される企業様はこちら