生成AI

最終更新日:2024/06/24

音声認識について解説

音声認識について解説

SiriやGoogle音声アシスタントといった音声アシスタントアプリケーションは、もはや当たり前の存在となりつつある状況です。実際にこれらの音声アシスタントアプリケーションを利用して、情報を検索している方も多いのではないでしょうか。

そんな音声アシスタントアプリケーションが高い精度で私たちの声を聞き取り、適切な回答ができるのは、音声認識にAIが活用されているからです。

本記事では、AIがどのような仕組みで音声認識を行っているのか、詳しくご紹介します。

音声認識について詳しく知りたい方は以下の記事もご覧ください。

音声認識とは?AIを使った仕組みや特徴をわかりやすく解説!無料製品や事例も紹介!

音声認識システムとは、人間が発した言葉や声や会話をAIが解析し、テキストデータへ変換して出力するシステムです。音声認識システムの登場により、これまで音声のテキスト化に要していた工数や時間が圧縮され、あらゆる業態における業務効率化が期待されています。

音声認識と聞くと、SiriやGoogle音声アシスタントを想像する方もいるかもしれません。SiriやGoogle音声アシスタントは、厳密には「音声アシストアプリ」という表現が適切です。

SiriやGoogle音声アシスタントにおける音声認識は、あくまでもそのアプリケーションの技術の一部に過ぎません。音声を認識し、テキストとして表示する部分が音声認識システムであり、音声アシスタントアプリを構成する技術のひとつなのです。

音声認識について本格的な研究が開始されたのは、1971年のアメリカだとされています。軍事関連の研究を行っているアメリカ政府の機関「国防高等研究計画局」が音声認識についての研究に着手したことで、少しずつ技術が発展していきました。

そして、1975年には、ITサービスの大手企業であるIBMが、民間では世界初となる音声認識技術を開発して注目を集めますした。その後、Microsoftが「Windows 95」にスピーチツールを搭載したことでさらに話題を呼び、2011年にはiPhone 4SにSiriが搭載されたことで、私たちにとって非常に身近な存在へとなっていったのです。

現代における音声認識システムは、大きく「DNN-HMM型」「End-to-End型」の2種類に分類されます。

DNN-HMM型は、音声の解析にはじめてAIを導入した音響モデルです。1990年代までは個々の音声データの時系列を解析し蓄積したモデル(音響モデル)から、どのような時系列データを生成されやすいのか確率を導き出す「GMM-HMM」が主流でした。その後、2010年代にAI技術の発展によるアルゴリズムの改善やハードウェアの発展を受け、音響モデルにAIを導入し音声認識の精度を高めた「DNN-HMM型」が主流となったのです。

2016年以降は、さらにAIを用いた音声認識技術が発展。新たに「End-to-End型」が誕生しました。DNN-HMM型までで用いられていたHMM(隠れマルコフモデル)による確率定義を省略し、蓄積された音声データから直接文字列を推測する「End-to-End型」が台頭し始めています。

2022年現在、研究分野ではすでにEnd-to-End型が主流となりつつありますが、一方でプロダクトにおいてはDNN-HMM型が多く用いられています。そのため、本記事でも、現状一般的に用いられやすいDNN-HMM型を念頭に解説します。

音響分析とは、マイクに入力された音声を分析し、コンピューターが扱えるデータに変換する作業のことです。AIは、人間と同じように生の録音データから音声を認識することはできません。そのため、AIが認識できるようにデジタル化し、ノイズの除去まで行う必要があるわけです。

そして、AIは音響分析によって抽出されたデータをもとに音声認識を進めていきます。

音響モデルとは、データ化された音声を過去に蓄積した学習データと照らし合せ、音の区切り(音素)を抽出する作業えです。音素は「音声を発した際に観測される音波の最小構成要素」であり、日本語であれば母音(アイウエオ)、擬音(ン)、子音(23種類)の3つから成り立っています。

例えば、「こんばんは」から音素を抽出すると「k-o-N-b-a-N-w-a」に分解されます。ただし、音響モデルではあくまで音素への分解が行われるだけですので、適切なテキストへの出力はこの後に説明する言語モデルが必要です。

一般的に、学習データでは数千人、数千時間の人間の声を統計的に処理したデータが用いられます。そして、音素を抽出することによって、初めてAIが音声をテキスト化する上で必要な情報が得られるのです。

言語モデルとは、単語群を文章化していくための作業のことです。例えば、「こんにちは。今日は寒いですね。」という文章は、もともと「こんにちは」「今日は」「寒いですね」といった単語群で成り立っています。

このような単語群を文章化する際には、日本語テキストを多く収集して統計処理したデータをもとに、可能性の高い組み合わせ例を参考にしながら意味のある正確な文章として整形していくわけです。

音響モデルと言語モデルを繋ぐ役割を担っているのが、発音辞書です。音響モデルによって抽出された音素の並びを組み合わせて、単語として構成していく際における「データベース」の役割を担っています。

例えば、「今日はいい天気ですね」という言葉を音素へ分析すると「ky-o-u-w-a-i-i-t-e-N-k-i-d-e-s-u-n-e」となります。これらの音素を発言辞書に照らし合せて連結することで「今日は」「いい」「天気」「ですね」という単語に変換され、「今日はいい天気ですね」というテキストが出力されます。

発音辞書を利用した音素の連結によって初めて、単語に相当する単語音響モデルを構築できるのです。

言語モデルの手法として、主に「隠れマルコフモデル」「N-gram」の2種類が用いられています。

隠れマルコフモデルは、特定の単語の後にくる次の単語を確率で推定するための手法で、推定する単語は、分析した膨大な量の日本語データから導き出されます。

例えば、「私は」の後に続く言葉の確率が「楽しい(60%)」「苦しい(20%)」、「楽しい」に続く言葉が「です(70%)」「が(20%)」「よ(10%)」というように、現在の状態から次の状態に遷移する方法を定義します。

一度遷移した先から戻らないモデル(Left-to-Right HMM)と戻れるモデル(Ergodic-HMM)があり、言語モデルではErgodic-HMM が用いられることが少なくありません。

N-gramは、連続する単語や文字のまとまりを用いる手法です。「今日はいい天気です」をn=3(3-gram)の単語で区切る場合、次の3つの3-gramが含まれていると考えられます。

また、n=5の文字で区切る場合には、以下の5-gramが存在します。

このように、n-gramは文字や単語を単位とした繋がりから文字列を推測します。

音響分析、音響モデル、言語モデルの過程を経て、最終的に自然な文章と判断された結果がテキストとして出力されます。

ただし、出力結果は必ずしも希望の状態になるとは限りません。期待した通りの結果にならなかった場合は、さらなる学習や各工程の調整を行い、テキスト出力の精度を高める必要があります。

近年、音声認識システムに用いられている手法が「End-to-End型」。End-to-End型は、従来の音声認識システムに比べシンプルな構造で音声のテキスト化が可能です。

現在主流となっているDNN-HMM型は、すでに解説したように以下の流れで音声のテキスト化を行います。

このように複数のモジュールを組み合わせて音声をテキスト化していましたが、End-to-End型では音響分析以降をひとつのモジュールで処理を行います。

End-to-End型はシンプルな構造であるため、ネットワークの軽量化が容易である点がメリットです。また、複数のモジュールそれぞれの限界により誤差が生まれやすいDNN-HMM型に比べ、単一モジュールであるため高精度の出力を生むという特長もあります。

そんな中、最近ではディープラーニング(深層学習)を行うAIと音声認識を組み合わせることで、さらに精度を高められるようになりました。また、より多様な場面で活用することもできるようになっています。例をいくつか見ていきましょう。

従来、パソコンを操作して何かしらの命令を出すためには、マウスやキーボードを直接操作しなければなりませんでした。

マウスだと、ドラッグ&ドロップなどの手間がかかりますし、キーボードに関しては入力の労力がかかるうえ、人によって入力スピードに差が生まれてしまいます。つまり、労力がかかる上にスピードを一定に保つこともできなかったわけです。

その点、AIを利用した音声認識であれば、文字の入力はもちろん、アプリケーションの起動・終了まで音声ひとつで行えるようになります。

また、プログラミング言語「Python(パイソン)」のカンファレンスなどでは、講演者の発音を正しく理解して音声認識したAIがプログラミングコードを入力するといった使い方もされています。

空港や駅のターミナルのような、大声で話す人が周囲にいる環境では、多くの人の声が入り混じる中で正確に声を聞き取り、適切な回答を示すことが難しいのが現実です。

しかし、AIを活用することによって、人間では聞き取るのが難しいような状況下においても正確に音を聞き分けられるようになります。

一例として、通信事業の大手であるNTTが開発した技術が挙げられます。NTTが開発したAIは、ノイズキャンセリングイヤホンのような仕組みでノイズを減らし、必要な音だけを効率的に聞き取ることが可能です。

データ入力、電話対応といった事務作業は、比較的機械的な作業ではあるものの、時間がかかってしまう傾向にあります。また、人の手による作業ではミスが生まれにくい業務でもあるため、「できる限り効率的にミスなく進めたい」と考える方も多いのではないでしょうか。

AIを活用した音声認識であれば、データ入力を自動化させることができるだけなく、その精度も高くすることができるため、企業としての信頼性向上につなげられるでしょう。また、人の手による作業が必要なくなるため、人手不足という問題を抱える企業の「業務効率化」にも大きく貢献します。

近年のAIの発達により、音声認識システムは目覚ましい進歩を遂げ、あらゆる場面で活躍を見せるようになりました。一方で、技術的に発展途上であるため、まだまだ多くの課題やデメリットを抱えています。

一般的な標準語への対応が急速に進む一方、独自の言葉遣いへは対応しきれていないのが現状です。

方言やスラング、業界用語や若者言葉など、「知る人が聞けば理解できるが使用者が多くない」言葉の多くは、サンプルが少ないこともあって正確なテキスト化ができないだけでなく、標準語部分の推測に対するノイズとなり、出力結果に影響を与えるケースが少なくありません。

独自の言葉遣いへ正確に対応していくためには、一定の時間が必要です。今後、音声認識技術の発展と非頻出単語の学習が進むことで、より精度が上がると考えられます。

音声認識システムが抱えるもうひとつの課題が、「発言者の識別」です。現状の音声認識システムの多くは、音響モデルで話者識別を行っておらず、出力されるテキストには話者に関する情報が含まれません。

話者識別は、事前に登録した生体データに基づく解析を行う方式と、音声処理アルゴリズムによって話者を区別する方式に分類されます。前者は限定された状況下でしか利用できないため、一般向けのサービスではなかなか利用できません。後者は技術開発が進んでおり、今後多くのサービスへの導入が期待されています。

そんな中、最近ではディープラーニング(深層学習)を行うAIと音声認識を組み合わせることで、さらに精度を高められるようになりました。また、より多様な場面で活用することも可能になっています。例をいくつか見ていきましょう。

会議の内容を記録する「議事録」は、より正確かつスピーディーに作成していく必要があります。しかし、担当者の知識やスキルによっては作成スピードに差が生まれてしまうケースも珍しくありません。

最近では、AIを活用した音声認識によって自動で議事録を作成できるツールも増えてきました。そういったツールを有効活用することで、より議事録作成を効率化することが可能になるでしょう。

議事録は、以下のようなケースや部署・メンバーにおすすめです。

最近では、AIを活用した音声認識による翻訳機も増えてきました。例えば、翻訳機として高い知名度を誇る「ポケトークW」は、Googleなどの検索エンジンに接続することで、ユーザーが発音した内容を調査できる仕組みです。

そのため、適切な意味を理解して会話を返すことが可能です。さまざまな言語に対応しており、アメリカ英語やイギリス英語、カナダ英語といった細かな言語の違いにも対応できる点は大きな魅力だといえるでしょう。

従来、通訳者を介してコミュニケーションが行われていた場でも、今後はこういった翻訳機で完結できるようになるかもしれません。

このように、AIを活用した音声認識には多くのメリットがあり、すでに多くの業務に活用されている状況です。SiriやGoogle音声アシスタントなど、私たちにとって非常に身近な存在になりつつある音声認識も数多く存在します。こういった音声認識の仕組みは、私たちの生活をより豊かにする可能性を秘めているといえるでしょう。

翻訳機は、以下のようなケースや企業におすすめです。

機械学習やディープラーニングを活用した音声認識によって、会話内容の把握だけでなく、対応そのものを自動化してしまうのが、「対話型AI/ボイスボット」です。人手を介さずに、問い合わせ対応を行えるようになるため、業務の自動化を実現できます。

企業によっては、オペレーターの人手不足が深刻化しているケースもあるでしょう。オペレーターが不足したままの状態では、問い合わせ対応のスピードが遅れてしまうため、顧客満足度の低下にもつながりかねません。

しかし、対話型AI/ボイスボットを活用すれば、ユーザーからの電話にも自然な通話のように自動対応が可能です。AIだけでは対応できない問い合わせのみ、オペレーターに転送する仕組みを構築すれば、「AIでは対応できない問い合わせのみを人間が対応していく」という効率的な業務環境を実現できます。

ただし、導入には一定のコストが必要。初期費用数万、月額はプランにより5~50万円程度とされていますが、10件までは無料、1コールごとの費用設定がある場合など、利用したい件数によっては低額での利用も可能です。

ボイスボット(対話型AI)は、以下のような企業におすすめです。

最近では、入力したテキストを自動で読み上げてくれる「音声合成ソフト」や、リアルタイムで声を変換するボイスチェンジャーなどの活用も広がっており、注目を集めています。音声合成(音声読み上げ)技術に関しては、無料でその技術を体感できるフリーソフトも多く提供されているため、今すぐ活用していくことも可能です。

音声合成ソフトは、もともと目が不自由な人や、小さな文字を読むのが困難な高齢者に向けて開発が進められていました。ホームページやテキストファイルなどの文字を機会が読み上げてくれれば、字を読むことができない人でも理解できるからです。

ただし、最近では上記の目的だけでなく、さまざまな領域で音声合成ソフトが活用され始めています。現在ではコンテンツ作成に利用されるケースが多くなってきていますが、もともとは「目が不自由な人」「文字を読むのが困難な高齢者」を対象に開発が進められたという背景を理解しておくことで、よりユーザー目線を大切にできるでしょう。

実は、官公庁などのホームページではすでに音声合成ソフトが導入されており、テキストを読み上げてもらうことが可能です。今後さまざまなサイトで音声合成ソフトが導入されていく可能性もあります。

音声合成による読み上げは、以下のようなケースや企業、個人におすすめです。

音声認識システムは、AIの発展により安価で使いやすいシステムへと進化を続けています。

従来は人員による対応が必須であったサービスの音声認識システムへの置き換えが進んでおり、毎日の生活におけるさまざまな場面で音声認識システムに触れる機会が増えてきました。

ここでは、企業による音声認識システムの活用事例を紹介します。

近畿広域圏を放送対象とする放送局「株式会社毎日放送」では、朝の30分ラジオ番組をAIで文字起こししたテキストを作成。朝の忙しい時間に生放送を聞けない方向けに、専門家の提言などの貴重な情報をWEBサイト上に公開しています。

少ないスタッフで番組制作から放映まで対応しなければならないため、文字起こしの時間が取れないことが悩みでした。しかし、精度の高いAI文字起こしを活用し始めてからは、作業時間の大幅な短縮に成功したそうです。

モーターなどの構成部品であるベアリングの中核部品「リテーナー」の世界トップシェアを誇る「中西金属工業株式会社」では、アジア圏への商品販売強化を推進。製品説明を現地語で行うため、AI翻訳を導入しました。

文法上の並びを考慮し、すでに設置済みの英語サイトを基に多言語展開を行った結果、自動翻訳の精度が著しく向上。現地の顧客とのコミュニケーションが活性化した上、海外SEO対策強化も同時に可能となったのです。

事例:アジア圏でのコミュニケーション活性化を実現(中西金属工業株式会社)| AISmiley

AI音声認識サービスは数多くリリースされているため、適切なサービスを選ぶことが大切です。自社が抱える課題に対し有効なAI音声認識サービスを選んで、業務の効率化と利益の最大化を目指しましょう。

ここからは、人気のあるおすすめのAI音声認識サービスを紹介します。

「AmiVoice Communication Suite」は、独自の音声認識エンジン「AmiVoice」を導入したコールセンター向けAIソリューションです。

顧客との電話によるコミュニケーションをAIがリアルタイムに文字起こしし、会話中に頻出するキーワードから適切な案内方針を提案。また、独自の感情解析技術により顧客の勘定の起伏を可視化。顧客の感情に寄り添った対応に導きます。

膨大な情報から構築されたAIにより、負荷の高いコールセンターの業務軽減を目指せます。サポートセンターの対応品質の低下や対応品質のばらつきに悩む企業におすすめです。

【こんな課題を抱えている企業におすすめ】

AmiVoice Communication Suiteはこちら

Nuance Japanが提供するさまざまな音声ソリューションを組み合せることで、さまざまな形態の音声認識サービスが実現します。

音声対話に必要な「意図理解」「対話内容の管理」「合成音声による会話」「自動文字起こし」と、事業に特化した独自辞書を組み合わせ、AIによる自然な対話を可能とします。

クラウド型、オンプレミス型のいずれにも対応できるため、企業が求める用途に合ったシステム構築が可能。業界独自の専門用語や、独自のルールに沿った対応が必要な企業におすすめできるAI音声認識ツールです。

【こんな課題を抱えている企業におすすめ】

NTTコミュニケーションズが提供する音声解析サービスが「COTOHA」。翻訳から文字起こし、要約文の作成を自動で行うことが可能です。

また、200万語以上の単語を含む辞書群を保持しており、3,000種を超えるといわれる意味属性の分類により、文脈に合った自然な単語選択を実現します。

顧客側で必要な用語を辞書登録すれば、業界や社内文化にあった翻訳・文字起こし環境の整備が可能。海外を含むオンライン会議にまつわる業務の工数を圧縮したい企業に最適のAI音声認識ツールです。

【こんな課題を抱えている企業におすすめ】

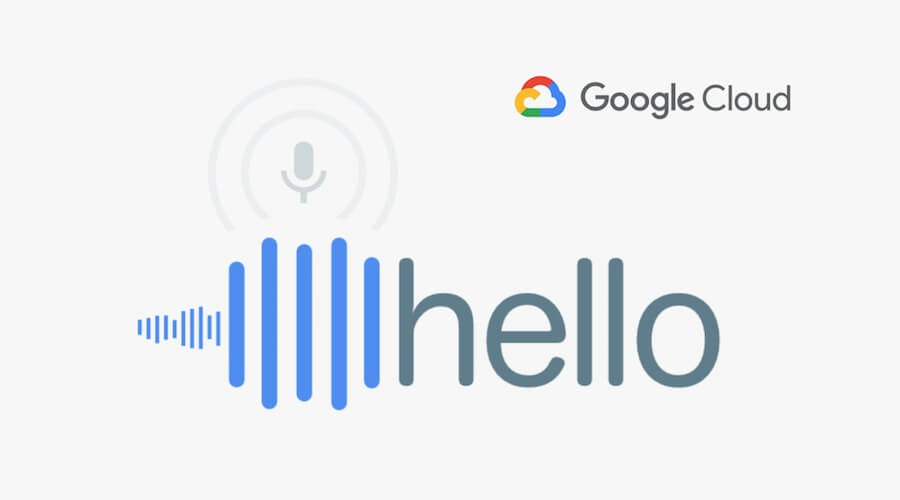

「Speech-to-Text」は、Googleが提供するクラウドベースの音声認識サービスです。膨大な量の音声データを学習し続けるAIにより、高品質の文字起こしを実現します。

電話やビデオ、音声ファイルなど、一般に流通するさまざまな音声フォーマットに対応。ブラウザ上から登録不要で利用できるため、誰もが気軽に文字起こしを活用できるのは大きなメリットです。

完全無料で利用できるため、コスト面の使い勝手は抜群。低コストで精度の高い文字起こしツールを利用したい企業におすすめです。

【こんな課題を抱えている企業におすすめ】

AIを活用した音声認識には多くのメリットがあり、すでに多くの業務に活用されている状況です。SiriやGoogle音声アシスタントなど、私たちにとって非常に身近な存在になりつつある音声認識も数多く存在します。

また、音声認識AIは、2023年度には1,000億円超の市場規模へと成長していくことが予想されています。

こういった背景もあり、ますます活況を呈する音声認識AIは、より豊かな生活、そして企業活動が実現できる可能性を秘めた魅力ある仕組みなのです。

業務の課題解決に繋がる最新DX・情報をお届けいたします。

メールマガジンの配信をご希望の方は、下記フォームよりご登録ください。登録無料です。

AI製品・ソリューションの掲載を

希望される企業様はこちら