生成AI

最終更新日:2025/12/22

日本語マルチモーダル基盤 公開

日本語マルチモーダル基盤 公開

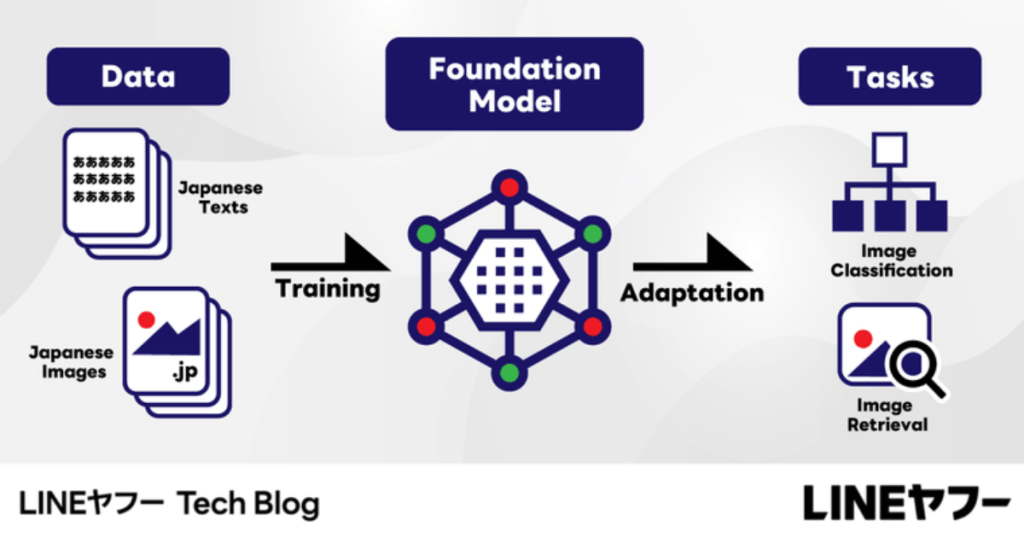

LINEヤフーのFoundation Models研究開発チームは、日本語マルチモーダル基盤モデル「clip-japanese-base-v2」を公開しました。

このニュースのポイント

LINEヤフー株式会社のFoundation Models研究開発チームは、日本語マルチモーダル基盤モデル「clip-japanese-base-v2」を公開しました。

「CLIP」は、画像と言語の代表的なマルチモーダル基盤で、インターネットから収集した大規模データで学習することで、ゼロショットでの分類や検索が可能です。

今回の「clip-japanese-base-v2」は、同チームが以前に公開した「clip-japanese-base」を、学習データと学習方法を改善し、高性能化したモデルです。

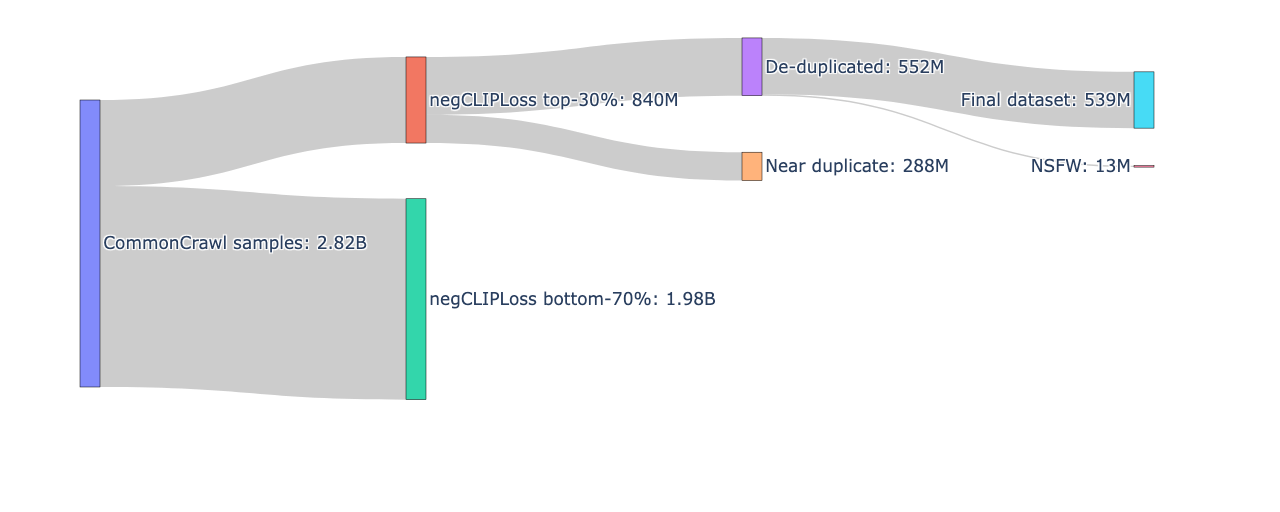

開発にあたって、Common Crawlから収集した日本語の画像・テキストペアデータを主に使用しています。以前のバージョンと比較して、フィルタリング前の画像サンプル数を18億件増加させています。

また、画像とテキストが無関係なデータを除去するため、従来のCLIP-scoreに代わりnegCLIPLossという新しい指標を採用し、最終的には5.4億件の高品質な画像・テキストペアを学習データとして使用しています。

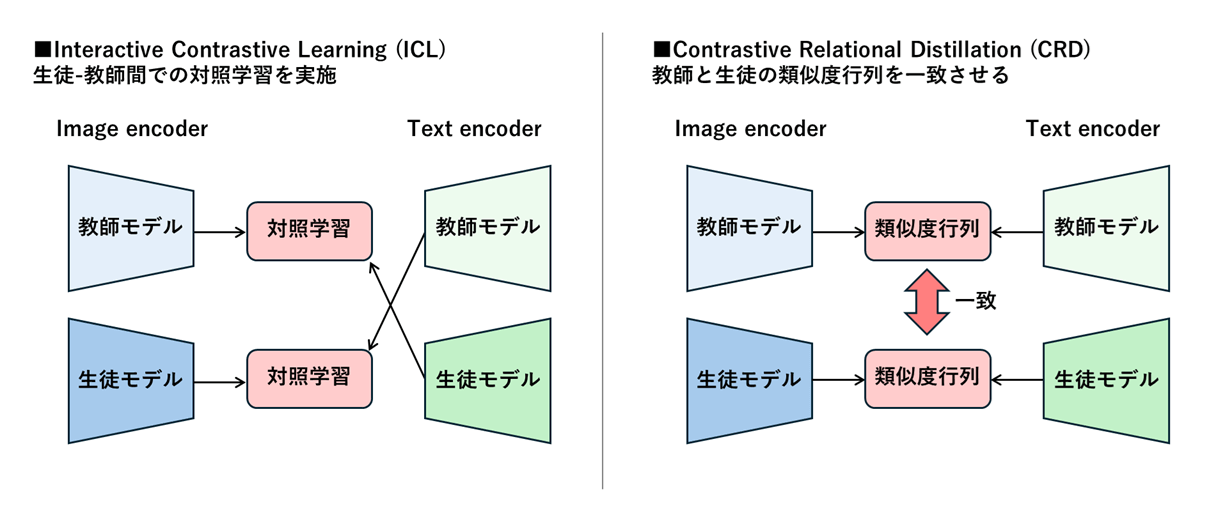

「clip-japanese-base-v2」は、学習データの更新に加え、知識蒸留による高精度化にも取り組んでいます。知識蒸留とは、大規模で高精度なモデル(教師)が持つ知識を、小さく軽量なモデル(生徒)に受け渡し、小さいモデルで高い性能を発揮できるようにする手法です。

先行研究であるCLIP-KDを参考に実験を行った結果、Interactive Contrastive Learning (ICL)と Contrastive Relational Distillation (CRD)の組み合わせが最も有効でした。今回は、CRDに対して独自の改良を加えることで大幅な精度改善に成功しました。

| モデル | パラメータ数 | 平均性能 | ImageNet-1k | Recruit | WAON-Bench | STAIR Captions |

|---|---|---|---|---|---|---|

| clip-japanese-base-v2 (Ours) | 196M | 0.708 | 0.666 | 0.913 | 0.975 | 0.277 |

| clip-japanese-base | 196M | 0.673 | 0.580 | 0.884 | 0.934 | 0.293 |

| waon-siglip2-base-patch16-256 | 375M | 0.664 | 0.555 | 0.872 | 0.951 | 0.276 |

| siglip2-base-patch16-224 | 375M | 0.579 | 0.517 | 0.802 | 0.871 | 0.126 |

| siglip2-so400m-patch14-224 | 1135M | 0.642 | 0.643 | 0.837 | 0.925 | 0.163 |

既存の公開モデルと比較すると、「clip-japanese-base-v2」のモデルパラメータが最も少なく、他の日本語特化やマルチリンガルモデルよりも高い性能を示しています。

LINEヤフーは、「今後も構築したモデルの一部を継続的に公開しますので、今後の展開にもぜひご期待ください」とコメントしています。

出典:LINEヤフー

業務の課題解決に繋がる最新DX・情報をお届けいたします。

メールマガジンの配信をご希望の方は、下記フォームよりご登録ください。登録無料です。

AI製品・ソリューションの掲載を

希望される企業様はこちら