生成AI

最終更新日:2024/09/03

RLHFとは?

RLHFとは?

本記事では、AIモデルの性能向上に重要な役割を果たすRLHF(Reinforcement Learning from Human Feedback)について詳しく解説します。

RLHFの基本概念や仕組み、学習ステップを理解することで、AIモデルの開発や改善に携わる方々にとって、有益な情報をご紹介します。

RLHF(Reinforcement Learning from Human Feedback)は、「人間のフィードバックからの強化学習」を意味する技術です。この手法は、人間の価値基準に沿うように、AIモデル、特に言語モデルを強化学習によって微調整(ファインチューニング)するプロセスを指します。

RLHF(アールエルエイチエフ)は、Reinforcement Learning from Human Feedbackの頭文字を取った略称です。RLHFに該当するものとしては、例えばOpenAIのGPT-3やChatGPTなどの大規模言語モデル(LLM)の学習プロセスが挙げられます。これらのモデルは、人間のフィードバックを活用して、より適切で有用な応答を生成できるように調整されています。

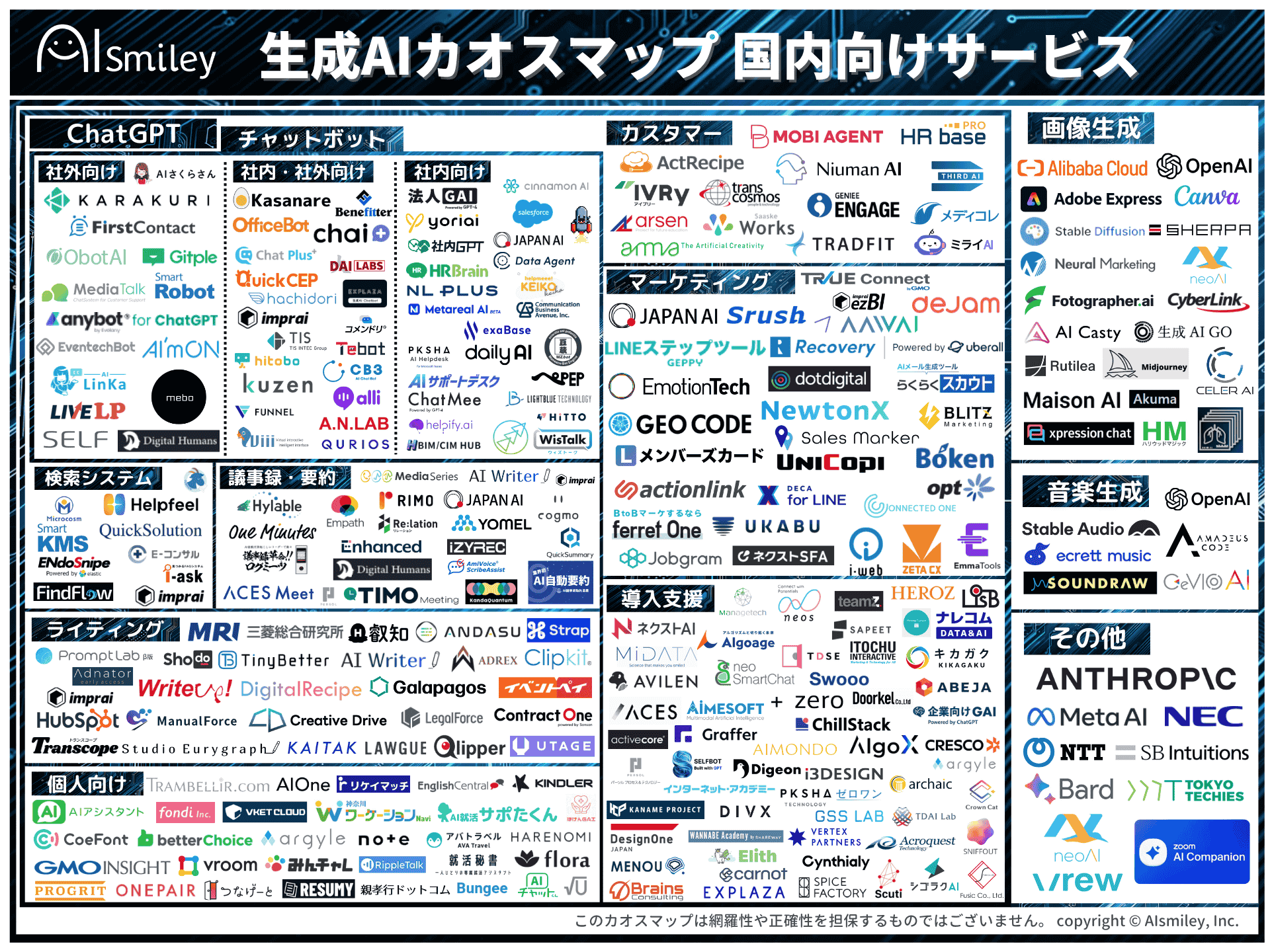

また、RLHFは言語モデルだけでなく、画像生成AIや音声合成AIなど、様々な種類のAIモデルにも適用可能です。例えば、画像生成AIの場合、生成された画像の品質や適切さについて人間からフィードバックを得て、モデルの性能を向上させることができます。

強化学習は機械学習の一種であり、試行錯誤を通じて与えられた課題を処理する学習方法です。

強化学習の基本的な仕組みは以下の通りです。

例えば、チェスのAIを強化学習で訓練する場合、エージェントはチェスのAI、環境はチェスのゲーム盤面、行動は駒の動かし方、報酬は勝利や有利な局面の獲得などになります。AIは多数の対局を通じて、どの行動が高い報酬につながるかを学習し、徐々に強くなっていきます。

強化学習の特徴は、明示的な教師データを必要としない点です。代わりに、試行錯誤を通じて最適な戦略を見つけ出します。これにより、複雑な問題や動的な環境に対しても柔軟に対応できるモデルを作ることができます。RLHFは、この強化学習の枠組みに「人間のフィードバック」という要素を加えたものといえます。

ファインチューニングとは、事前学習済みの学習モデルに対して、特定のタスクに特化させた訓練を行う「目的特化型の機械学習」のことを指します。一方、RLHFは強化学習の一種であり、人間のフィードバックを活用してモデルの振る舞いを調整する手法です。

ファインチューニングとRLHFの主な違いは以下の通りです。

| 項目 | ファインチューニング | RLHF |

| 学習の目的 | 特定のタスクに対する モデルの性能向上 |

人間の価値観や意図に沿った出力を生成 |

| 学習データ | タスク固有のラベル付き データセット |

人間からのフィードバック(評価や順位付け等) |

| 学習プロセス | 通常の教師あり学習 (損失関数の最小化) |

強化学習(報酬の最大化) |

| 適用範囲 | 主に特定のタスクや領域に対する性能向上 | モデルの全般的な振る舞いや倫理的側面の改善 |

例えば、感情分析タスクのためにBERTモデルをファインチューニングする場合、感情ラベル付きのテキストデータを使用して学習を行います。一方、RLHFを用いてChatGPTの応答を改善する場合、モデルの出力に対する人間の評価を基に学習を進めます。

ファインチューニングとRLHFは相互排他的ではなく、しばしば組み合わせて使用されます。例えば、特定のタスクに対してファインチューニングを行い、その後RLHFを適用して人間の価値観に沿うように調整するといった手順が取られることがあります。

RLHFの重要性は、AIモデル、特に大規模言語モデル(LLM)のパフォーマンスを飛躍的に向上させ、より正確で有用な出力を生成可能にする点です。この手法を適用することで、モデルは単に与えられたデータから学習するだけでなく、人間の価値観や意図に沿った振る舞いを獲得することができます。これは、AIの社会実装が進む現代において、極めて重要な進歩といえます。

RLHFが重要である理由の一つは、人間の価値観を効果的に反映できることです。例えば、OpenAIのChatGPTは、RLHFを活用することで、不適切な内容の生成を抑制し、より的確で倫理的な情報提供を行うよう調整されています。これにより、AIモデルの出力がより社会的に受け入れられやすくなり、有害な内容や偏見を減らすことが可能です。

RLHFの仕組みは、大きく分けて4つのステップから構成されています。各ステップでは、AIモデルが人間のフィードバックを効果的に学習し、より適切な出力を生成できるように調整が行われます。これらのステップを通じて、モデルは人間の価値観や意図をより深く理解し、それに沿った応答を生成できるようになります。

RLHFのプロセスは、基本的な機械学習の概念を拡張し、人間の判断を直接モデルの学習に組み込むという革新的なアプローチを取っています。このアプローチにより、AIモデルは単なるパターン認識や予測を超えて、人間の複雑な価値観や意図を反映した出力の生成が可能です。

ここからは、各ステップについて詳しく説明していきます。各ステップには固有の目的と手法があり、これらが組み合わさることで、RLHFの効果的な実装が可能になります。各ステップは以下の通りです。

次に、それぞれのステップについて、より具体的にみていきます。

学習ステップ0はRLHFプロセスの準備段階です。ここでは適切な言語モデルの選択と準備が最も重要です。GPT-3やLLAMAなどの既存の大規模言語モデルから、タスクの性質や必要な計算リソースを考慮して選びます。十分なGPUやメモリなどの計算リソースも確保します。

また、モデルの評価や微調整に使用するデータセットを用意し、モデルの性能を測るための評価指標を決定します。さらに、後のステップで必要となる人間の評価者を確保します。このステップは後続のプロセスの成功を左右する重要な準備段階となります。

学習ステップ1では、選択したベースモデルに対して初期の微調整を行います。まず、タスクに関連する多様なプロンプトを用意し、それぞれに対する理想的な回答を人間の専門家が作成します。これらのプロンプトと回答のペアを使用して、ベースモデルに対して教師あり学習を実施します。

学習率やバッチサイズなどのハイパーパラメータの調整も行い、学習の効率と効果を最適化します。過学習を防ぐため、検証データセットを使用してモデルの汎化性能を監視します。最後に、微調整されたモデルの性能を評価し、後続のステップでの改善を測る基準となる指標を記録します。

学習ステップ2では、人間のフィードバックを基に報酬モデルを構築します。まず、ステップ1とは別の多様なプロンプトを用意し、微調整したモデルを使って各プロンプトに対する複数の応答を生成します。次に、人間の評価者がこれらの応答の質や適切さを評価します。

この評価データを使用して、応答の質を予測する報酬モデルを訓練します。報酬モデルは、プロンプトと応答のペアを入力として受け取り、その応答の「良さ」を数値化して出力します。最後に、訓練された報酬モデルの性能を検証し、必要に応じて調整を行います。このステップは、人間の価値観をAIシステムに組み込む重要な過程です。

学習ステップ3では、ステップ2で構築した報酬モデルを使用して、言語モデル(政策モデル)を最適化します。多様な入力プロンプトを含むデータセットを用意し、現在の政策モデルを使ってそれらのプロンプトに対する応答を生成します。生成された応答は報酬モデルによって評価され、スコアが付与されます。

このスコアを基に、政策モデルのパラメータを更新します。この過程では通常、Proximal Policy Optimization (PPO)などの強化学習アルゴリズムが使用されます。このステップを繰り返すことで、政策モデルは徐々に改善され、より高品質な応答を生成できるようになります。これにより、AIモデルは人間の価値観に沿った出力を生成する能力を獲得します。

RLHFは、AIモデルの性能向上に貢献する一方で、いくつかの重要な課題も抱えています。最大の課題は、人間のフィードバックの質がモデルの性能に直接影響を与える点です。不適切または偏ったフィードバックは、モデルの行動に悪影響を及ぼす可能性があります。例えば、評価者の個人的バイアスがAIの学習に反映されてしまう危険性や、人間の評価の一貫性の欠如も問題となります。

コスト面も大きな課題です。高品質なフィードバックの収集には多大な時間、労力、費用がかかります。特に専門知識が必要な分野では、適切な評価者の確保が困難で高コストになります。さらに、RLHFプロセス自体が計算集約的であり、大規模な計算リソースを必要とします。

これらの課題に対処するため、いくつかのアプローチが検討されています。例えば、評価者の選定と訓練を厳密に行い、フィードバックの質を向上させる試みがあります。また、AI自体を活用して人間のフィードバックを補完する「AI Feedback」の研究も進められています。コスト面では、クラウドソーシングを活用してフィードバック収集を効率化したり、転移学習を用いて既存のRLHFモデルを新しいタスクに適応させたりする方法が探られています。

RLHFは、人間のフィードバックを活用してAIモデルを改善する革新的な手法です。強化学習の原理を応用し、ファインチューニングとは異なるアプローチで、モデルの性能と適切性を向上させます。その重要性は、人間の価値観をAIに反映させ、より安全で有用な出力を生成できる点にあります。

RLHFの学習プロセスは4つのステップで構成され、適切なモデルの選択から始まり、教師あり学習、報酬モデルの構築、そして最終的な強化学習による最適化へと進みます。各ステップでは、人間の評価を効果的に取り入れ、モデルの振る舞いを段階的に改善していきます。

しかし、RLHFにはフィードバックの質や一貫性、高いコストなどの課題もあります。これらの課題に対処しつつ、RLHFを効果的に活用することで、AIの発展と社会への適切な統合が期待されます。

業務の課題解決に繋がる最新DX・情報をお届けいたします。

メールマガジンの配信をご希望の方は、下記フォームよりご登録ください。登録無料です。

AI製品・ソリューションの掲載を

希望される企業様はこちら