生成AI

最終更新日:2024/04/30

ベンジオ氏 AIの安全性をめぐり講演

ベンジオ氏 AIの安全性をめぐり講演

2024年3月7日(木)、東京大学の松尾・岩澤研究室とJDLAが主催でヨシュア・ベンジオ氏の特別講演が開催されました。参加者は会場の東京大学に訪れた学生やAI資格保有者など、オンラインも含めのべ1500人以上にのぼりました。AI研究分野での第一人者であるベンジオ氏が、昨今あまりに急速に進化するAI技術の社会的インパクトを踏まえ、安全なAI開発について提言しました。

ベンジオ氏はモントリオール大学コンピュータサイエンス学部の教授で、コンピューター界のノーベル賞として知られる「チューリング賞」をはじめ、数々の受賞と功績を残しAIの世界をけん引しています。また、近年はAIのリスクやアライメント(整合性)についての研究活動にも力を入れています。

講演にはベンジオ氏のほか、日本ディープラーニング協会理事長であり、東京大学で教授を務める松尾豊氏と、同じく東京大学で准教授を務める江間有沙氏が登壇。後半は二人を交えた会場参加者とのQ&Aセッションが開かれ、技術的な課題やAIと社会をめぐる課題について議論されました。

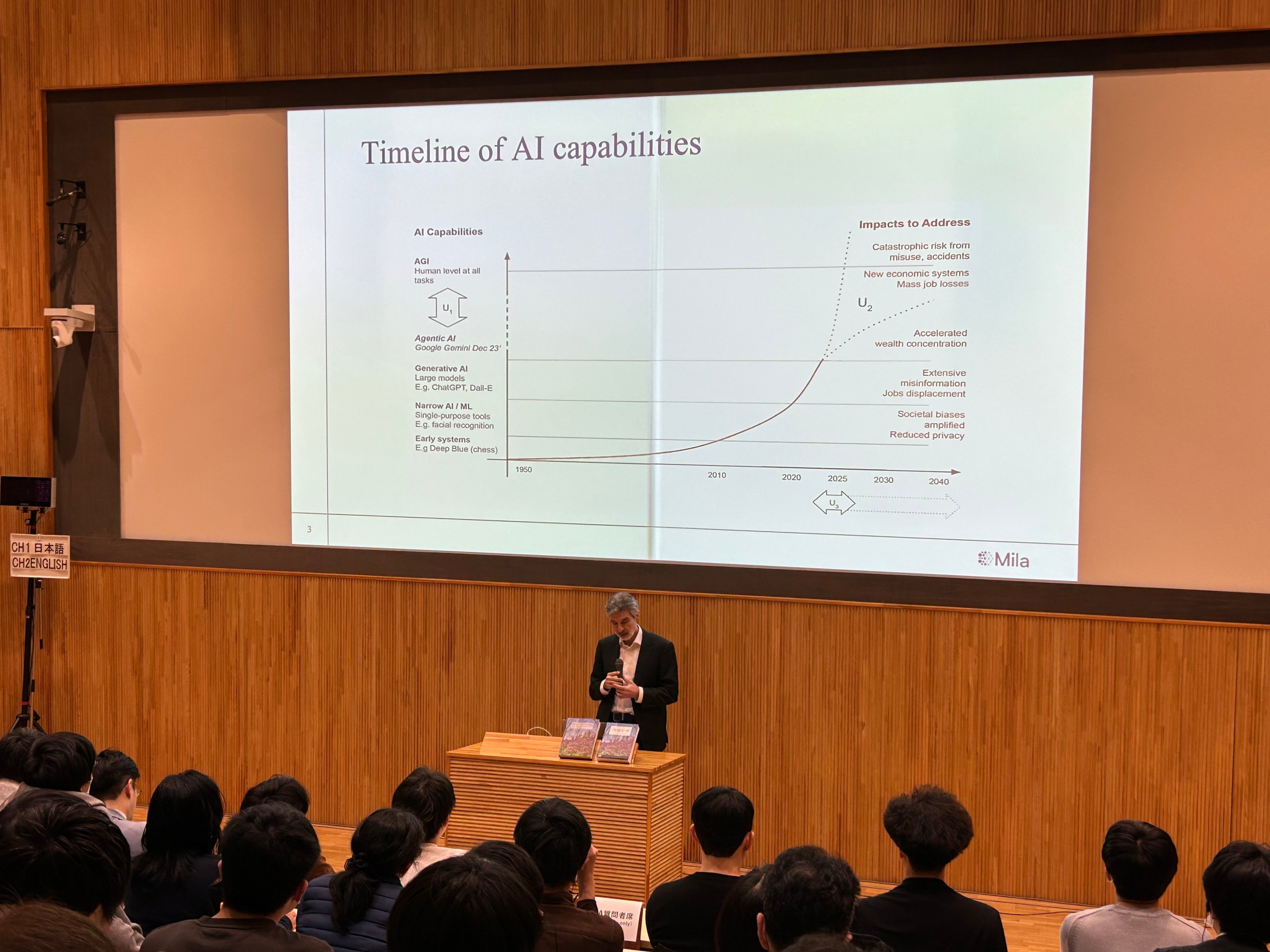

ベンジオ氏は本公演を通し、AIの安全性について考える動機付けについて、科学的な方向性やアプローチ、破壊的な発展を防ぐための実際の取り組みについて解説。冒頭でベンジオ氏は急速な発展を遂げるAIの背景を説明し、今後もとどまることなく進化を続ける状況において、科学者や開発者にとって重要なことは「今後何が起こりうるかを考えること」とし、AIを慎重に扱う必要があると述べました。

AIが人間の能力を超えることはないと考える専門家が一部存在する中、ベンジオ氏はChatGPTの使用体験をきっかけに、近い将来でAGI(汎用人工知能)は実現すると考えています。AGIは高速かつ完全に社会を変える危険信号と捉え、事前に正しい未来へナビゲートする必要があると主張しました。

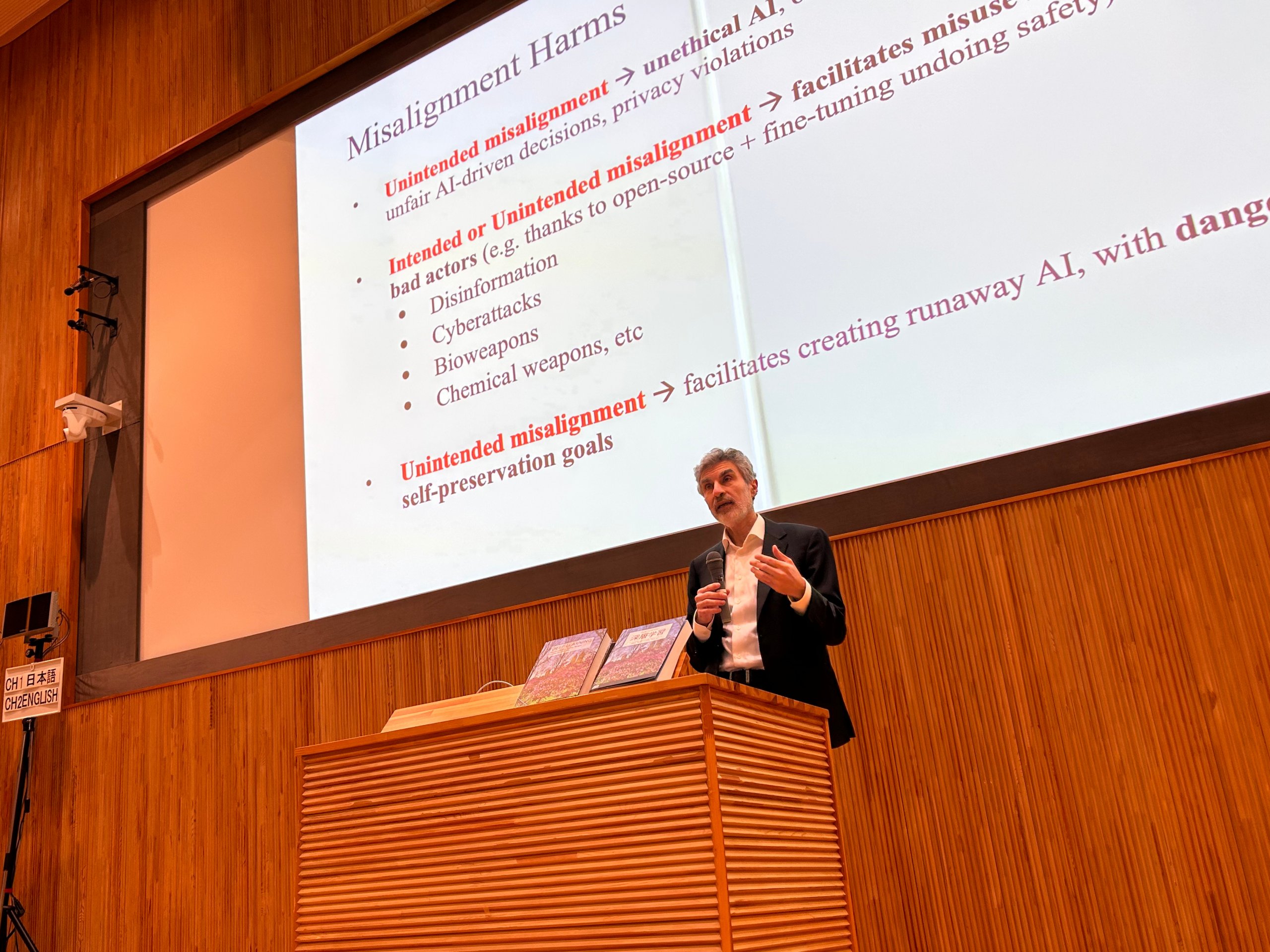

このようなAIの発展において、まず悪影響となる要素について知る必要があるとし、二つの事例を挙げました。一つ目は、AIが学習や判断を行っていく目的の中で、「悪意」が設定されること。二つ目は、AIが意思を持ち、人間が持つような自身を残したいといった「自己保存の欲求」が発生する可能性についてです。

ベンジオ氏はこれらに対し、AIと人間が共通の「道徳的アライメント」を構築するにはどうすればいいか、反対にアライメントが一致しなかった場合にどうすべきかを考えることが重要だと主張。現在、差別や偏見、公平性、プライバシーをAIが理解しないゆえに意図されず起こる問題が懸念されていますが、これはそもそも人間社会において「道徳的アライメント」が一致していない事態が考えられています。

また実際に、悪影響を受けたAIの使用例として、AIが選挙のために使われる可能性について取り上げられました。人に影響を及ぼすように調整された強力なAIシステムによって、選挙の結果が覆されたり、そのようなシステムをコントロールする人間が権力を得る可能性が危惧されています。こうした民主主義が脅威に陥るような大型のAIシステムの取り組みには、ガバナンスが必要だと主張しました。

他にも、ウクライナやガザで実際にAIシステムを使ったドローンが使われていることについても言及し、軍事的兵器として使用されるAIシステムが制御不能になった場合、恐ろしい脅威となることは明白であると述べました。

このように、AIの進歩が進むにつれて犯罪者のツールにもなり得る危険性があり、人間はより高い知能を持つAIを創造してしまう前に、制御する術を考え出さなければならないと警告しました。

続けてベンジオ氏は、AIがコントロールを失うシナリオについて動物とAIを比較した例をイメージにして解説しました。熊は人間にとって脅威ですが、檻に入れられた熊はカギを開けるほどの知能はありません。熊はトレーニングによって人間の望む行動を取らなければ餌(報酬)をもらえないことを学習し、人間が制御ができる状態を保てます。

AIも人間の指示によって報酬を獲得するためのトレーニングを行いますが、AIの場合は制御不能になると、人間が望んだ行動以外の方法を学習し始めてしまいます。さらに報酬を得られるメカニズムを理解した上で、望まれていない行動を取るようになるため、人間を排除することも予想されます。

動物とAIの比較に加え、AIを扱う人間についての問題もあるとコメント。悪意を持って檻のカギを開けてしまう人や、そもそも檻のない危険なAIを作ってしまう人がいると述べました。オープンソースAIはファインチューニングをすると、簡単に安全性が失われる可能性があります。そして現在のAI科学では、保証された安全な檻を作ることが出来ていないと指摘しました。

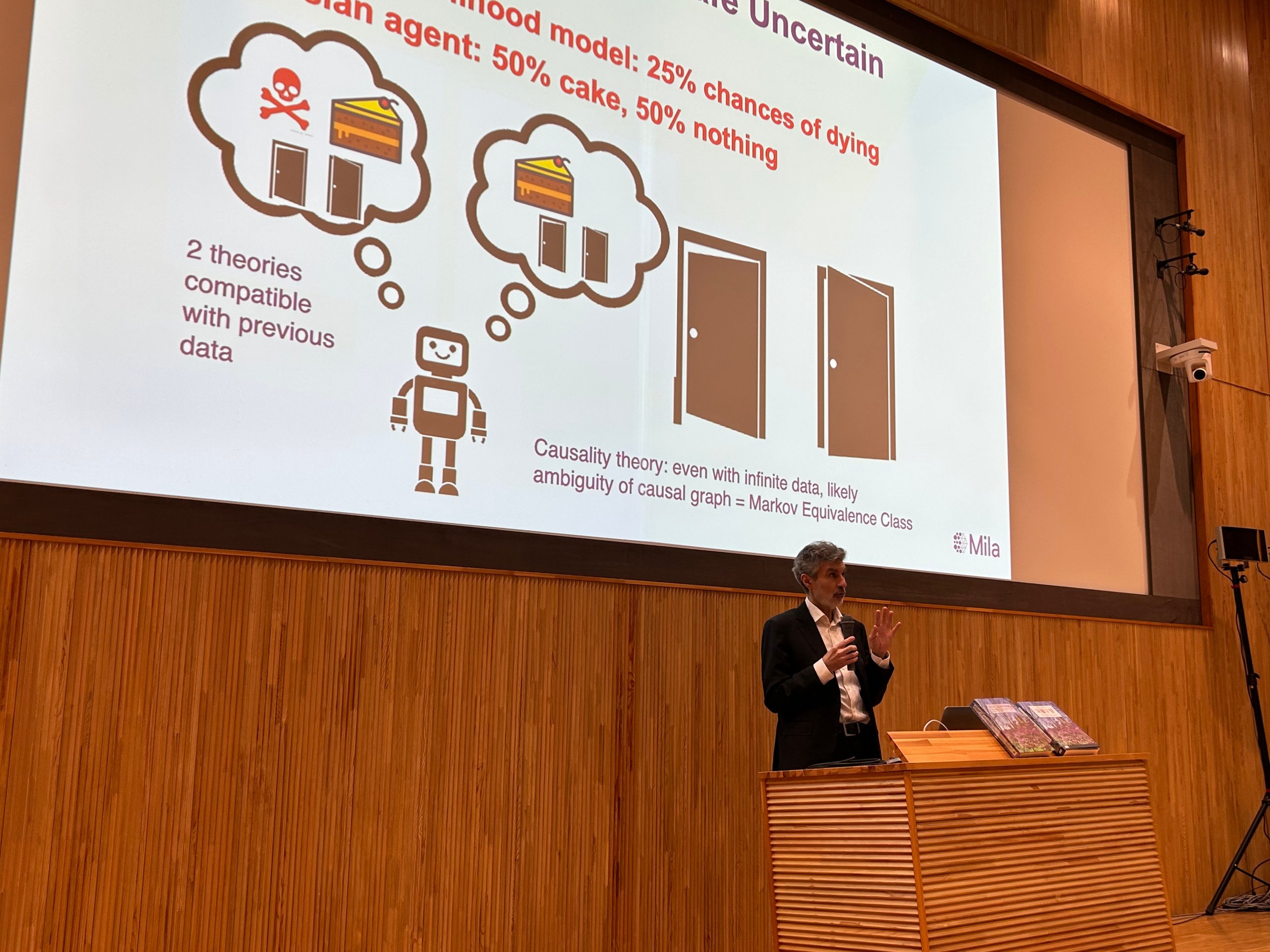

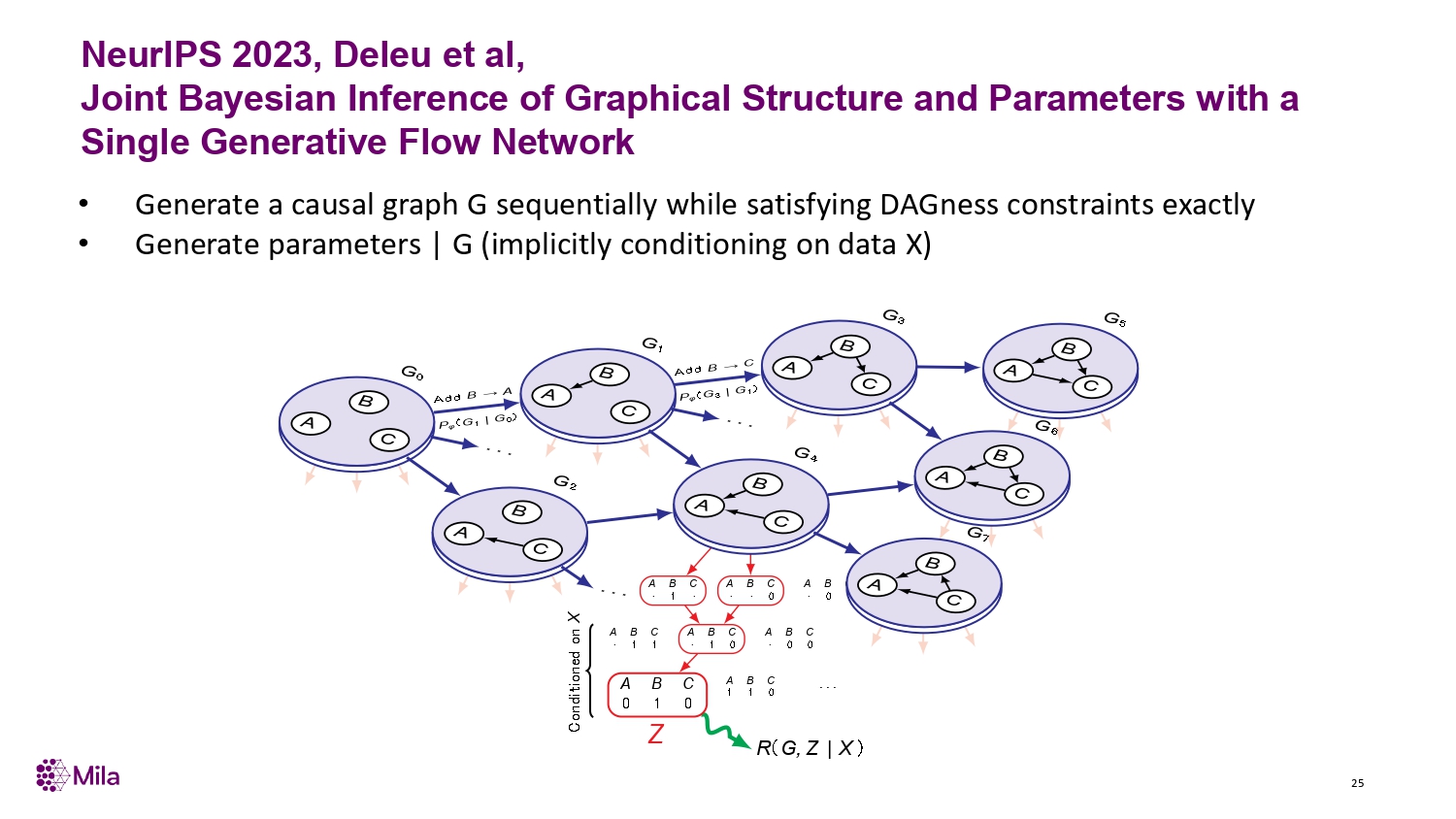

では、現実世界を理解し、科学者や企業を助けてくれるようなAIを作るにはどうすればいいか。ベンジオ氏はAI開発への鍵となる理論「ベイズ推定」と、自身が研究を進めている深層学習における最新生成モデル「GFlowNet」について明かしました。

「ベイズ推定」とは、あらゆるリスクの平均値を最小にするための統計的方法です。これによって全てのリスクを追跡し、合理的な決定をすることで、AIが致命的となる判断を避けることが可能になると考えられています。

しかし、ベイズ推定のメソッドは現実的ではなく、指数関数的な計算量が必要とされています。このような計算ができるAIを設計するためには、世界がどのように機能しており、人間が何を善悪とみなすか等を理解できるための大規模なニューラルネットワークが必要です。

ベンジオ氏らの研究チームはこの数年間、これらを近似できるニューラルネットワーク上での機械学習の研究を行い、「GFlowNet」という手法を提案しました。この学習方法は因果関係の発見や推論ができるシステムの重要な要素になるとされており、膨大な計算を小規模に実行できるものです。

こうした研究開発が行われる一方で、AIの安全性のために開発リソースを注がないAI研究者やビジネスユーザーに対し、どのように働きかけるべきかが問われています。

ベンジオ氏はこれらについて、政府は企業の行動を調整するルールやインセンティブを提供し、安全性に関する研究を促す必要があるとコメント。AI製品の承認は医薬品産業のように、安全性が証明された場合にのみ行われるべきであり、ルールを守らない企業が市場を支配することを防ぐために競争を公平にする必要があると述べました。

AIは人類の未来を大きく変革する可能性を秘めていますが、同時に大きなリスクも伴います。 ベンジオ氏の講演は、AIの安全性について深く考えさせられる内容でした。

AI開発における倫理的な問題、悪意を持った利用を防ぐための方法、制御不能なAIの出現を防ぐための技術開発など、解決すべき課題はまだ多くあります。これらの課題を克服し、AIを人類に貢献する存在にするためには、科学者、開発者、政府、そして一般市民が協力して取り組む必要があるでしょう。

業務の課題解決に繋がる最新DX・情報をお届けいたします。

メールマガジンの配信をご希望の方は、下記フォームよりご登録ください。登録無料です。

AI製品・ソリューションの掲載を

希望される企業様はこちら