生成AI

最終更新日:2024/07/29

AIガバナンスとは?

AIガバナンスとは?

この記事は、AI活用に関心のある企業の情報システム部門やAI開発部門の方々に読んでいただきたい内容です。AIガバナンスの概要や必要性を知ることで、自社のAI開発・運用におけるリスク管理の方針策定に役立てることができるでしょう。最新のガイドラインの動向や先進企業の具体的な取り組み事例も紹介します。

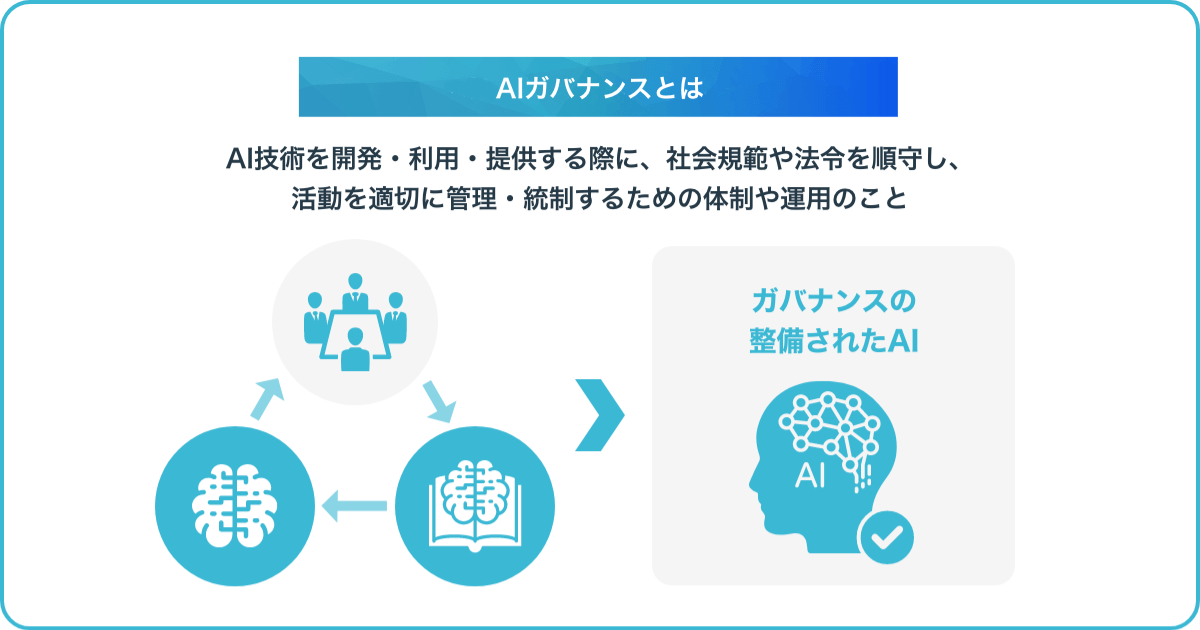

AIガバナンスとは、AI技術を開発・利用・提供する際に、社会規範や法令を順守し、活動を適切に管理・統制するための体制や運用のことを指します。AIの判断には、学習データの偏りや開発者の意図しない動作など、従来のITシステムとは異なるリスクがあります。

そのため、説明責任や公平性、プライバシー保護など、AIならではの視点からのガバナンスが求められるのです。AIを社会実装していく上で、ステークホルダーから信頼を得るためにも、AIガバナンスの整備は必要不可欠だといえます。

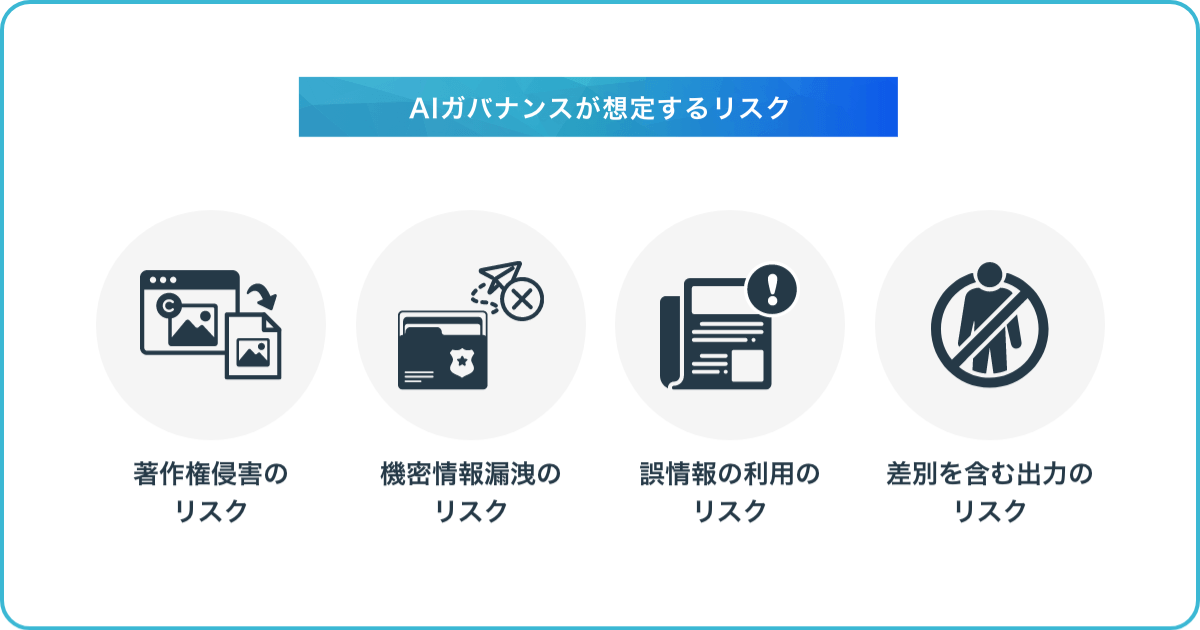

AIガバナンスでは、AI活用によって生じる可能性のある様々なリスクを想定し、それを未然に防ぐための対策を講じることが重要です。具体的には、以下のリスクが挙げられます。

これらのリスクは、企業の法的責任や社会的信用の失墜につながるだけでなく、AIに対する社会の不信感を招くことにもなりかねません。適切なAIガバナンスの実践によって、これらのリスクを最小限に抑え、ステークホルダーからの信頼を獲得していくことが求められます。以下、それぞれのリスクについて詳しく見ていきましょう。

AIによって生成された文章や画像、音楽などのコンテンツは、元となったデータに含まれる著作物の表現を再現している可能性があります。したがって、AIの学習に使用するデータの著作権処理を適切に行わないまま、生成物を無断で利用・公開すると著作権侵害のリスクが生じます。

例えば、ある小説家の作品を大量に学習させたAIが、その小説家の文体を模倣した文章を生成したとします。その文章を許諾なく商用利用した場合、小説家の著作権を侵害したと見なされる恐れがあります。また、AIが生成した楽曲やイラストを無断でコンテンツに使用することで、原著作者から訴訟を起こされるリスクもあるでしょう。

企業がAIの学習データとして自社の機密情報を使用する場合、その情報がAIモデルに埋め込まれ、意図せず外部に漏洩してしまうリスクがあります。例えば、顧客情報や技術情報、営業データなどを学習に使ったAIチャットボットが、利用者とのやりとりの中でそれらの情報を口外してしまう可能性が考えられます。

外部に公開するAIサービスの場合、サイバー攻撃によって機密情報が流出する危険性もあります。学習データやモデルの管理が不十分だと、AIシステムを通じて社内の機密情報が外部の悪意ある第三者に渡ってしまうおそれがあるのです。

機密情報の漏洩は、企業の競争力の源泉を失うだけでなく、顧客からの信頼を大きく損なう結果となります。漏洩した個人情報の悪用によって、本人が経済的・精神的被害を受ける可能性もあります。企業は責任を問われ、多額の賠償金の支払いを求められるかもしれません。

AIは学習したデータに基づいて判断を下しますが、元データに誤りや偏りがあると誤った情報を正しいものとして利用してしまうリスクがあります。例えば、フェイクニュースや根拠の乏しい情報、時代遅れの知識などをそのまま鵜呑みにし、誤った判断をしたり不適切なレコメンデーションをしたりする恐れがあるのです。

AIが提供する情報やサービスの内容が不正確だったり、誤解を招くものだったりすると、ユーザーの利便性を損なうだけでなく、意思決定を誤らせて実害を与えてしまう可能性もあります。例えば、AIによる金融商品の推奨や診療サポートが誤っていた場合、利用者に経済的損失や健康被害を及ぼすリスクが考えられます。

また、悪意を持った第三者が、AIの判断を狂わせる目的で、意図的に誤った情報を学習データに混ぜ込むことも想定されます。データの出所が明らかでない場合は特に、AIが誤情報に基づいて不適切な判断をする危険性が高まります。

これらのリスクに対処するには、AIの学習に用いるデータの品質を慎重にチェックし、信頼できるソースから収集することが重要です。

AIによる自然言語処理や画像認識では、学習データに含まれる人種、性別、年齢などの属性に関する偏見が、そのままAIの判断に反映されてしまう可能性があります。例えば、特定の人種や性別を差別するような表現を含むテキストデータを大量に学習したAIは、差別的な発言を生成したり、採用の合否判定で特定の属性の人に不利な評価を下したりするかもしれません。

こうしたAIのアウトプットは、企業の公平性や倫理観に対する社会の信頼を大きく損ねる結果につながります。不当な差別による個人の尊厳の侵害は許されるものではありません。AIを利用したサービスによって特定の属性の人が不利益を被れば、企業は訴訟リスクを抱えることにもなるでしょう。

データやアルゴリズムの公平性を担保するには、学習データに偏りがないかを注意深く検証し、必要に応じて是正することが重要です。

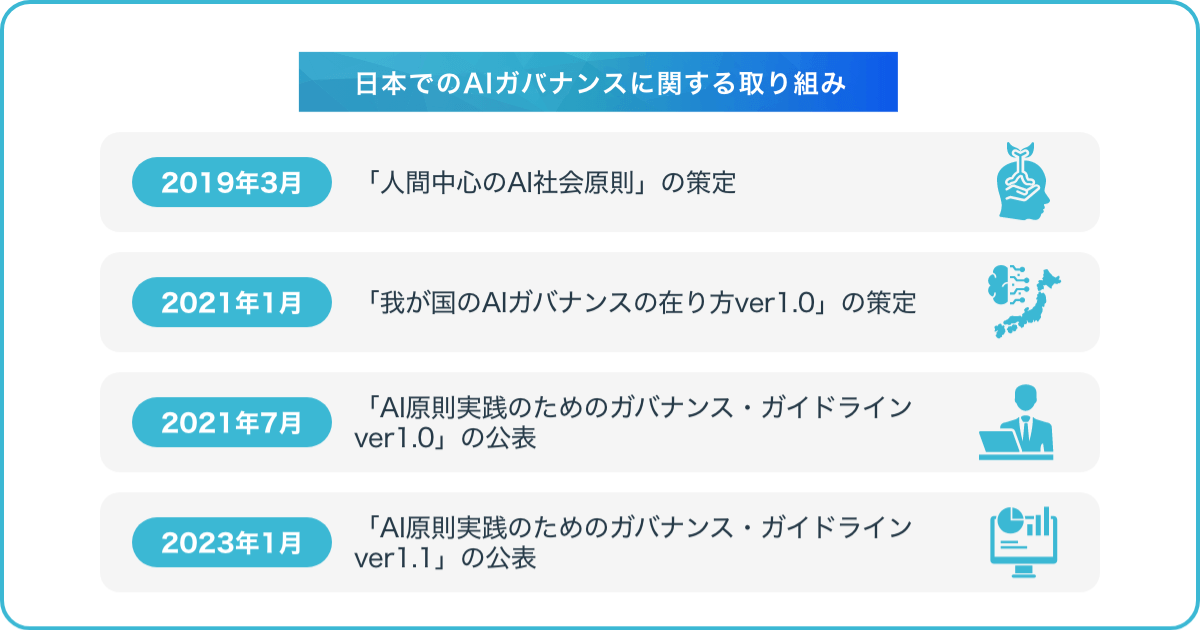

日本では、技術の発展に伴い、AIガバナンスに関する議論や取り組みが活発化しています。

2019年3月には、「人間中心のAI社会原則」が策定されました。これは、人間の尊厳が尊重され、多様な人々が幸せを追求できる持続可能な社会を実現するためのAI利活用の指針を示したものです。その後、2021年1月に「我が国のAIガバナンスの在り方ver1.0」が策定され、国内外のAI原則やルール形成の動向を構造的に示し、日本におけるAIガバナンスの全体像が提示されました。

さらに、2021年7月には「AI原則実践のためのガバナンス・ガイドラインver1.0」が公表されました。これは、企業や事業者がAI原則を実践する際の具体的な行動目標と実践例を示したガイドラインです。そして2023年1月、より詳細な解説や事例を盛り込んだ「AI原則実践のためのガバナンス・ガイドラインver1.1」が公表されています。

このように、日本ではAIガバナンスに関する原則からより具体的な実践レベルまで、段階的に取り組みが進められています。

「人間中心のAI社会原則」は、AI社会の実現に向けて各ステークホルダーが留意すべき基本原則を定めたものです。人間中心、教育・リテラシー、プライバシー確保、セキュリティ確保、公正競争確保、公平性・説明責任・透明性、イノベーションの7つの原則から構成されています。

| 原則 | 概要 |

| 人間中心の原則 | AIはあくまで人間の能力を拡張するための道具であり、人間がAIを使いこなすことで、より豊かな生活を送ることができる社会を目指すべきだとしています。 |

| 教育・リテラシーの原則 | 教育・リテラシーの原則では、すべての人にAIリテラシー教育の機会が提供され、学びの環境が整備されるべきだと述べられています。 |

| プライバシー確保の原則 | パーソナルデータの重要性に応じた適切な保護が求められています。 |

| セキュリティ確保の原則 | セキュリティ確保の原則では、AIのリスクを正しく評価し、リスク管理のための取り組みを進めることが重要だとしています。 |

| 公平競走確保の原則 | 公正競争確保の原則では、AIによる富や影響力の偏りのない社会を目指すべきだと述べられています。 |

| 公平性、説明責任及び透明性の原則 | 公平性・説明責任・透明性の原則では、AIによって不当な差別が生じないこと、AIの利用について適切な説明がなされること、対話の場が設けられることなどが求められています。 |

| イノベーションの原則 | 産学官民の垣根を越えた連携によって、イノベーションを促進していくべきだとしています。 |

「我が国のAIガバナンスの在り方」は、海外の動向も踏まえつつ、日本におけるAIガバナンスの全体像を提示したものです。リスクベース・アプローチを基本とし、AIガバナンスの要素を、技術中立的なゴール、横断的で中間的なルール、個別分野等にフォーカスしたルール、モニタリングとエンフォースメントの4つのレイヤーに整理しています。

例えば、最上位のゴールには、「人間中心のAI社会原則」などのAI原則が位置づけられます。次の中間的なルールには、法的拘束力のないガイドラインや法的拘束力のある横断的な規制、国際標準などが含まれます。個別分野等にフォーカスしたルールには、特定の利用態様や分野に対する規制、政府利用への規制などが挙げられます。最後のモニタリングとエンフォースメントでは、ルールの運用状況の監視と実効性確保の仕組みについて言及しています。

参考:経済産業省|我が国のAIガバナンスの在り方ver1.1

「AI原則実践のためのガバナンス・ガイドライン」は、企業や事業者がAI原則を実践する際の具体的な行動目標と実践例を示したガイドラインです。AIの開発や利用に伴うリスクを把握し、ステークホルダーにとって受容可能な水準で管理するためのプロセスや体制について解説しています。

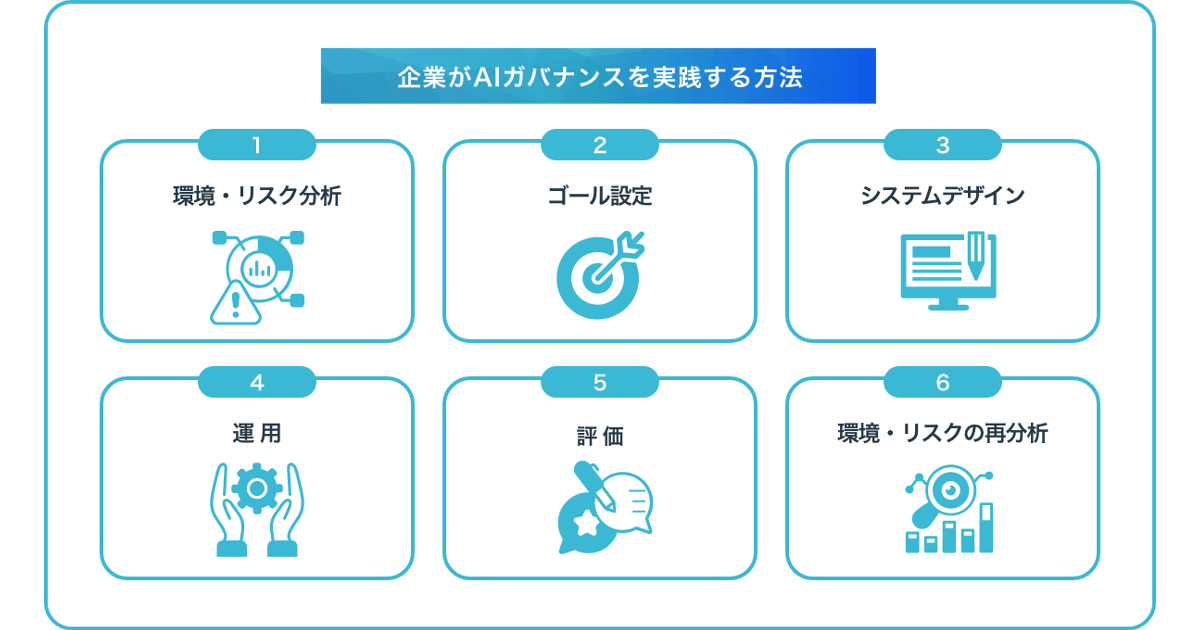

ガイドラインは、環境・リスク分析、ゴール設定、システムデザイン、運用、評価、環境・リスクの再分析の6つのフェーズから構成されています。各フェーズにおいて実施すべき行動目標が示され、具体的な実践例も紹介されています。

例えば、環境・リスク分析のフェーズでは、AIシステムがもたらす正負のインパクトや社会的受容、自社のAI習熟度などを分析することが求められます。

参考:経済産業省|AI原則実践のためのガバナンス・ガイドラインVer1.1

AIガバナンスに関する取り組みは様々な企業で行われています。総務省の「AIネットワーク社会推進会議」が「AIガバナンスに関する取組事例」として事例を紹介しており、ここでは事例の一部を紹介します。

| 観点 | 取り組み事例 |

| 組織と責任 | ・CEOが指名するAI倫理委員会の委員長を責任者とする ・AI倫理に関するガバナンスを内部統制の一環として受け止め、経営の問題として捉える |

| 人材育成 | ・AI倫理やAIリテラシー等の理解を深めるeラーニングを実施し、テストによって理解度を確認する ・事業リスクの洗い出しなどを行うためのワークショップや勉強会、有識者を招いたセミナーを開催する |

| 指針・ガイドライン・原則 | ・「AI倫理原則」を策定するとともに、ホワイトペーパーを社外に公開する ・AI特有のリスクなどをまとめたAI導入ガイドラインを策定する |

| セキュリティ | ・従来から産業規格等に基づくセキュリティ確保のための体制の構築やルールの整備を行っており、既存の体制やルールをもとに、AIに関するセキュリティ対策を実施している。 ・AIに対する攻撃を検知する技術や攻撃を防御する技術について研究開発を行う |

| プライバシー | ・従来から法令等に基づく個人情報保護のための体制の構築やルールの整備を行う。 ・国内の法令だけではなく、海外の法令にも基づいて個人情報保護のための体制を構築し、AIに関するプライバシー保護に対応する |

| 公平性 | ・日本、米国、欧州において価値観が異なるような多元的な公平性、性別や人種のように様々な属性が重なることにより非線形に差異が発生する交差バイアスを抽出し、AIの精度とのバランスを考慮しつつバイアスを軽減する処置を行う。 ・AIのデータやモデルのバイアスを測定ツールを一部オープンソースとして公開する。 |

| 透明性とアカウンタビリティ | ・顧客の理解・納得を得るために、説明可能なAI(XAI:Explainable AI)に関する技術・ツールを開発している。 ・学習データやモデル構築のプロセスに関するファクトシートを作成するとともに、標準化に向けた取組を行っている。 |

企業がAIガバナンスを実践する方法は以下の流れとなります。

| 行動 | 行動目標 |

| ①環境・リスク分析 | (1)AIシステムがもたらしうる正負のインパクトを理解する (2)AIシステムの開発や運用に関する社会的受容を理解する (3)自社のAII習熟度を理解する |

| ②ゴール設定 | (1)AIガバナンス・ゴールの設定を検討する |

| ③システムデザイン | (1)AIガバナンス・ゴールからの乖離の評価と乖離への対応を必須プロセスとする (2)AIマネジメントシステムを担う人材のリテラシーを向上させる (3)適切な情報共有等の事業者間・部門間の協力によりAIマネジメントを強化する (4)インシデントの予防と早期対応により利用者のインシデント関連の負担を軽減する |

| ④運用 | (1)AIマネジメントシステムの運用状況について説明可能な状態を確保する (2)個々のAIシステムの運用状況について説明可能な状態を確保する (3)AIガバナンスの実践状況を非財務情報に位置づけて積極的な開示を検討する |

| ⑤評価 | (1)AIマネジメントシステムが適切に機能しているかを検証する (2)社外ステークホルダーから意見を求めることを検討する |

| ⑥環境・リスクの再分析 | (1)行動目標1-1から1-3を適時に再実施する |

参考:経済産業省|AI原則実践のためのガバナンス・ガイドラインVer1.1

環境・リスク分析では、まずAIシステムを開発・運用する企業が、得られる正のインパクトだけでなく、意図せざるリスク等の負のインパクトについて理解し、経営層で共有することが求められます。潜在的な利用者像や用途を具体的にイメージし、AIリテラシーや過去のインシデント事例などを調査します。

その上で、開発・運用するAIシステムが社会に与える影響の大きさを見極め、自社のAI習熟度を評価します。AIシステムの開発・運用経験やエンジニアのスキル、倫理面でのリテラシーなどを総合的に判断するのです。負のインパクトが軽微な場合はAI習熟度評価を省略できますが、その場合はステークホルダーに理由を説明できるようにしておく必要があります。

ゴール設定では、環境・リスク分析の結果を踏まえ、国の「人間中心のAI社会原則」に則して、自社のAIガバナンス・ゴールを定めます。具体的には、AIポリシーの策定などが想定されています。

ゴール設定に際しては、AIがもたらす正負のインパクトや社会的受容、自社のAI習熟度など、多面的な要素を考慮する必要があります。特に負のインパクトが大きい場合は、より慎重にゴールを検討すべきでしょう。一方、負のインパクトが軽微な場合は、ゴールを設定しない選択肢もありえます。ただしその場合は、ステークホルダーに対してゴールを設定しない理由を説明できるようにしておくことが求められます。

「システムデザイン」では、設定されたAIガバナンス・ゴールの達成に向けて、AIマネジメントシステムを具体的に設計します。ここでの「システム」とは、AIシステム自体だけでなく、その開発・運用を支える組織や業務プロセス、ルールなども含む包括的な概念です。まず、AIガバナンス・ゴールからの乖離を評価し、その乖離を解消するPDCAサイクルを回すプロセスを、開発や運用の各段階に組み込むことが求められます。

その際、社会的な受容性への配慮とともに、自社のAIシステムが関わる業界の標準的な実務なども参照しながら、乖離の許容範囲を適切に設定する必要があります。

「運用」では、構築したAIマネジメントシステムを実際に稼働させ、AIガバナンス・ゴールの達成に向けた取り組みを進めていきます。運用段階で特に重要なのは、PDCAサイクルを着実に回していくことです。まず、AIマネジメントシステム全体の運用状況や、個々のAIシステムの稼働状況について、常にモニタリングを行い、データを記録していくことが求められます。これにより、システムの不具合や想定外の事態の発生を迅速に検知し、適切な対応につなげることができます。

そうした日々の運用の中で、AIガバナンス・ゴールに照らして、システムの改善すべき点が明らかになることもあるでしょう。その場合は、PDCAサイクルに則って、速やかに見直しや修正を図ることが重要です。場合によっては、ゴール自体の妥当性を問い直し、より適切な方向にシフトしていくことも必要となります。

「評価」では、構築・運用してきたAIマネジメントシステムが、AIガバナンス・ゴールの達成にどの程度寄与しているかを検証します。これは、システムの設計や運用方針の妥当性を担保し、説明責任を果たす上でも重要なプロセスとなります。

評価に際しては、システム開発・運用の責任者とは独立した立場の者が担当することが望ましいとされます。社内の内部監査部門や、外部の専門家などを起用することで、客観的な視点からの検証が可能となります。

評価の具体的な着眼点としては、まず、PDCAサイクルが適切に機能しているかどうかが挙げられます。AIガバナンス・ゴールに照らして、システムの運用状況を継続的にモニタリングし、課題の発見と改善を図るプロセスが確立されているかを確認します。また、ゴール自体の妥当性や、達成に向けた取り組みの有効性についても検討が必要です。特に、負のインパクトが顕在化していないか、ステークホルダーの期待に応えられているかなど、社会的な観点からの評価が重要となります。

「環境・リスクの再分析」では、AIシステムを取り巻く環境の変化やリスクの変容を定期的に分析し、それに応じてAIシステムの設計や運用を見直すことが求められています。

具体的には、AIシステムが社会に与える影響や、ステークホルダーの期待の変化などを継続的にモニタリングし、分析することが重要です。また、技術の進歩によってAIシステムに新たな機能が追加された場合なども、再分析の対象となります。

再分析を行う際には、幅広い視点からリスクを洗い出し、それらを適切に評価することが求められます。特に、AIシステムが予期せぬ判断を下したり、不適切な結果を生成したりするリスクについては、慎重に検討する必要があります。

AIガバナンスとは、AIシステムの開発・運用に伴うリスクを管理し、AIを安全かつ適切に利用するための枠組みです。著作権侵害、機密情報漏洩、誤情報の利用、差別的出力などのリスクを想定し、対策を講じる必要があります。

企業がAIガバナンスを実践するには、環境・リスク分析、ゴール設定、システムデザイン、運用、評価、環境・リスクの再分析といった一連のプロセスを踏むことが重要です。AIガバナンスの確立は、AIの社会実装を進める上で不可欠な要素であり、企業には適切な取り組みが求められています。

業務の課題解決に繋がる最新DX・情報をお届けいたします。

メールマガジンの配信をご希望の方は、下記フォームよりご登録ください。登録無料です。

AI製品・ソリューションの掲載を

希望される企業様はこちら