生成AI

最終更新日:2025/03/05

rinna 日本語特化LLMモデル公開

rinna 日本語特化LLMモデル公開

rinnaは、Qwen2.5とDeepSeek R1を利用した日本語大規模言語モデル「Qwen2.5 Bakeneko 32B」シリーズをApache-2.0 Licenseで公開しました。

このニュースのポイント

rinna株式会社は、日本語に特化した大規模言語モデル「Qwen2.5 Bakeneko 32B」シリーズを、Qwen2.5とDeepSeek R1を用いて開発し、Apache-2.0 Licenseで公開しました。このモデルは、DeepSeek R1の出力を用いて蒸留学習を行ない。日本語の思考能力を効率的に強化しています。

開発されたモデルには、アリババ社のQwen2.5を基にしたバージョン「Qwen2.5 Bakeneko 32B」、「Qwen2.5 Bakeneko 32B Instruct」、および「DeepSeek R1 Distill Qwen2.5 Bakeneko 32B」が含まれ、日本のAIの研究・開発に寄与することを目指しています。

「Qwen2.5 Bakeneko 32B」シリーズは、複数のモデルサイズや特化機能を持つQwen2.5シリーズの一部で、特に32Bモデルは性能とサイズのバランスが良いです。このモデルでは、日本語と英語のデータを使って継続的な事前学習が行われ、高性能な日本語LLMを目指します。

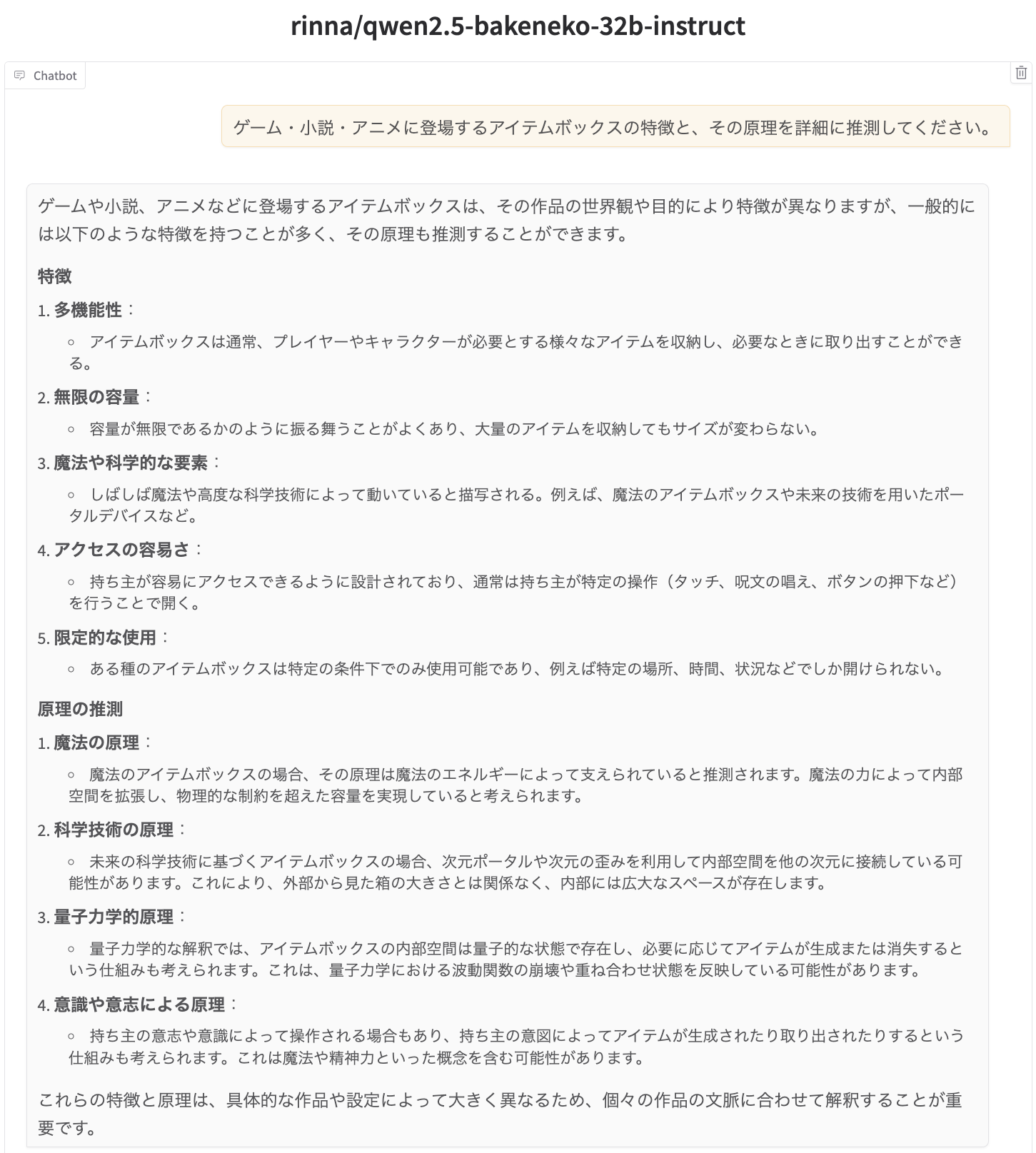

「Qwen2.5 Bakeneko 32B」は、他のモデルとの統合により高い日本語性能を持つモデルの作成が期待されています。また「Qwen2.5 Bakeneko 32B Instruct」は、指示学習を加えたモデルで、対話形式での利用に適しています。

DeepSeek社の新モデル「DeepSeek R1」が高い思考能力で注目されていますが、モデルサイズが大きいため扱いが難しく、知識蒸留を用いて「DeepSeek R1 Distill Qwen 32B」が開発されましたが、日本語性能が低いという課題がありました。

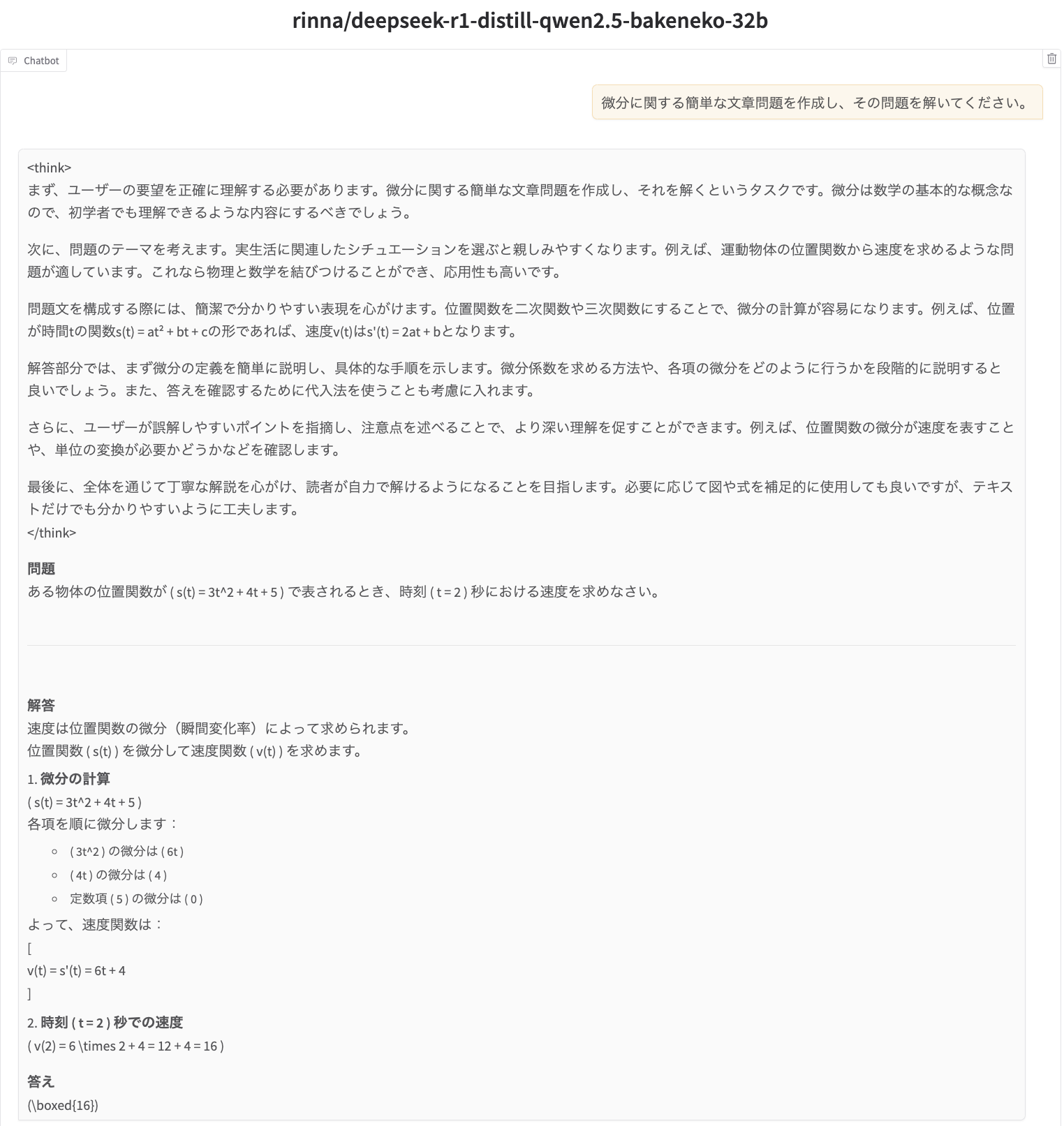

そこで「Qwen2.5 Bakeneko 32B」をベースに、DeepSeek R1の思考過程を含む1,200件のテキストデータを使った蒸留学習で「DeepSeek R1 Distill Qwen2.5 Bakeneko 32B」が開発され、日本語の思考能力を向上させることに成功しました。

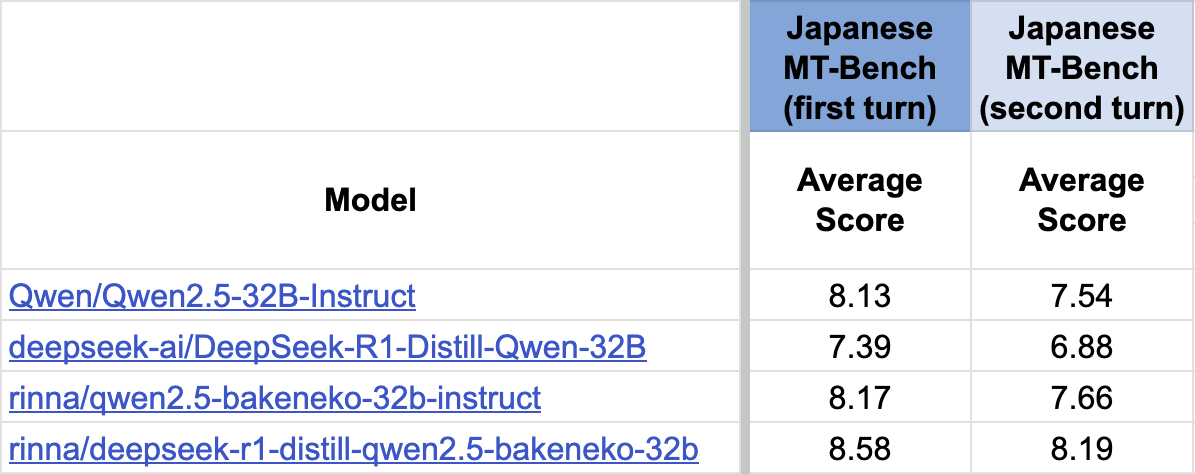

評価結果では、このモデルが前モデルより大きくスコアを改善しています。

rinnaは「今後も、AIの社会実装を進めるために研究開発を続け、研究成果の公開や製品への導入を行っていきます」とコメントしています。

出典:PR TIMES

業務の課題解決に繋がる最新DX・情報をお届けいたします。

メールマガジンの配信をご希望の方は、下記フォームよりご登録ください。登録無料です。

AI製品・ソリューションの掲載を

希望される企業様はこちら