生成AI

最終更新日:2024/04/05

NEC、国内最大AI研究用スパコン

NEC、国内最大AI研究用スパコン

NEC(日本電気株式会社)は、拡大するAI研究のニーズに応えるため、AI研究用スーパーコンピュータ(以下、AIスパコン)の構築を開始しました。国内企業では最大規模のAIスパコンが目指すのは、社会価値を共創するAI研究のセンター・オブ・エクセレンスの実現です。

既に一部のシステムは稼働を開始し、順次拡張するフェーズに移っている状況の中で、NECの技術開発責任者 北野 貴稔氏とインフラの中核を担うNVIDIA社とDDN社のエキスパートにお話しをお伺いしました。

<話し手>

・日本電気株式会社

デジタルテクノロジー開発研究所 シニアAIプラットフォームアーキテクト

北野 貴稔氏

・株式会社データダイレクト・ネットワークス・ジャパン

パフォーマンスエンジニアリングマネジャー プリンシパルエンジニア

井原 修一氏

・エヌビディア合同会社

シニア ソリューション アーキテクト ソリューションアーキテクチャ&エンジニアリング

佐々木 邦暢氏

――現在におけるNECの事業領域について教えてください。

――北野氏

NECでは2025中期経営計画(以下、2025中計)にて、テクノロジーの強みを顧客価値に転換し、グローバル成長と国内事業のトランスフォーメーションを加速することにより、2025年度の売上収益3兆5千億円を目指しています。

具体的な成長事業としては、デジタルガバメント/デジタルファイナンスと、グローバル5G、コアDX、そして次の柱となるヘルスケア・ライフサイエンスなどの4つを策定しています。また、持続可能な社会の実現に向けたカーボンニュートラルなどを始めとしたグリーントランスフォーメーションにも全社を挙げて取り組んでいます。

これからは今まで以上に「社会価値創造型企業」として、社会や企業変革のデジタルトランスフォーメーション(DX)とグリーントランスフォーメーション(GX)を推進し、注力事業領域で展開していく。それがNECが目標としているところです。

現在の世界を見てみると、デジタル革命が進展し、社会のDX/GXが急激に加速している状況にあります。このデジタル革命の中心となる技術は何かというと、間違いなくAIです。NECとしても、2025中計、さらには次期の中期経営計画までをも見据え、AIスパコンをフル活用し、注力する領域に競争力のあるAIを多数展開し、社会価値の創造を行っていきたいと考えています。

NECには、AI技術の開発で半世紀にも及ぶ実績があり、これまで画像・映像認識、言語・意味理解、データ分析、予測予兆検知、最適計画・制御など、主要なAIの領域において世界最高水準のAIを数多く生み出してきました。

現在、AI研究者数は数百名にも上り、生体認証技術では顔認証と光彩認証で世界No.1(注1、注2)、機械学習における難関学会の論文採択ランキングは企業では世界8位にランクインしています(2022年7月現在)。この世界有数のAIの研究開発能力を活かして、社会全体のDX/GXを推進することで、社会に貢献していきたいと考えています。

(注1)米国国立標準技術研究所(NIST)による顔認証ベンチマークテストでこれまでにNo.1を複数回獲得

<URL>https://jpn.nec.com/biometrics/face/history.html

(注2)NEC 、顔認証に続き虹彩認証でも米国国立機関による精度評価で第 1 位を獲得し、 2 冠を達成

URL https://jpn.nec.com/press/202109/20210902_01.html

※ NISTによる評価結果は米国政府による特定のシステム、製品、サービス、企業を推奨するものではありません

AI研究用スーパーコンピュータのマシン室完成予想図

――AIスパコンを開発された経緯についてお聞かせください。

――北野氏

なぜ今のタイミングでAIスパコンの開発を開始したのか。そこには社会的な観点と技術的な観点、この2点からなる背景がありました。

第一の理由は、社会からの要請に応える。さまざまな分野に生じている高度な社会課題を迅速に解決するためです。AIへのニーズは拡大の一途を辿っており、ありとあらゆる事業領域に適用範囲が拡大しています。

また、今の世の中はVUCA(予測不能の時代、注3)となって来ており、社会の変化も急激に進んでいる状態です。従って、変化し続ける社会を捉え続け、高度な社会課題を迅速に解決するためには、多数かつ多様なAIを生み出すだけの計算能力が必要となります。NECが社会価値創造型企業として社会全体に貢献していくためには、このAIスパコンの開発は必然であったということです。

注3 VUCA:Volatility(変動性)、Uncertainty(不確実性)、Complextity(複雑性)、Ambiguity(曖昧性)

第二の理由は、NECが先進AIを創れる企業であり続けるためです。例えば、最近の大規模なAIでは学習にGPU1基で355年もの時間を要するものも登場しています。これに対応できるものがあるとしたらAIスパコンしかありません。

AIの開発ではアルゴリズムやデータなどを変えながら、数千回もの試行錯誤を繰り返す必要があり、この試行錯誤のサイクルをいかに短縮するかが、AIの競争力に直結するのです。

言うならば、AIスパコンがなければ先進AIを創り続けることはできません。つまり、計算能力こそがAIの時代における競争力の源泉であるということです。AIの世界における世界有数の技術開発能力をAIスパコン開発によって、さらに強化することで、社会に価値を届けていきたいと考えています。

――AIスパコンの内部の技術について教えてください。

――北野氏

今回の開発にあたっては、先進サーバーのコンピュータアーキテクチャと先端のネットワークアーキテクチャから構成される「計算機基盤」、Kubernetesを中心とした先端の「ソフトウェア基盤」とを高次元で融合しています。

計算機基盤にはNVIDIAのハイエンドGPUが928基。これを活用し、高速でのAIの学習を行うことが可能になっています。また、GPUサーバーと各種高速スイッチを、Spine/Leaf型のネットワークアーキテクチャにてEnd-to-Endで統合することにより、リアルタイム・大容量の通信を実現しています。各GPUサーバーからはDDNの16PB超の超大規模ストレージへの接続が可能で、学習で必要となる大量データを高速に取得し活用することができます。

ソフトウェア基盤に関しては、複雑な環境を構築することなく先端のAIの学習を行えるようにするため、Kubernetesをソフトウェアの中核に据えた分散学習環境を独自開発しています。これにより、利用する研究者は最新の深層学習フレームワークのコンテナを用いて、複雑な環境構築をすることなく容易に分散学習を行うことができます。

さらにKubernetesのジョブスケジューラを独自に開発しており、ネットワークトポロジなどの物理構成に最適化した効率的なスケジューリングをすることによって、より多くの研究者が利用できるような環境を提供しています。

MPI/NCCLなどの通信ライブラリやOSなどもNEC独自の最適化を行うことで、RoCEv2を用いたGPUDirect RDMAで高速な分散学習を行うことが可能となっています。

これらの仕組みにより、高性能かつ利便性の高い、世界でも有数のAIスパコンを実現しました。

――NVIDIAのGPU/スイッチなどを採用した理由を教えてください。

――北野氏

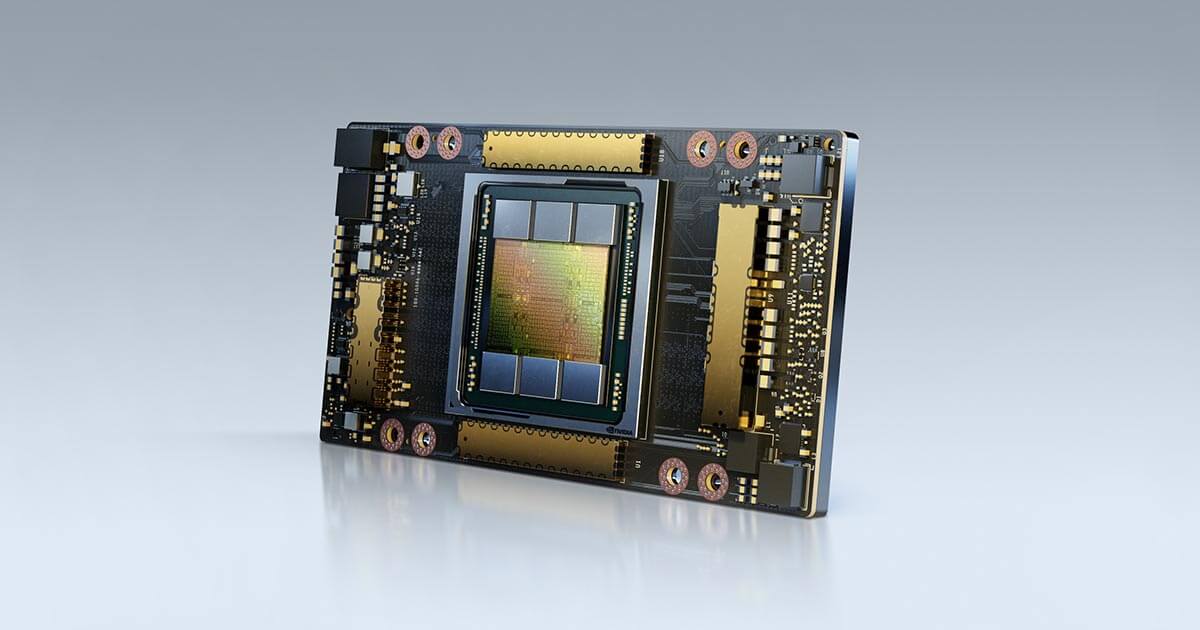

このAIスパコンでは、GPUとしてNVIDIA A100 Tensor コア 80GB GPU(以下、NVIDIA A100)、スイッチにはNVIDIA Spectrum SN3700 (200GbE)、NICとしてNVIDIA Connect-X 6 (200GbE)を採用しています。AIの開発では、大規模な分散学習を高速に行える必要があり、そのための鍵となるのがNVIDIAのGPUとスイッチ・NICです。

GPUにNVIDIA A100を採用したのは演算性能が高いからというのが最大の理由ですが、それだけではありません。

深層学習では多くの領域においてメモリ律速であり、GPUメモリのメモリ帯域が広くなければ、演算性能が高くてもその性能を活かすことはできません。

NVIDIA A100ではメモリ帯域が2TB/sec超と広いだけでなく、さらにTF32とBF16といったメモリ消費量を押さえながらも精度を落とさない新たな方式が導入されていることから、メモリ律速であることを緩和することができ、よりNVIDIA A100の高い演算性能を活かせます。

NECが取り組んでいる画像・映像認識など、画像に関連する深層学習の研究開発では、よりメモリ律速となります。この問題を解決してくれるのがNVIDIA A100からサポートされたTF32・BF16です。高い演算能力を活かした研究開発の効率化が可能であること、NVIDIAのGPUを採用した理由はそこにあります。

スイッチとNICについては、NVIDIAの製品を採用しました。NVIDIAの製品はサーバーからスイッチまでEnd-to-EndでのRoCEv2の通信をサポートしていて、200GbEの限界近くまで性能が出せたことが決め手となりました。

分散深層学習では、パラメータ交換を行うために、学習を行うごとに並列計算結果を集約するAllReduceの処理を行う必要があり、GPUサーバー間での通信が発生します。最近の大規模なAIモデルでは、その通信を高速化し、低レイテンシ(遅延)かつ広帯域での通信ができなければ、GPUサーバーを並べても分散効率は上がりません。従って、RoCE v2を用いたGPUDirect RDMAが行えることが重要であり、End-to-Endで全てのスイッチ・サーバー間を繋ぐことが可能なNVIDIAの製品を採用しました。

また、スイッチの選定にあたっては、スイッチOSであるNVIDIA Cumulus Linuxが、Linuxとして扱うことができ、スイッチに対する自動化やカスタムの監視機能を容易に追加することができた、というのも採用の理由となりました。RoCEv2のような特殊なかたちで通信を行う場合、カスタムでの監視を行いたいという場面が多くあるためです。これに対してLinuxならば、どのような項目でも容易に監視機能の追加が可能です。

――佐々木氏

北野様のご指摘の通り、最先端のAI研究においては大規模な分散学習が必須であり、そのためのAIスパコンに我々のGPUとネットワーク製品を採用いただけたことは大変光栄です。

NVIDIA A100 GPUでさらに進化したTensorコアの混合精度演算や、NVLinkによる高速なGPU間接続、ConnectX-6 スマートNICとSN3700 スイッチによる低遅延、広帯域のノード間通信。NVIDIAは、これらのハードウェアのみならず、その性能を最大限に引き出すためのソフトウェアにも力を入れ、TensorFlowやPyTorch等のフレームワークと組み合わせた形で、NVIDIA GPU Cloud (NGC) のコンテナイメージとして広く提供しています。

これらのハードウェアとソフトウェアが、NEC様のAI研究をさらに加速できるよう、今後ともお手伝いさせていただきたく思っております。

――DDNのストレージの採用についてお聞かせください。

――北野氏

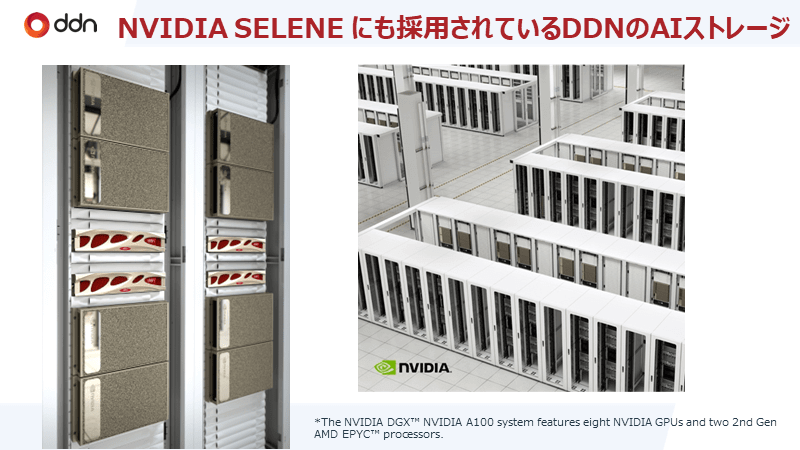

DDNのストレージアプライアンスは、AIの学習に必要となる大規模データを高速・高信頼で利用するための鍵となるコンポーネントです。そんなDDNのストレージアプリアンスを採用した理由は大きく3つあります。

1点目は、Lustreがメタデータ性能とデータ処理性能の両方がスケールアウト可能なアーキテクチャとなっていたからです。

検証環境と大規模なプロダクションの環境では規模がまったく異なるため、プロダクションで扱う16PB超の大規模なファイルシステムを扱うにはスケーラビリティの高さがアーキテクチャによって保障されていることが重要でした。

一般に大規模な分散ファイルシステムでは、そのファイル数の多さからメタデータ性能がボトルネックになることがあります。DDNのストレージでは、メタデータの性能を、Lustre DNEによりディレクトリ配置を工夫すれば、MDT数に応じてリニアに上げることが可能です。

さらに、データの容量やスループットに関しても、OSSのペアを複数用意することによって、リニアに容量・性能を向上させることができます。このようにスケールアップではなくスケールアウトをすることがアーキテクチャとして担保されているということは非常に魅力的でした。

2点目は、分散深層学習で必要となる多様なデータに関するI/Oワークロードにおける高い要求水準を、スループット・IOPS共にクリアできたから、ということが挙げられます。

NECでは、全研究所でAIの研究開発を行っており、画像・映像認識、言語・意味理解、データ分析、予測予兆検知、最適計画・制御などの多様なAIの研究を行っています。従って、画像、映像、テキストなどの多様かつ大規模なI/Oのワークロードを扱える必要があるのですが、DDNのストレージは、どのI/Oのワークロードもスループット・IOPSをクリアしていました。

3点目は研究者のコード移行が不要だったからです。DDNの製品はファイルシステムとして利用ができ、AI研究者が既存コードの変更をする必要がありません。NECのAI研究者数は数百名と非常に多く、多くの研究者は、自身が保有するGPUサーバー上のファイルシステム上のデータにアクセスするプログラムを書いています。従って、AI研究者の既存のコードがそのまま動くというのは、AIスパコンを利用してもらうためには非常に重要な要件でした。

DDNのファイルシステムはLinuxから普通にファイルシステムとしてマウントすることができるため、AI研究者はDDNのストレージであることを意識することなくシームレスに移行することができる。これが大きな魅力となりました。

以上の理由を総合的に勘案し、1年間の技術検証期間を挟んで、国内企業で最大規模のAIスパコンを開発するにはDDNのストレージアプライアンスが最適である、という結論に至ったというわけです。

――井原氏

DDNでは20年以上、HPC(ハイパフォーマンスコンピューティング)ストレージのマーケットリーダーとして数多くのシステムを導入してきました。ここ数年、その実績はAIシステムのストレージとしても認められ、大規模AIシステムではDDNのストレージがデファクトスタンダートになりつつあります。

この度NEC様に採用されたDDN AI400XはNVIDIA社に設置されているAIスーパーコンピュータSeleneにも大規模に採用されており、私自身もその導入およびベンチマークに携わりました。しかしながら、今回のNEC様のシステムはこれまでのものとは異なり、Kubernetesで管理されたコンテナ経由のストレージアクセス、ネットワークとしてRoCEv2の全面採用、またユーザの方々にストレージをストレスなく透過的に効率よく高い性能で利用して頂くことが課題としてあり、これは弊社としても新たな挑戦でした。

NEC様が何を求めているのか、どのようなビジョンを描かれているのか、技術的なことはもちろん、想定されるケースなど、さまざまな課題についてディスカッションして製品の提案や解決策の提示をいたしました。

DDNの製品はある意味とてもシンプルなのですが、それだけにお客様の目的にあった活用をいただくためには弊社からの技術提案が非常に重要です。その点、今回は非常にチャレンジングではありながらも、これまで長年培ってきた経験やナレッジをフルに活かすことができたと自負しています。近年パートナーシップを強化しているNVIDIA様とも既に数多くのお客様への導入でご一緒している実績もあり、強固な信頼関係の下NEC様のAIスーパーコンピュータプロジェクトに携われたことを嬉しく思っています。

今回のAIスーパーコンピュータは、AIに関わるすべての技術者や研究者にとって大きなリファレンスになり得ると考えており、今後の運用を見守っていくのが非常に楽しみです。

――AIスパコンの活用方法について教えてください。

――北野氏

NECは全研究所でAIの技術開発を行っており、その領域は画像・映像認識、言語・意味理解、データ分析、予測予兆検知、最適計画・制御など、多岐に及んでいます。これらの領域で、自社の数百名のAI研究者がAIスパコンを活用しています。

AIの適用領域は多様化の一途をたどっており、AIが全ての企業において不可欠なものとなっていくことは間違いありません。今後、AIというテクノロジーは、業種内での革新をもたらすだけではなく、業種の垣根を越えて、ありとあらゆる事業を再定義するだけの可能性を秘めているとすら言えます。

こうした状況ですから、近年のAIニーズの急拡大と深層学習技術の発展に伴う要求演算量の増大を考えると、AIスパコンは企業の競争力を支えるために必須のものであると考えています。

――今後のビジョンについてお聞かせください。

――北野氏

私はこのAIスパコンをフル活用することで、NECを世界に誇れる日本を代表するAIのテックカンパニーへと導き、社会に広く革新的な価値を提供できる社会価値創造型企業として知られる存在にしたいと思っています。

もちろん、世の中を変えるようなイノベーションというものはNECだけで生み出せるものではありません。NECが目指しているのは社会価値を共創するAIのセンター・オブ・エクセレンスです。国内企業で最高の環境にそれを活用したいというお客様と優れた研究者が集い、新たな社会価値を共創する。このようなAIのセンター・オブ・エクセレンスをNECが担うことによって、イノベーションを生み出し、社会価値の創造を加速していきたい。それがビジョンです。

NECは国内企業で最大規模のAIスパコンを構築することによって、国内企業で最高のAIの研究開発環境を保有することとなります。これはお客様やパートナーの皆様、研究者の皆様にも大きな意味があると考えています。

AIは、技術の可能性から考えれば、コンピュータの発明に次ぐほどの大発明です。広く普及しつつありますが、AIがもたらす革命はまだ始まったばかりであると言えます。AIスパコンをフル活用することで、世界に誇れる先進AIを多数生み出し、広く社会にイノベーションを届けていきたいと思っています

今回ご紹介した通り、NECでは多種多様な事業領域でAIの技術開発を行っており、すでに数百名の全AI研究者がAIスパコンを利用し、先進AIの技術開発を進めています。AIの共同研究開発やAIスパコンの活用などについてご質問やお問い合わせがあれば、ぜひご相談ください。

構築が開始されたNECのAIスパコンは、近く480PFLPOSのシステムが加えられ、AIに特化した国内企業で最高の研究開発環境です。より高度化が求められるAIの迅速な開発に役立てられることが期待されています。

業務の課題解決に繋がる最新DX・情報をお届けいたします。

メールマガジンの配信をご希望の方は、下記フォームよりご登録ください。登録無料です。

AI製品・ソリューションの掲載を

希望される企業様はこちら