生成AI

最終更新日:2026/02/03

gpt-ossとは?

gpt-ossとは?

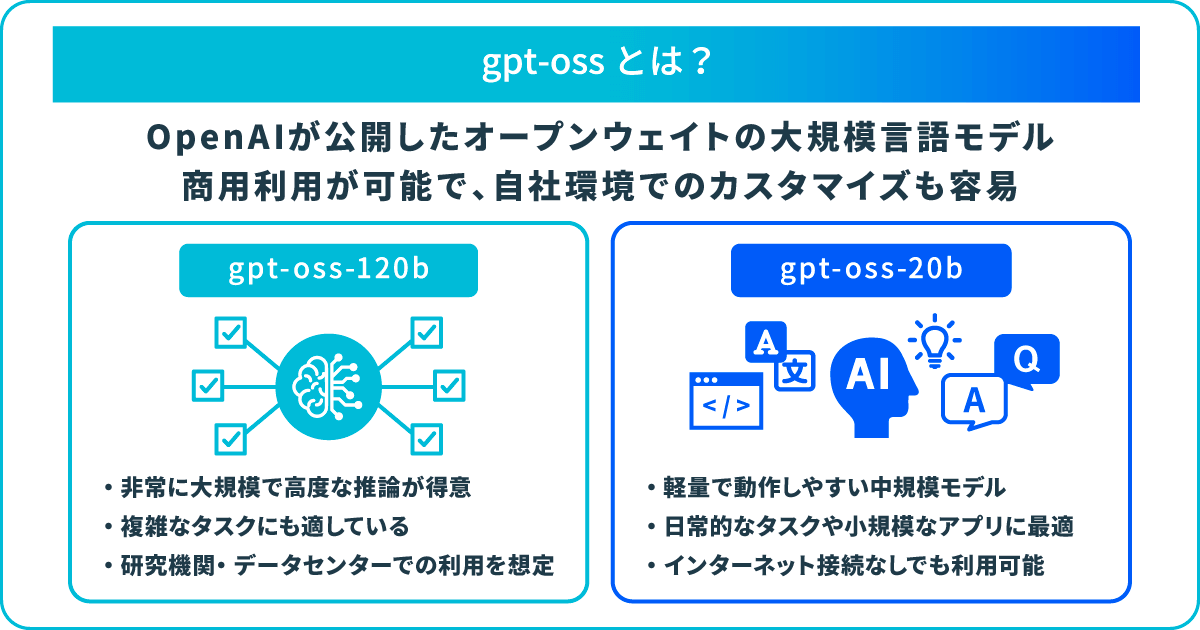

OpenAI は2025年8月5日(アメリカ現地時間)、新しいモデル「gpt-oss」をリリースしました。重み(パラメータ)を公開したオープンウェイトモデルで、「gpt-oss-120b」と「gpt-oss-20b」の2つのモデルが展開されています。

本記事では、gpt-oss の特徴やライセンス、料金、使い方などについて詳しく解説します。低コストかつ高性能な最新モデル「gpt-oss」の利点を知り、生成AIを有効活用するためにぜひお役立てください。

gpt-oss は、OpenAI の最新LLM(大規模言語モデル)です。シリーズには、「gpt-oss-120b」と「gpt-oss-20b」の2モデルがあり、いずれも重み(パラメータ)が公開されていることからオープンウェイトモデルとも呼ばれています。

また、Apache 2.0(オープンソース)ライセンスのもとで、自由にカスタマイズ可能です。

Meta をはじめとする各企業が、高性能なOSS(オープンソース)LLMを次々と無償公開しており、世界中の企業が本格的に取り入れ始めています。その流れを受けて、OpenAI でも強力なOSSモデルの需要に応えるために、gpt-oss の開発に至りました。

gpt-oss の各モデルの特徴は、以下の通りです。

| モデル | パラメータ数 | 性能レベル |

|---|---|---|

| gpt-oss-120b | 1,170億パラメータ | OpenAI o4-mini 相当 |

| gpt-oss-20b | 210億パラメータ | OpenAI o3-mini 相当 |

gpt-oss では、メモリフットプリントを大幅に削減することに成功しており、「gpt-oss-120b」は単一の80GB GPUメモリで推論が可能です。プロダクション環境や高度な推論などに適しています。

一方、「gpt-oss-20b」はさらに軽量化されており、16GB程度のメモリでもスムーズに実行できます。実際に、MacBook(RAM 32GB)で動作したという報告もあり、効率性の高さが実証されています。

gpt-oss の主な特徴として、以下が挙げられます。

各項目について詳しく解説します。

gpt-oss は、オープンソースライセンス「Apache 2.0」で提供されている高性能モデルです。自由にカスタマイズや製品組み込みを行える上、商用利用にも対応しており、幅広い活用が見込まれます。

gpt-oss は、クラウド経由だけでなく、自分のPCや社内サーバーに直接導入することが可能です。特に、軽量な gpt-oss-20b は、GPUを備えた一般的なPCでも実行でき、インターネット接続がない環境でも利用できます。

外部にデータを送らずに処理できるため、顧客情報や社内機密など秘匿性の高いデータも安心して扱えるでしょう。

gpt-oss は、多様な環境での推論やタスク実行の効率性を含め、推論効率や操作性を重視しており、最先端の事前学習および事後学習手法を利用しています。

各モデルは、MoE(mixture-of-experts)を活用し、入力の処理に必要なパラメータ数を抑制しています。「gpt-oss-120b」モデルでは、トークンごとに51億個のパラメータを、「gpt-oss-20b」では36億個のパラメータを有効化します。

また、モデルは「ChatGPT o4-mini」で使われるのと同様の教師ありファインチューニングと、計算コストの高い RL ステージを含むプロセスで事後学習されています。

gpt-oss は、安全面での学習に最先端のアプローチを利用しています。特に、オープンウェイトモデルは、悪意ある目的でモデルがファインチューニングされるリスクが高まります。

対策として、OpenAI は生物学とサイバーセキュリティに関する専門的なデータに基づき、モデルを微調整しました。各ドメインごとに、ドメイン固有の非拒否(non-refusal)バージョンを作成することでリスクを直接評価しています。

また、事前学習では、化学・生物・放射線・核(CBRN)に関連する特定の有害データを除外しました。事後学習では、慎重なアライメントと指示階層を用いて、モデルに安全でないプロンプトを拒否し、プロンプトインジェクションを防御するように学習しています。

gpt-oss の各種ベンチマークを以下の表にまとめました。

| モデル | 競技プログラミング (Elo) |

Humanity’s Last Exam(%) | ヘルスベンチ (%) |

AIME 2025 (%) |

MMLU (%) |

ツール呼び出し (%) |

|---|---|---|---|---|---|---|

| gpt-oss-120b | 2622 | 19.0 | 30.0 | 97.9 | 90.0 | 67.8 |

| gpt-oss-20b | 2516 | 17.3 | 10.8 | 98.7 | 85.3 | 54.8 |

| o3 | 2706 | 24.9 | 31.6 | 98.4 | 93.4 | 70.4 |

| o4-mini | 2719 | 17.7 | 17.5 | 99.5 | 93.0 | 65.6 |

| o3-mini | 2073 | 13.4 | 4.0 | 86.5 | 87.0 | – |

gpt-oss-120b は、特に多くの項目で o4-mini に匹敵、あるいはそれを超えるスコアを示しています。例えば、Humanity’s Last Exam(多分野にわたる専門家レベルの試験)やヘルスベンチ(難易度の高い健康会話)、ツール呼び出しにおいて、gpt-oss-120b は o4-mini を上回っています。

また、MMLU(一般的な学術知識)やAIME 2025(競技数学)でも o4-mini に迫る性能を打ち出しました。加えて、gpt-oss-20b は規模が小さいにもかかわらず、o3‑mini に匹敵または凌駕する性能を示しています。

gpt-oss は「Apache 2.0」ライセンスのもとで公開されているため、カスタマイズや商用利用、再配布が認められています。ただし、利用の際には、安全性と倫理的配慮のためにOpenAIの利用規約を確認し、準拠することが重要です。

また、gpt-oss のモデルの重み(ウェイト)は無料でダウンロード可能で、オンプレミスや自社クラウド環境での利用には追加料金はかかりません。ただし、API 経由で利用する場合、各プロバイダーの課金体系に従って料金が発生する可能性があります。

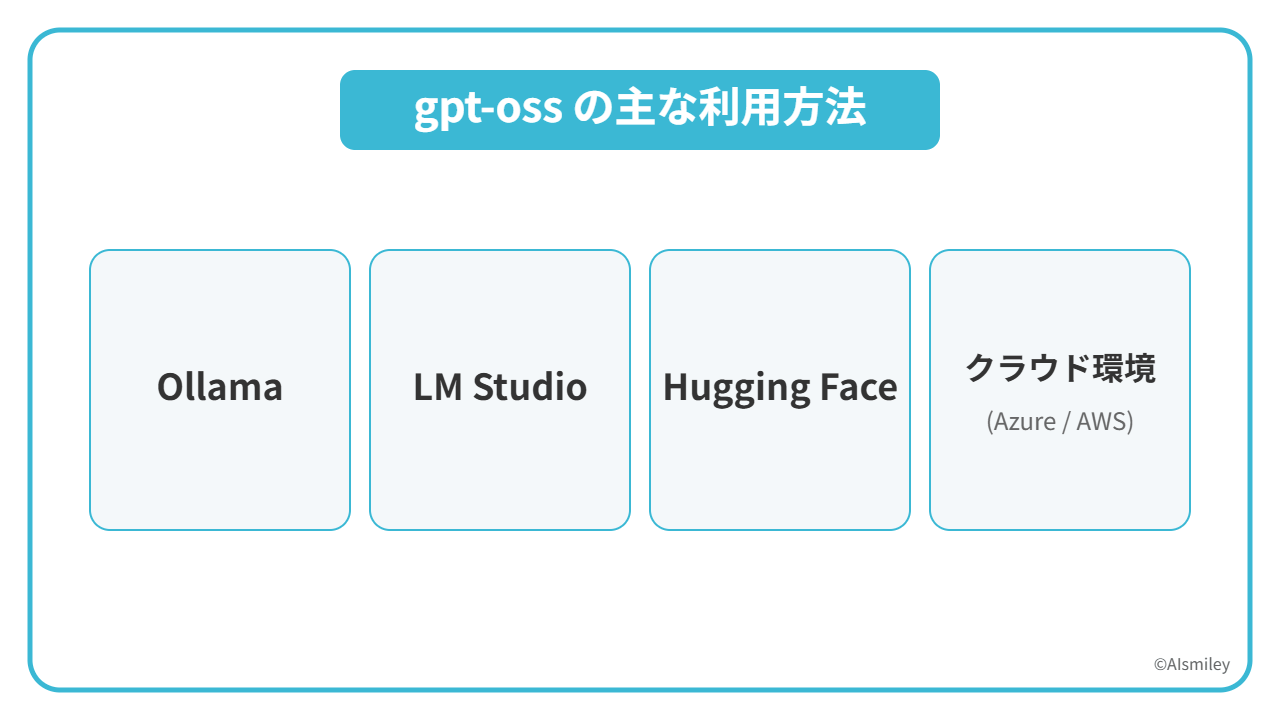

gpt-oss を利用する方法は複数あります。ここでは、アプリケーションの「Ollama」「LM Studio」に加え、Hugging Face、クラウド経由での使い方を紹介します。

Ollama は、ローカル環境で LLM を手軽に実行できるツールで、OpenAI と提携しています。以下の手順でインストールし、gpt-oss を利用可能です。

LMStudio は、デスクトップ用ローカルLLM実行環境です。プログラミング知識不要で簡単にモデルを扱えます。以下の手順で設定しましょう。

gpt-oss は、Hugging Face から使うこともできます。推論プロバイダー上で OpenAI 互換のAPIを経由します。おおまかな利用手順は、以下の通りです。

gpt-oss を Azure や AWS といった主要クラウドサービスから利用することで、初期投資を抑えつつスケーラブルにモデルを運用できます。

Azureでの使い方は以下の通りです。

AWSでの利用方法は、以下を参考にしてください。

OSSとして公開されるLLM には、gpt-oss 以外にも多数登場しています。ここでは、gpt-oss モデルとの比較のために、代表的なOSS LLMについて解説します。

Meta 社が2023年にリリースした「Llama 2」とそのシリーズモデルは、コミュニティライセンスモデルとして広く普及しています。Llama 2 は一部制約付きの独自ライセンスで公開されており、商用利用も許可されています。

2025年の改良版「Llama 3.1」は、依然として OSS LLM の代表格的な存在です。規模は、gpt-oss-120b の方が大きいですが、MoE 構造により推論コストは抑えられている点が特徴です。

Falcon は、UAE主導で開発が進められているAIモデルです。一般的なパソコンで動作するコンパクトさながら、本格的な大規模AIと同等の性能を発揮します。2023年に公開された「Falcon 40B」は、gpt-oss と同じ「Apache 2.0」ライセンスで公開されており、以降の世代も商用利用が可能なオープンウェイトモデルとして提供されています。

タスク実行効率においては、gpt-oss-120b が優位ですが、Falcon シリーズの長文処理能力も高い評価を得ています。

Google Deepmind 発の「Gemma」は、同社のLLMである Gemini の技術を応用し、軽量化されたオープンウェイトモデルです。2025年8月に登場した最新の「Gemma 3 270M」モデルは、マルチモーダル対応で、デバイス上での省電力性に優れています。

また、Gemma は責任ある商用利用が許可されていますが、Google 独自の利用規約による制限が付く可能性があります。

gpt-oss の導入事例と活用シーンとして、以下が挙げられます。

セキュリティが確保された社内インフラなどで gpt-oss を導入することで、機密情報の安全性や法令遵守を満たしつつ、AIによる生産性の向上やリスクの軽減といった効果が期待できます。

OpenAI 社の最新AIモデル「gpt-oss」は、高性能なオープンウェイトモデルです。モデルの重み(パラメータ)が公開されており、商用利用やカスタマイズが許可されています。また、ローカル環境で実行できるため、セキュリティを重視する企業にとって大きなメリットとなります。

他社OSS LLMとの比較を踏まえて、自社の活用シーンに適した導入を検討することが重要です。

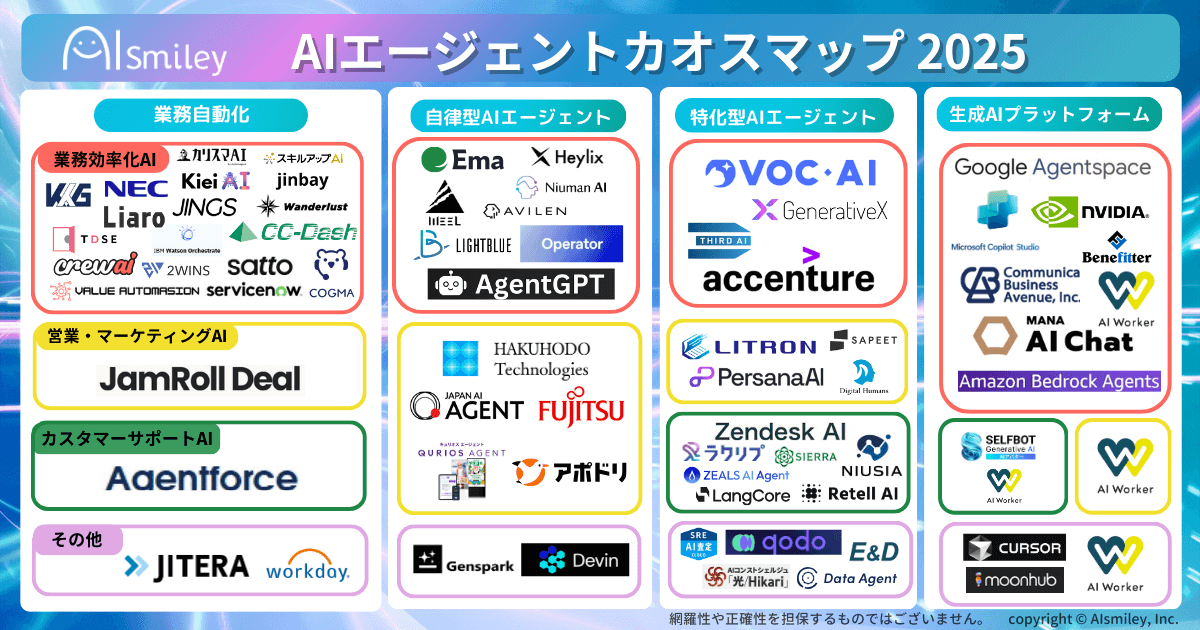

アイスマイリーでは、「AIエージェントのサービス比較と企業一覧」を提供しています。最新のAIサービス動向を把握し、比較検討するために以下よりぜひご活用ください。

gpt-oss はオープンウェイトモデルで、自社環境での利用やカスタマイズが可能です。一方、GPT-4 や GPT-4o はクローズドモデルのため、OpenAIのAPI経由でのみ利用できます。gpt-ossは、APIコストを抑えたい企業やセキュリティ性を重視する環境に適しています。

gpt-oss-120b は、約80GBのGPUメモリが必要です。一方、gpt-oss-20b は、16GB〜32GBのメモリのローカルPCでも対応できる可能性があります。

gpt-oss は、OpenAI の最新技術を活かしつつ、MoE構造により高性能かつ高効率を実現しています。特に、gpt-oss-120bモデルは高度な推論力を発揮でき、軽量版の gpt-oss-20b モデルは軽量さと実用性を兼ね備えています。また、Apache 2.0ライセンスでの提供や外部システムとの連携性も特徴です。

業務の課題解決に繋がる最新DX・情報をお届けいたします。

メールマガジンの配信をご希望の方は、下記フォームよりご登録ください。登録無料です。

AI製品・ソリューションの掲載を

希望される企業様はこちら