生成AI

最終更新日:2024/02/11

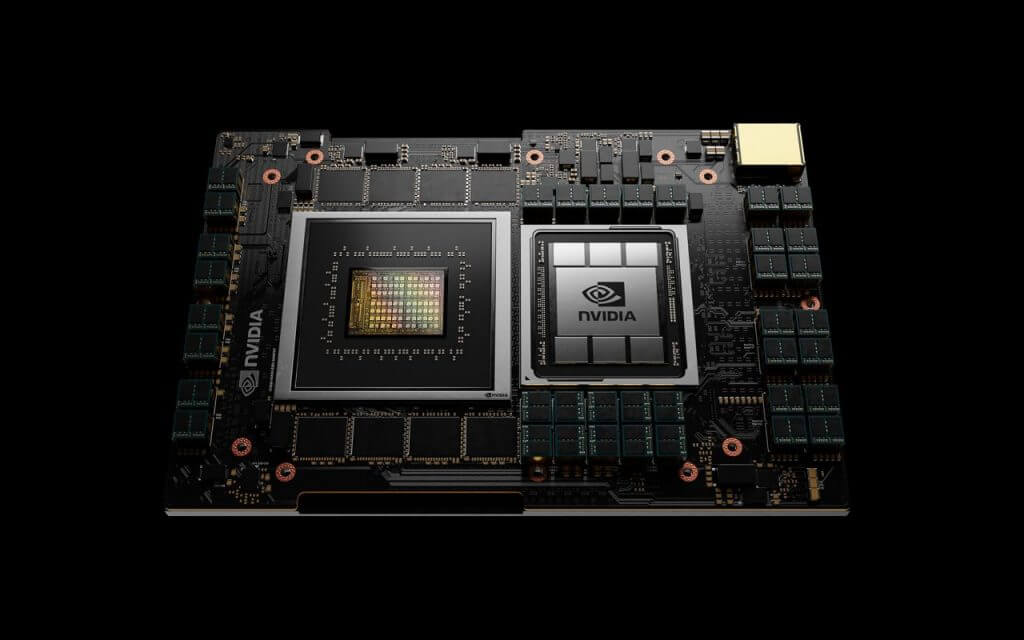

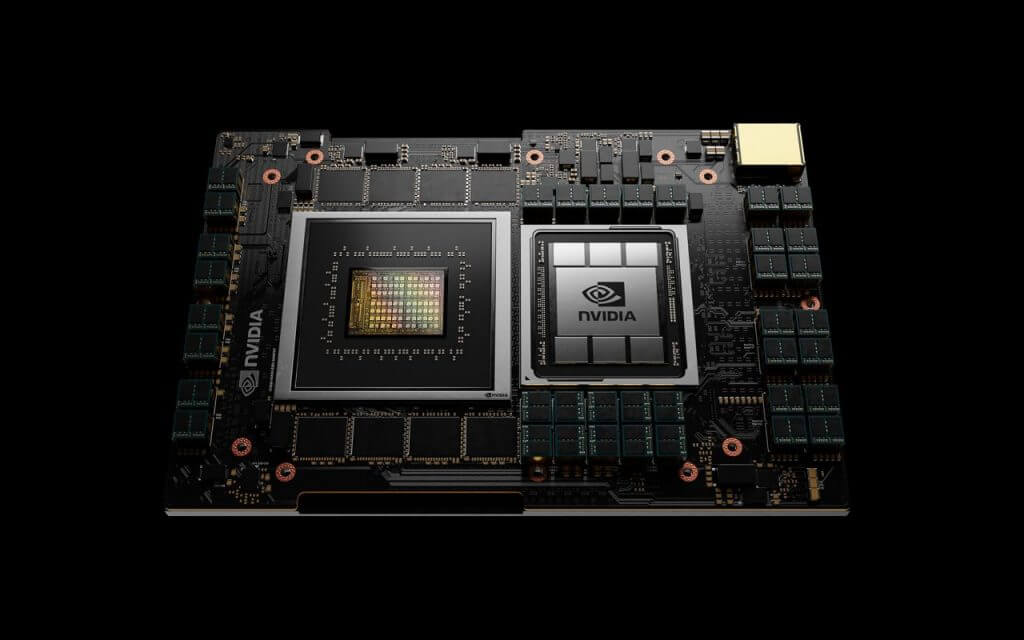

NVIDIAが、ハイパフォーマンスコンピューティングのワークロードにおいて、今日最速のサーバーの 10 倍のパフォーマンスを提供する、初のデータセンターCPUを発表しました。

このAIニュースのポイント

NVIDIAが2021年4月12日、最も複雑なAIとハイパフォーマンスコンピューティング(HPC)のワークロードにおいて、今日の最速のサーバーの10倍のパフォーマンスを提供するArmベースのプロセッサとなる、初のデータセンターCPUを発表しました。

NVIDIA Grace CPU は、超高速のコンピューティングパフォーマンスと大容量メモリの両方を必要とする膨大なデータセットの分析を行う、世界最先端のアプリケーションのコンピューティング要件に対応するように設計されました。

エネルギー効率の高いArm CPUコアと革新的な低消費電力のメモリサブシステムを組み合わせることで、エネルギー効率に優れた設計によって高いパフォーマンスを実現しています。

スイス国立スーパーコンピューティングセンター (CSCS) と米国エネルギー省のロスアラモス国立研究所は、国の科学研究活動を支援するため、Graceを搭載したスーパーコンピューターを構築する計画を発表。

NVIDIA の創業者兼CEO であるジェンスン・フアン氏は、

「最先端のAIとデータサイエンスは、現代のコンピューターアーキテクチャの限界を押し広げており、考えられないような大量のデータ処理が可能になっています。ArmのIPライセンシング モデルを使って、NVIDIAは、巨大なスケールのAIとHPCを想定したCPUである、Graceを開発しました。

GPUとDPUと組み合わせることで、GraceはNVIDIAにとってのコンピューティングの第3の基盤技術となり、AIを発展させるためにデータセンターを再構築できるようになります。NVIDIAは現在、3種類のチップを提供する企業となりました。」

とコメントしています。

ちなみにこのプロセッサは、米国のコンピュータープログラミングの先駆者であるグレース・ホッパーにちなんで名付けられたそうです。

NVIDIAがGrace CPUを導入するのは、データの量とAIモデルのサイズが急激に増加しているからです。

今日の最大のAIモデルには数十億のパラメーターが含まれており、2か月半ごとに倍増しています。

それらをトレーニングするには、システムのボトルネックを解消するためにGPUと緊密に結合できる新しい CPU が必要です。

そこでNVIDIAは、Armのデータセンターアーキテクチャの優れた柔軟性を活用することにより、アクセラレーテッドコンピューティングのためにゼロから設計された CPUであるGraceを開発。

NVIDIAは、新しいサーバークラスのCPUを導入することで、世界で最も差し迫った問題を解決するうえで必要なイノベーションを提供する鍵となるAI、HPCコミュニティにおけるテクノロジの多様性という目標を掲げています。

ArmのCEOであるサイモン・シガース氏は、

「世界で最も広くライセンスされているプロセッサ アーキテクチャとして、Arm は日々驚くほどの新たな方法でイノベーションを推進しています。NVIDIA による Grace データセンター CPU の発表は、Arm のライセンシング モデルがいかに重要な発明を可能にするかを明確に示しています。これは、あらゆる場所の AI 研究者や科学者の素晴らしい仕事をさらにサポートするものです。」

とコメントしています。

CSCSとロスアラモス国立研究所はどちらも、Hewlett Packard Enterpriseによって構築されたGrace搭載のスーパーコンピューターを2023年に稼働させることを計画しています。

CSCSのディレクターであるトーマス・シュルテス教授は、

「NVIDIAの新しいGrace CPUを使用すると、AIテクノロジと従来のスーパーコンピューティングを統合して、計算科学における最も困難な問題のいくつかを解決できます。私たちは、大規模かつ複雑な科学データセットを処理および分析するために、新しいNVIDIA CPUをスイスや世界中のユーザーが利用できるようになることを嬉しく思います。」

とコメントしています。

また、ロスアラモス国立研究所所長のトム・メイソン氏は

「メモリ帯域幅と容量の革新的なバランスにより、この次世代システムは私たちの機関のコンピューティング戦略を形作るでしょう。NVIDIAの新しいGrace CPUのおかげで、忠実度の高い3Dシミュレーションを用いた高度な科学研究や、これまでよりも大規模なデータセットを用いた分析が可能となります。」

とコメントしています。

Graceベースのシステムはx86 CPUで実行される今日の最先端のNVIDIA DGX™ベースのシステムよりも、10 倍速く1兆パラメーターのNLPモデルをトレーニングできます。

このパフォーマンスの根底にあるのは、第4世代のNVIDIA NVLink®相互接続テクノロジーです。

NVIDIA Grace CPUとNVIDIA GPUの間で記録的な900 GB/sの接続を提供し、今日の主要サーバーと比較して30倍高い総帯域幅を実現します。

Graceは、革新的なLPDDR5x メモリサブシステムを採用し、DDR4メモリと比較して2倍の帯域幅と10倍優れたエネルギー効率を実現しています。

さらに、新しいアーキテクチャは、単一のメモリアドレス空間で統合されたキャッシュコヒーレンスを提供し、プログラマビリティを簡素化するためにシステムとHBM GPUメモリを組み合わせます。

NVIDIA Grace CPUは、NVIDIA HPCソフトウェア開発キットとCUDA®およびCUDA-X™ライブラリの完全なスイートによってサポートされています。

2,000を超えるGPUアプリケーションを高速化し、世界で最も重要な課題に取り組んでいる科学者や研究者の発見を加速します。

従来のシステムと比べてかなり高いパフォーマンスを見せるNVIDIA。

新データセンサー「Grace」CPUは、2023 年初頭に発売予定です。

出典:PR TIMES

業務の課題解決に繋がる最新DX・情報をお届けいたします。

メールマガジンの配信をご希望の方は、下記フォームよりご登録ください。登録無料です。

AI製品・ソリューションの掲載を

希望される企業様はこちら