生成AI

最終更新日:2023/12/22

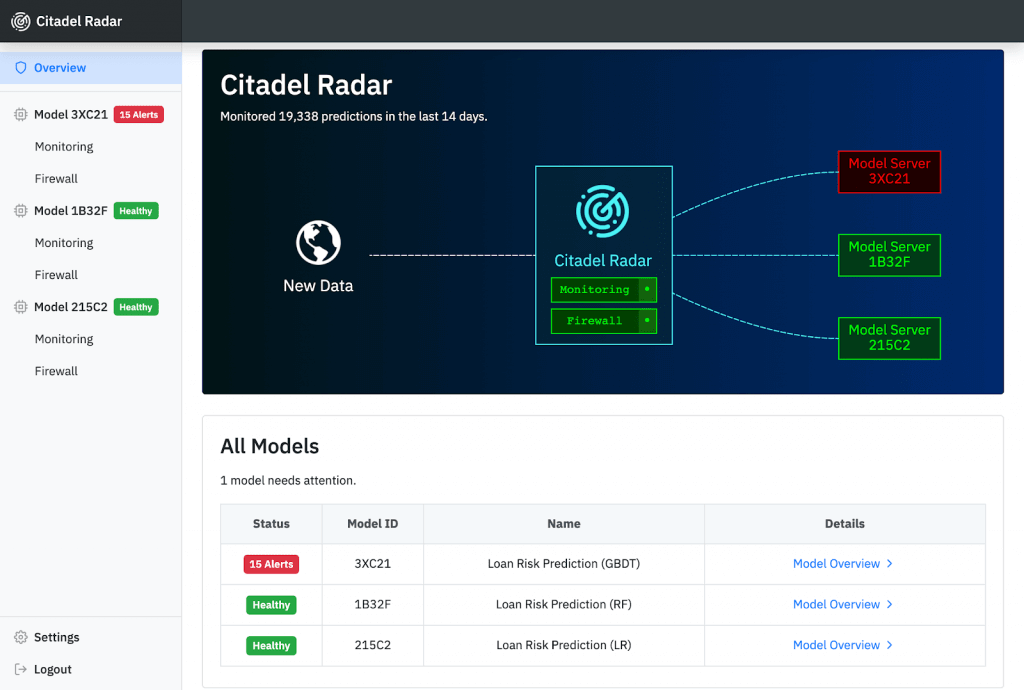

判断過程がブラックボックス化しやすいAIのシステムを自動モニタリングし、異常を検知・ブロック、可視化することで、AI固有のリスクから守る「Citadel Radar」β版の提供が開始されました。AIを改修することなく、さまざまなAIのモデルやアプリケーションに適用可能です。

このニュースのポイント

株式会社Citadel AIは、AIの品質保守を効率的に実現するツール「Citadel Radar」のβ版の利用募集を5月10日より開始します。「Citadel Radar」は、企業がもつAIシステムを自動モニタリングし、異常を検知・ブロック、可視化することで、AI固有のリスクから守ります。AIを改修することなく、さまざまなAIのモデルやアプリケーションに適用可能です。

AIの社会実装が進む中、EUでは2021年4月に人工知能(AI)の利用に関する規制案が発表されるなど、欧州や米国では、AIの説明責任や偏見に対する懸念が高まっています。

AIシステムは、判断過程がブラックボックス化しやすくその透明性を維持することが困難になる場合があります。責任あるAIシステムを構築するために、米グーグルや米マイクロソフトなどのIT(情報技術)企業を中心にAI倫理指針を公開する動きが広がっています。いかにしてAIの品質を担保し、信用を維持し続けることができるかが、これからの事業経営にとって重要な鍵となります。

AIは、常に再学習・更新をし続け、バイアスの排除を行いながら品質や精度を維持していくことが求められる一方で、運用段階で専門家がAIシステムを常時監視することは、コストやリソースの面でも大きな課題がある企業が多いのが現状です。

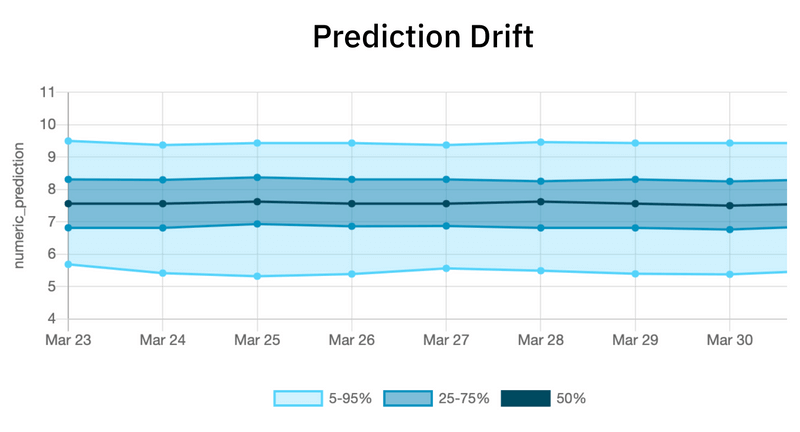

「Citadel Radar」は、AIを自動モニタリングし、学習データと運用データの偏移、AIの予測値の経年変化、バージョン入れ替え等に伴う予測値の変動等をリアルタイムで検知します。「AIへの入力データが、突如あるいは徐々に偏移したことに気づくのが遅れた」「学習時と比べ、運用時にAIのパフォーマンスが思わぬ形で低下してしまう」といった悩みを解決します。

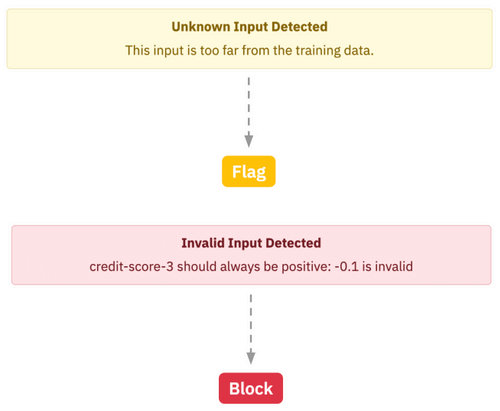

AIにとって見覚えのない異常値を、意識せずにAIに投入してしまった際など、ファイアウォール機能は運用時の入出力データをさまざまな視点から自動で評価テストし、不正データ、異常値、悪意のある危険なデータなどをブロックしたり、レビュー用にタグ付けしてアラートを上げます。

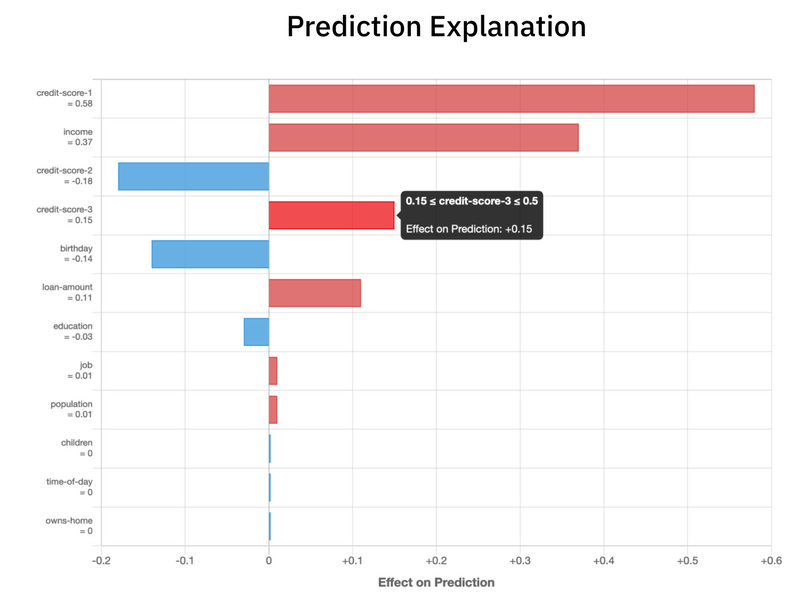

さらに、お客様のAIの思考過程を可視化。推論結果に対する説明根拠を提示します。AIの学習時に生じたバイアスや推論時のモデルの脆弱性等を検知し、品質改善に役立てることができます。「AIの思考過程を分かりやすく説明したり、デバッグするのは容易でない」「AIのバージョン入れ替えや、A/Bテストを実施した場合、予期せぬ結果が出てしまう」という悩みを持った方に可視化機能はおすすめです。

「Citadel Radar」のデモの申し込みはCitadel AIのホームページにて受け付けています。

出典:PR TIMES

業務の課題解決に繋がる最新DX・情報をお届けいたします。

メールマガジンの配信をご希望の方は、下記フォームよりご登録ください。登録無料です。

AI製品・ソリューションの掲載を

希望される企業様はこちら