生成AI

最終更新日:2025/06/10

活性化関数とは

活性化関数とは

機械学習や深層学習(ディープラーニング)において、モデルの性能を左右する重要な要素の一つが「活性化関数」です。ニューラルネットワークの各層で出力される値に非線形性を付与することで、より高度なパターン認識を実現する役割を担っています。

本記事では、活性化関数の基本的な仕組みから、代表的な種類、それぞれの特徴、選び方、導入時の注意点、活用事例まで、専門的な観点から詳しく解説します。

活性化関数(Activation Function)とは、ニューラルネットワークの各ノード(ニューロン)で適用される数学的関数のことです。これにより、入力データがどのように変換されるかが決まります。

活性化関数の目的とは、以下のような点があります。

活性化関数にはさまざまな種類があり、それぞれ異なる特性を持ちます。

数式:f(x) = 1 if x ≥ 0, else 0

ある閾値を超えた入力に対して出力が1、それ以外は0になるという非常にシンプルな関数です。計算が容易である点が利点ですが、微分不可能なため、誤差逆伝播法を用いた学習には適していません。そのため、現在のディープラーニングではほとんど使われていません。

数式:f(x) = 1 / (1 + e^(-x))

出力を0〜1の範囲にスケーリングする関数で、確率的な解釈が可能な場面で活用されます。非線形性を導入できるという点で有用ですが、入力が大きくなると勾配が小さくなり、学習が進みにくくなる「勾配消失問題」が発生しやすいというデメリットがあります。

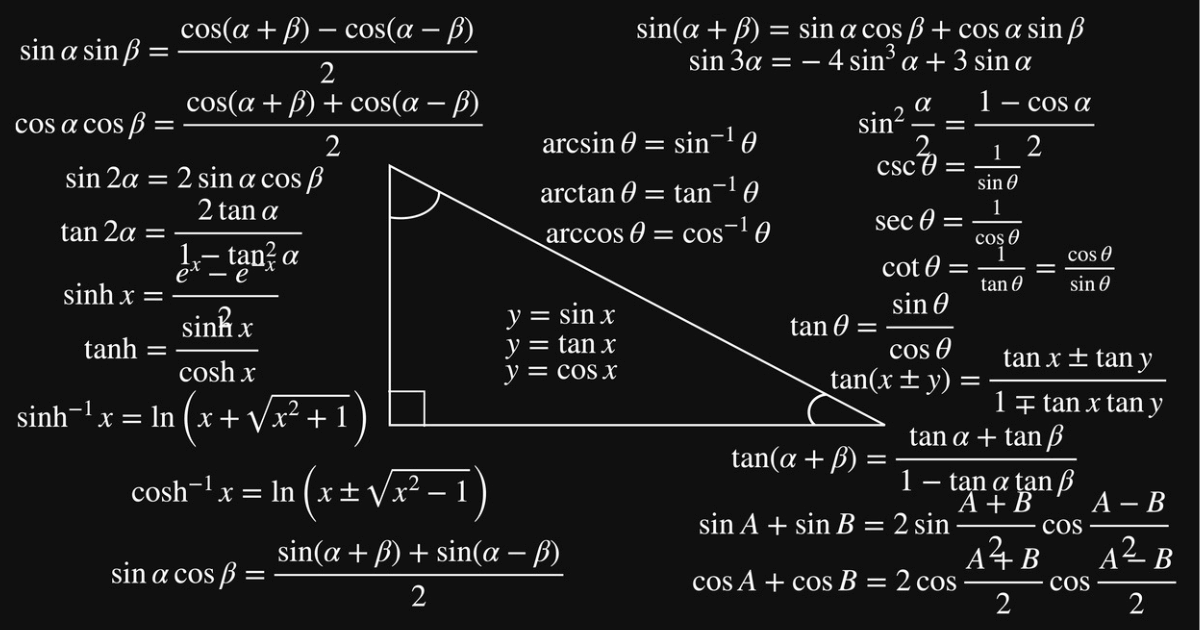

数式:f(x) = tanh(x)

出力を-1〜1にスケーリングし、Sigmoidよりも中心対称性があるため、出力の平均がゼロに近くなるという特徴があります。これにより学習が安定しやすくなりますが、極端な入力に対してはやはり勾配消失が発生するリスクがあります。

数式:f(x) = max(0, x)

0以下の入力を0にし、0より大きい入力はそのまま出力する関数です。計算がシンプルでありながら勾配消失の問題を軽減できるため、現在の深層学習において最も広く使われています。ただし、負の入力に対して常に0を出力するため、ニューロンが「死ぬ」問題が生じることがあります。

数式:f(x) = x if x ≥ 0, else αx (α=0.01など)

ReLUの変種で、負の入力にも小さな傾きを持たせることで「死んだReLU」問題を緩和します。パラメータ(通常0.01など)の調整が必要となるため、設計時に工夫が求められます。

数式:f(x) = x * sigmoid(βx)

Googleが提案した関数で、入力に対して滑らかに非線形変換を行います。ReLUよりも表現力が高く、学習が進みやすいという特性がありますが、計算コストがやや高くなる傾向があります。

数式:f(x_i) = e^(x_i) / Σ e^(x_j)

主に分類タスクの出力層で使われ、各出力を確率として解釈できるように変換する関数です。複数クラスの分類においては標準的に用いられていますが、指数関数を含むため計算量が多くなるという側面もあります。

数式:f(x) = x * Φ(x)

Transformer系モデルなどで多く採用されている関数で、入力に対して滑らかな非線形変換を提供します。実験的にはReLUよりも高い性能を示すケースもあり、高度な文脈理解が求められる自然言語処理で特に有効です。

適切な活性化関数を選ぶことは、モデルの性能向上において非常に重要です。

| 活性化関数 | 主な用途 | メリット | デメリット |

|---|---|---|---|

| ステップ関数 | 古典的なパーセプトロン | 計算が単純 | 学習に不適 |

| シグモイド | 出力を確率的に扱う | 直感的に理解しやすい | 勾配消失問題 |

| tanh | 隠れ層での使用 | シグモイドよりも有効 | やはり勾配消失 |

| ReLU | 深層学習の標準 | 計算効率が高い | 死んだReLU問題 |

| Leaky ReLU | ReLUの改良版 | 勾配がゼロにならない | ハイパーパラメータ調整が必要 |

| Swish | 最新の研究向け | 滑らかで学習しやすい | 計算負荷が高い |

| Softmax | 多クラス分類 | 出力が確率になる | 計算コストが高い |

浅いネットワークではTanhやSigmoidも機能しますが、深いネットワークではReLUやGELUのような勾配消失に強い関数が推奨されます。

分類問題や回帰問題など、タスクに応じて出力の性質を考慮することが重要です。例えば、2クラス分類ではSigmoid、マルチクラス分類ではSoftmaxが最終層に使われます。その一方で、リアルタイム処理を要するアプリケーションでは、計算コストの低いReLU系が適しているケースが多くあります。

活性化関数については、以下のような場所で使われています。

畳み込みニューラルネットワーク(CNN)では、ReLUが一般的に使用されます。ResNetやVGGといった画像認識モデルでは、ReLUやその派生関数が標準的に使用され、高精度な画像分類を支えています。

再帰型ニューラルネットワーク(RNN)やトランスフォーマーモデルでは、Softmaxが出力層に使われます。また、BERTやGPTなどのモデルでは、GELUが用いられており、複雑な文脈理解を可能にしています。

tanhやLeaky ReLUが、データの異常点を識別するモデルで活用されます。

Googleの音声アシスタントでは、ReLUやSwishを含む深層ネットワークを活用することで、高精度な音声認識を実現しています。

活性化関数を導入する際は、いくつか注意点があります。その注意点について解説しましょう。

深層ニューラルネットワークでは、層が深くなるにつれて誤差逆伝播時の勾配が非常に小さく(勾配消失)または極端に大きく(勾配爆発)なってしまうことがあります。特にSigmoidやTanhといったS字型の関数は、入力が大きくなると出力の変化がほとんどなくなり、結果として勾配がほぼゼロになります。これにより、学習が進まなくなる重大な問題が発生します。

こうした問題を未然に防ぐためには、ReLU系の活性化関数を活用したり、ネットワークの初期化方法を工夫する必要があります。特に深層モデルでは、このような勾配の問題が発生しやすいため、選定時には十分な注意が必要です。

ReLUは計算が非常に効率的である一方、0以下の入力に対して常に0を出力します。このため、学習の過程であるニューロンの入力がずっと負の値になってしまうと、そのニューロンの出力が常に0となり、以後の学習にまったく寄与しなくなってしまいます。これがいわゆる「死んだニューロン(Dead Neuron)」の問題です。

ニューロンが死んでしまうと、ネットワーク全体の表現力が低下し、期待した性能が出ない可能性があります。このリスクを回避するためには、Leaky ReLUやParametric ReLU(PReLU)のように、負の入力にも微小な出力を許容する関数を使用することが推奨されます。

活性化関数単体では、学習の安定性や速度に限界があります。特に、層が深いモデルでは、層ごとの出力分布が大きく変化してしまう「内部共変量シフト(Internal Covariate Shift)」が発生することが知られており、これが学習の不安定さにつながります。

この問題を緩和する手法の一つがバッチ正規化(Batch Normalization)です。活性化関数の前後にバッチ正規化を入れることで、出力のスケーリングとシフトが調整され、より安定した学習が可能になります。特にReLUやSwishとの組み合わせで有効性が高く、収束速度の向上や過学習の抑制にもつながります。

活性化関数は、AIモデルの性能に直結する重要な要素であり、用途やモデル構造に応じて最適な関数を選定する必要があります。ReLU系が現在の主流とはいえ、用途によってはSwishやGELUといった新しい関数が有効な場合もあります。導入時には、勾配の問題や計算コストを考慮しながら、他の手法と組み合わせて総合的に性能向上を目指すことが求められます。

アイスマイリーでは、AI開発支援サービスとその提供企業の一覧を無料配布しています。自社でのAI導入やアルゴリズム最適化に活用できる、最適なAIサービスを選定するためにぜひご活用ください。

業務の課題解決に繋がる最新DX・情報をお届けいたします。

メールマガジンの配信をご希望の方は、下記フォームよりご登録ください。登録無料です。

AI製品・ソリューションの掲載を

希望される企業様はこちら