生成AI

最終更新日:2024/10/28

Llamaとは?

Llamaとは?

現在、AIを利用しながら少しずつ理解を深めている中で、新しい大規模言語モデルがリリースされると聞いて、その内容がどのようなものであるかを早く知りたいと思う方はいませんか?

より高度な言語理解を実現する大規模言語モデルが進化するほど、生成AIはよりユーザーにとって使いやすくなるといえます。

本記事では、Meta社の新しい大規模言語モデルLlamaの性能から使い方まで詳しく解説します。

Llama(ラマ)は、Meta社が開発したオープンソースの大規模言語モデル(LLM)です。

一般的なオープンソースの大規模言語モデルでは以下のようなことができます。

Meta社はLlamaを2023年2月、Llama2を2023年7月に公開し、少しずつその性能を進化させてきました。

Meta社では、Llama3を「最先端のオープンソース大規模言語モデルの次世代版」と位置付けており、その性能や使い方に注目が集まっています。

参考:Meta「Metaとマイクロソフト、 次世代Llamaを発表」

2024年4月18日、Meta社より「Meta Llama 3のご紹介:これまでで最も有能でオープンに利用可能なLLM」というタイトルでLlama3の詳細が発表されました。

発表の中で、Meta社はLlama3の近い将来の目標を次の3つとしています。

この目標を踏まえて、Llama3の性能の特徴を3つ紹介します。

Meta社が公表しているLlama3の仕様は次の通りです。

| 項目 | 概要 |

| モデル | ●8B(軽量で超高速、80億パラメータを持つ) ●70B(高性能で費用対効果が高く700億パラメータを持つ) ●405B(2024年7月23日に発表された最上位モデルで4,050億パラメータを持つ) |

| 使用可能となるプラットフォーム | ●AWS ●Databricks ●Google Cloud ●Hugging Face ●Kaggle ●IBM WatsonX ●Microsoft Azure ●NVIDIA NIM ●Snowflake |

| サポートされている言語 | ●英語 ●ドイツ語 ●フランス語 ●イタリア語 ●ポルトガル語 ●ヒンディー語 ●スペイン語 ●タイ語 |

| 一度に処理できるコンテキストの長さ | ●128K(128,000トークン分の情報を処理できる) |

またLlama3は、AIモデルのトレーニングを行うために特別に設計された大量の計算能力を持つGPUクラスター(GPUの集まり)で、15兆以上のトークンを用いてトレーニングされました。

それぞれのモデルをトレーニングするために使われたGPUの時間は次の通りです。

| モデルの種類 | GPU時間 |

| 8B | 146万時間 |

| 70B | 700万時間 |

| 405B | 3084万時間 |

これらを踏まえLlama 3は、圧倒的な規模と高度なトレーニングを通じて、最先端のAI技術を実現しているといえます。

画像出典:Meta「Meta Llama 3のご紹介:これまでで最も有能でオープンに利用可能なLLM」

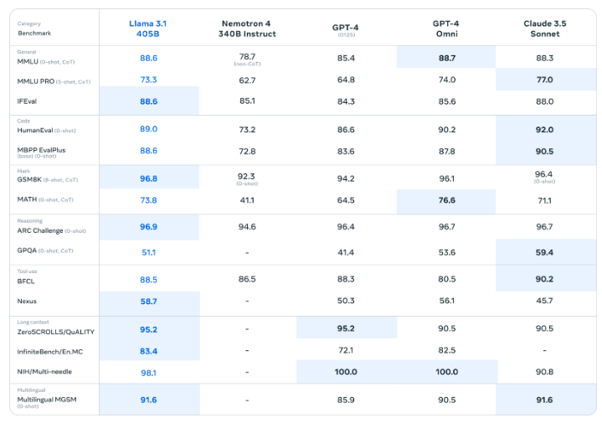

画像出典:Meta「Llama 3.1のご紹介:これまでで最も高性能なモデル」

Meta社では、AIモデルや機械学習システムの性能を評価するための基準や指標となる、ベンチマークを用いて評価したLlama 3の性能を公開しています。

比較に使用されている主なベンチマークの概要は次の通りです。

| ベンチマークの種類 | 概要 |

| MMLU(Massive Multitask Language Understanding) | テキスト理解や言語処理のパフォーマンスを評価することを目的に設計されており、初等数学、米国史、コンピュータサイエンス、法律といった57種類の課題がある |

| GPQA(General Purpose Question Answering) | 大学院レベルの専門的な知識と論理的思考を必要とする質問をすることでAIモデルの性能を評価する |

| HumanEval | AIモデルがどの程度プログラムを書けるかを測定する |

| GSM-8K | 8.5Kの高品質な言語学的多様性を持つ小学校数学の単語問題 |

| MATH(Mathematics Benchmark) | AIモデルの数学的な能力を評価する |

3つのモデルの中でも、最も目を惹く結果を出しているのが8Bで、HumanEval、GSM-8K、MATHの比較で他のAIの2倍以上の数値となっているため、論理的思考に優れ数学的な能力が高いのが特徴的です。

画像出典:Meta「Meta Llama 3のご紹介:これまでで最も有能でオープンに利用可能なLLM」

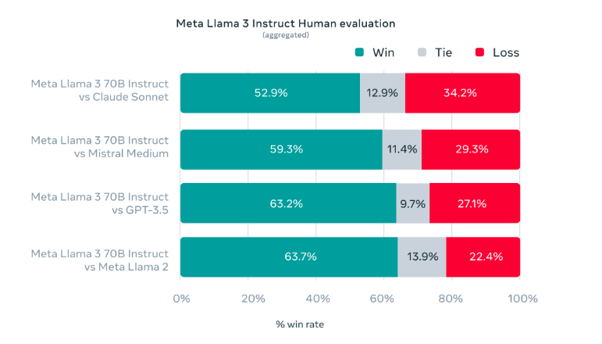

表は、Llama 3と他のAIモデルをHuman evaluationで比較したものです。

Human evaluationとは、AIや機械学習モデルが生成した結果や応答を人間が評価することを指します。次のような観点から評価が行われることが多いです。

Llama3は他のAIと比較して半数以上の人が優れていると評価したため、ユーザー体験や使用感に優れているといえます。

Llama 3は「Meta AI」に搭載されていますが、2024年9月現在、日本では画像の通りMeta AIを使うことができません。

そのため、AIプラットフォームでLlama3が搭載されたものを使う必要があります。以下では、主な使い方を3つ紹介します。

2024年7月23日、GroqはLPU AI推論テクノロジーを搭載したLlama 3.1モデルを発売しました。

LPU AI推論テクノロジーを用いることで、Llama3は高速で動作するため、その機能を活用して、ユーザーはより高度で強力なAIアプリケーションを作れるようになります。

OpenAIなどの他のプロバイダからGroqに移行する手順は次の通りです。

Groqを通じてLlama3を使うのは、AIモデルを研究したり、新しいAI製品の開発に取り組んだりしている人におすすめです。

Hugging Faceでは8B、70B、405Bそれぞれにデモ画面が準備されているので、まずはそこから試してみるとよいでしょう。

Hugging Faceを通じてLlama3を使うのは、難しいコードを書かずに8B、70B、405Bそれぞれの違いを比較検討してみたい人におすすめです。

Amazon Bedrockは、AIや機械学習モデルの構築や導入を簡単にするためのプラットフォームですが、8B、70B、405Bいずれも使用できます。

Amazon Bedrock コンソールでMetaのLlama 3.1モデルをテストする場合の手順は次の通りです。

Amazon Bedrockを通じてLlama3を使うのは、AIや機械学習モデルの構築・導入・運用をより効率的に行いたい人におすすめです。

Llama3、ChatGPT、Geminiそれぞれの違いは次の通りです。

| 項目 | ●Lama3 | ●ChatGPT | ●Gemini |

| 提供元 | ●Meta | ●OpenAI | |

| 分類 | ●大規模言語モデル | ●生成AI | ●生成AI |

| 主な機能 | ●自然言語処理 ●生成 ●翻訳 ●要約 |

●会話生成 ●質問応答 ●文章生成 |

●自然言語処理 ●生成 ●理解 ●質問応答 |

| 特徴 | ●高性能 ●オープンソース |

●自然な会話ができる ●継続的に学習する |

●マルチモーダルモデル ●Googleの他のサービスと連携しやすい |

| 対応言語 | ●英語 ●ドイツ語 ●フランス語 ●イタリア語 |

●80以上に対応 | ●40以上に対応 |

| 価格 | 100万トークンあたりの公開価格 | 無料以外に3種類の料金プランあり | 無料と有料のプランあり |

AIユーザーであれば耳にしたことのあるものばかりですが、それぞれでできることや特徴が異なります。

Llama3はそのままでも日本語で使うこと自体は可能ですが、よりスムーズに使いたければ日本語継続事前学習モデルの導入がおすすめです。以下、モデルを3つ紹介します。

2024年4月に、rinna株式会社が発表したのがLlama 3 Youko 8Bで、8Bに対して日本語と英語の学習データ220億トークンを用いて継続事前学習したモデルです。

rinnaでは、日本語言語モデルの性能を評価するためのベンチマークの一つであるStability-AI/lm-evaluation-harnessで8BとLlama 3 Youko 8Bを比較したところ、9タスク平均スコアは8Bが59.82だったのに対し、Llama 3 Youko 8Bは66.15でした。

Llama 3 Youko 8Bは、軽量で超高速な8Bを日本語で運用したい人におすすめです。

2024年7月1日に、東京工業大学と国立研究開発法人産業技術総合研究所が共同開発をして発表したのがLlama-3-Swallowです。

Llama-3-Swallowは継続事前学習を施し、高い日本語性能と英語性能の両方を持つモデルとして開発され、今までの知見を生かし日本語性能を効率的に向上させつつ英語性能を損ねないように配慮されています。

8Bと70Bに対応していますが、東京工業大学と国立研究開発法人産業技術総合研究所ではまだ研究課題はたくさんあるため、今後もより日本語に強いモデル開発に取り組むとしています。

Llama-3-Swallowは、日本語と英語の両方をバランス良く使いながらLlama 3を運用したい人におすすめです。

cyberagent/Llama-3.1-70Bは、2024年7月26日に株式会社サイバーエージェントが発表した70B対応の日本語継続事前学習モデルで、HuggingFaceからダウンロードでき、無料で使えて商用利用もできるのが特徴的です。

Llama 3の発表からわずか2日後に公開されたため、SNSなどでもその早さに驚きの声が上がりました。

cyberagent/Llama-3.1-70Bは、コストをかけずに新しいAIサービスを開発したい人におすすめです。

Llamaは、Meta社が開発したオープンソースの大規模言語モデルです。

まだ日本ではMeta AIを通じて使うことはできませんが、8B、70B、405Bと種類が増え、日本語継続事前学習モデルの開発も行われているため、今後さらなる進化が期待できます。

本記事も参考にして、Llamaに対する理解を少しずつ深めてみることをおすすめします。

業務の課題解決に繋がる最新DX・情報をお届けいたします。

メールマガジンの配信をご希望の方は、下記フォームよりご登録ください。登録無料です。

AI製品・ソリューションの掲載を

希望される企業様はこちら