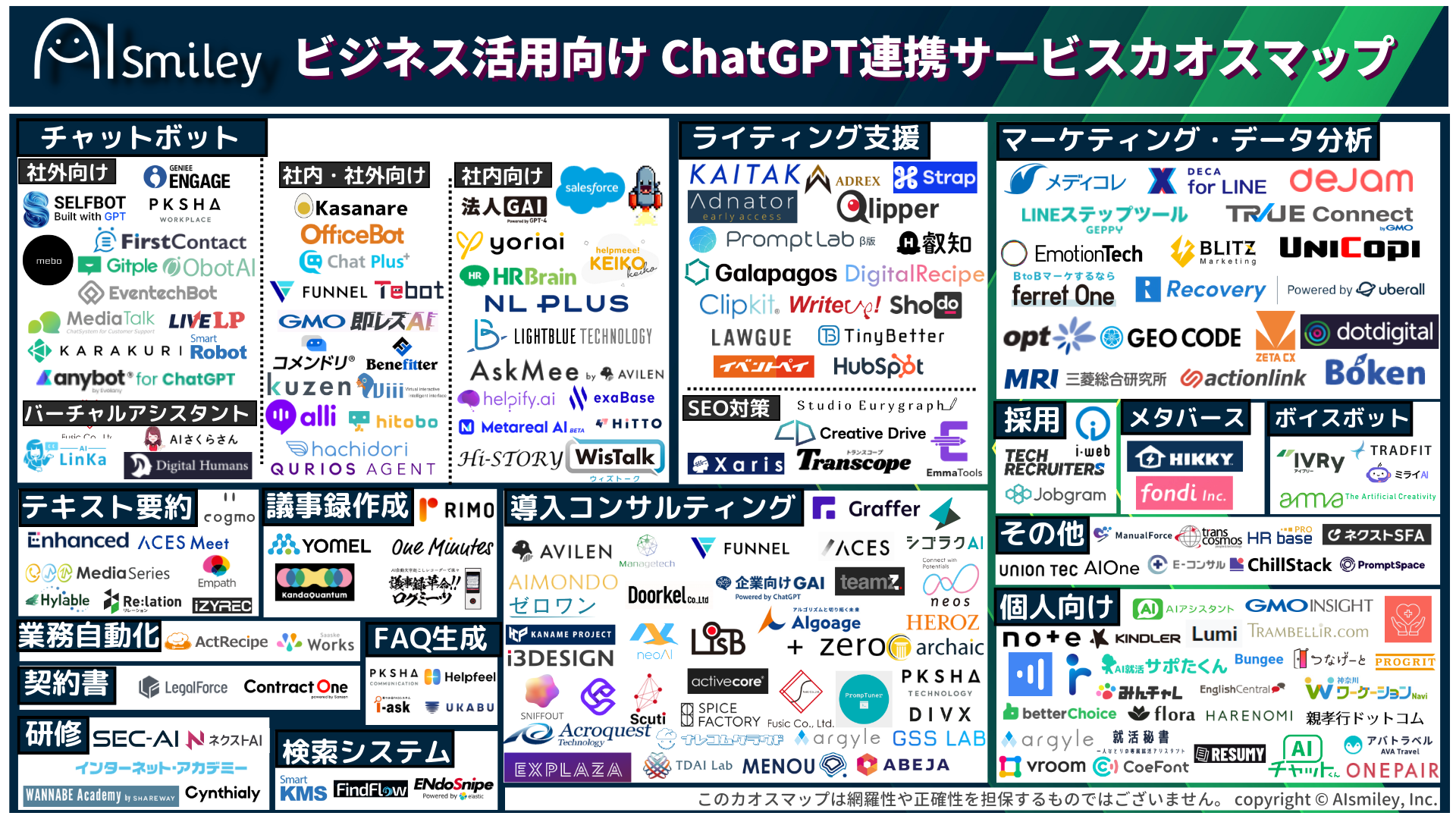

ChatGPT連携サービス

生成AI

生成AI

ChatGPT連携サービス

ChatGPT連携サービス

AI受託開発

AI受託開発

対話型AI -Conversational AI-

対話型AI -Conversational AI-

ボイスボット

ボイスボット

バーチャルヒューマン

バーチャルヒューマン

教師データ作成

教師データ作成

ナレッジマネジメントツール

ナレッジマネジメントツール

AI研究開発

AI研究開発

通訳・翻訳

通訳・翻訳

声紋認証

声紋認証

機密情報共有・管理

機密情報共有・管理

契約書管理システム

契約書管理システム

ワークステーション

ワークステーション

FAQシステム

FAQシステム

AIカメラ

AIカメラ

生体認証

生体認証

インボイス制度対応システム

インボイス制度対応システム

データセットの収集・購入

データセットの収集・購入

コールセンター

コールセンター

人事・総務向け

人事・総務向け

インバウンド対策

インバウンド対策

コンバージョンアップ

コンバージョンアップ

KYT・危険予知で労働災害防止

KYT・危険予知で労働災害防止

無料AI活用

無料AI活用

顧客リスト自動生成

顧客リスト自動生成

ロボットで自動化

ロボットで自動化

LINE連携

LINE連携

セキュリティー強化

セキュリティー強化

テレワーク導入

テレワーク導入

AI学習データ作成

AI学習データ作成

配送ルート最適化

配送ルート最適化

非接触AI

非接触AI

受付をAIで自動化、効率化

受付をAIで自動化、効率化

AIリテラシーの向上サービス

AIリテラシーの向上サービス

日本語の手書き文字対応AI-OCR

日本語の手書き文字対応AI-OCR

Windows作業の自動化RPAツール

Windows作業の自動化RPAツール

リスク分析AIで与信管理

リスク分析AIで与信管理

紙帳票仕分けAI-OCRサービス

紙帳票仕分けAI-OCRサービス

サプライチェーン

サプライチェーン

自治体向けAI

自治体向けAI

AIコンサルティング

AIコンサルティング

最終更新日:2024/05/13

rinnaは、日本語特化モデル「Llama 3 Youko 8B」を公開しました。Llama 3の優れた性能が日本語で引き継がれます。

このAIニュースのポイント

rinna株式会社は、Llama 3 8Bに対して日本語データで継続事前学習を行った「Llama 3 Youko 8B」を開発し、Meta Llama 3 Community Licenseで公開したと発表しました。

AI技術の発展の中で、Meta社のLlama 3やMicrosoft社のPhi-3、Apple社のOpenELMといった、高いテキスト生成能力を持った大規模言語モデルが利用しやすいライセンスで公開されてきました。しかし、これらのモデルは英語が学習データの大多数を占め、日本語のテキスト生成は可能であるものの、英語と比較すると十分な性能を発揮することができません。

そこでrinnaは、Llama 2やQwenの日本語事前学習で得られた知見を活かし、英語圏の進展に追随するために、Llama 3の日本語継続事前学習モデル「Llama 3 Youko 8B」を開発・公開しました。

「Llama 3 Youko 8B」は、80億パラメータのLlama 3 8Bに対し、日本語と英語の学習データ220億トークンを用いて継続事前学習したモデルです。名前の由来は、妖怪の「妖狐」からきています。

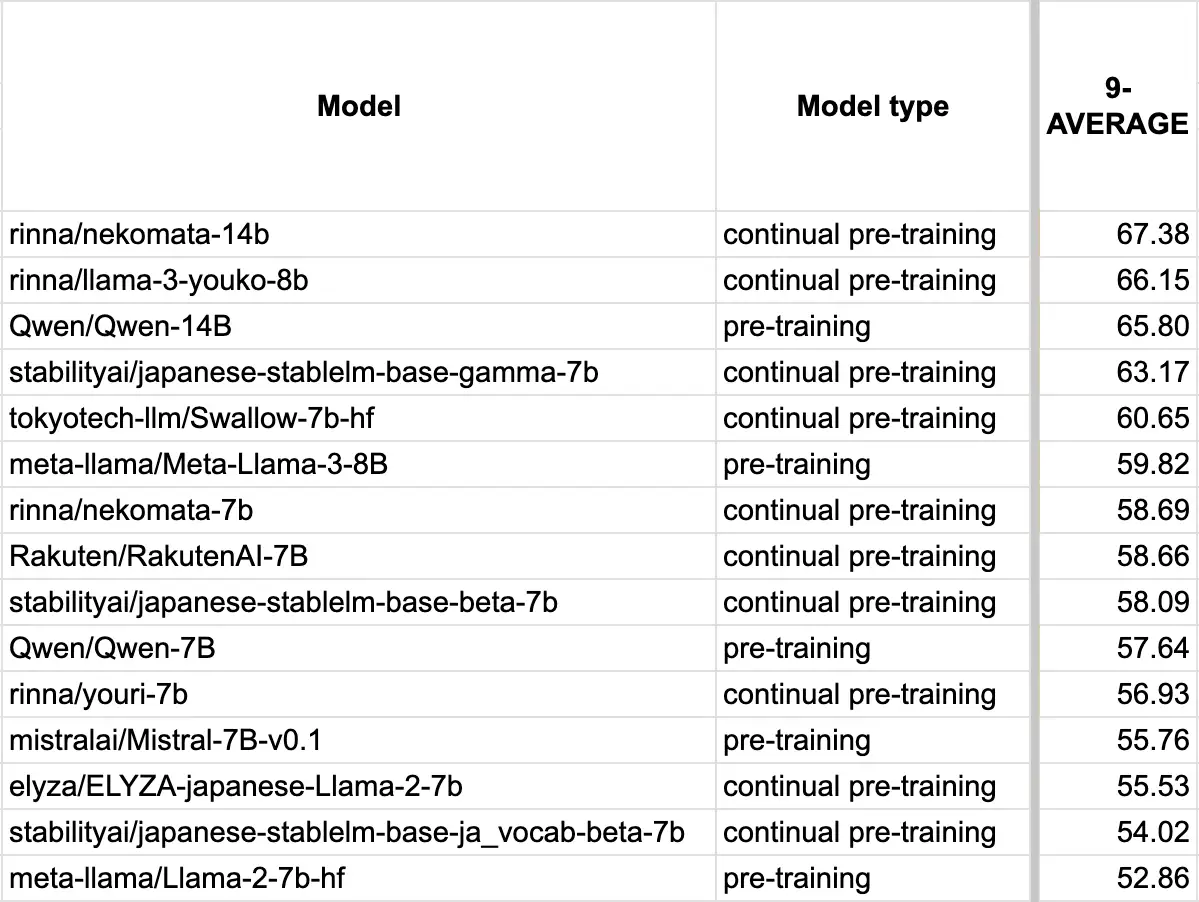

日本語言語モデルの性能を評価するためのベンチマークの一つである Stability-AI/lm-evaluation-harnessの9タスク平均スコアはLlama 3が59.82であるのに対し、Llama 3 Youko 8Bは66.15となっており、Llama 3の優れた性能を日本語に引き継いでいます。

また、本モデルは汎用的なベースモデルであるため、目的とするタスクで利用する場合には、ファインチューニングやモデルマージを行うことが推奨されています。

rinnaは「今後もAIの社会実装を進めるために研究開発を続け、研究成果の公開や製品への導入を行っていく」とコメントしています。

出典:PR TIMES

業務の課題解決に繋がる最新DX・情報をお届けいたします。

メールマガジンの配信をご希望の方は、下記フォームよりご登録ください。登録無料です。

AI製品・ソリューションの掲載を

希望される企業様はこちら